引言

在大语言模型(LLM)的世界中,"Tokens" 是一个几乎无处不在的概念,但你真的了解它们的真正意义吗?当我们与像ChatGPT这样的智能系统互动时,很多人可能只是把Tokens看作是简单的输入和输出单位,然而,它们实际上是构建整个模型运作的关键所在。Tokens不仅决定了模型如何理解、处理和生成语言,它们背后隐藏着深刻的算法和数学原理。那么,Tokens到底是什么?它们是如何影响大语言模型的表现和能力的呢?让我们一起深入探讨,揭开Tokens与大语言模型之间复杂而微妙的关系。

Token与大语言模型

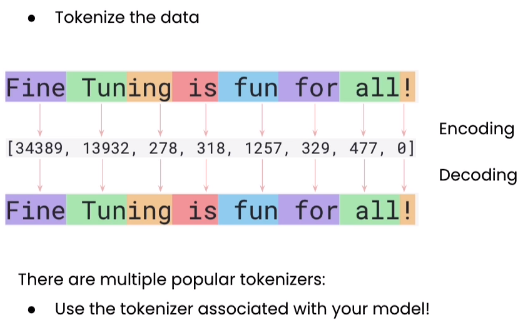

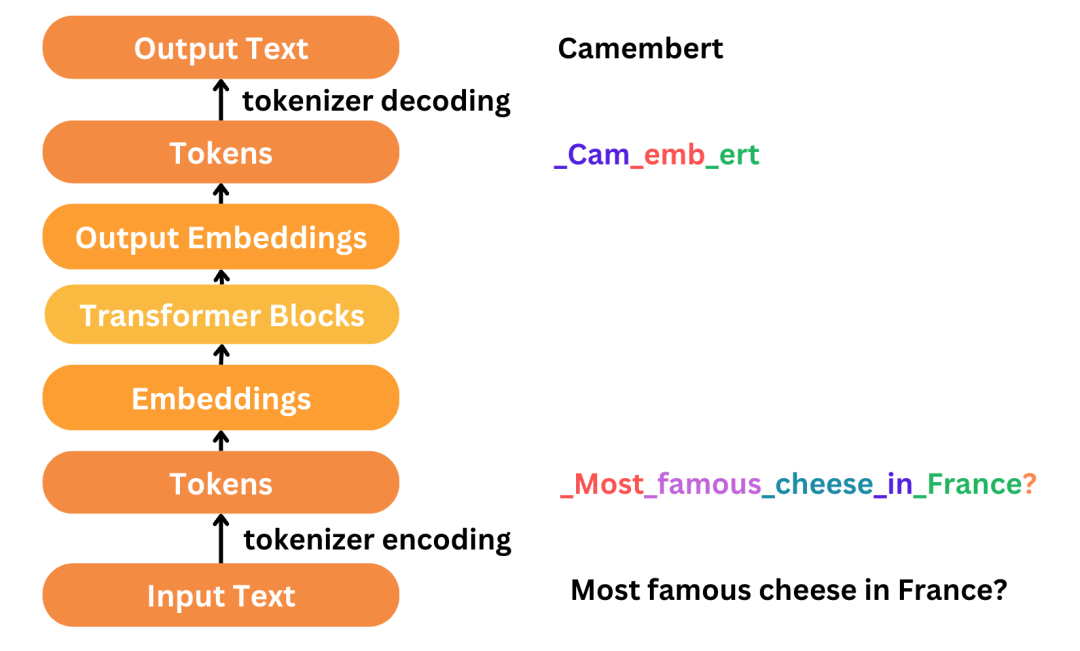

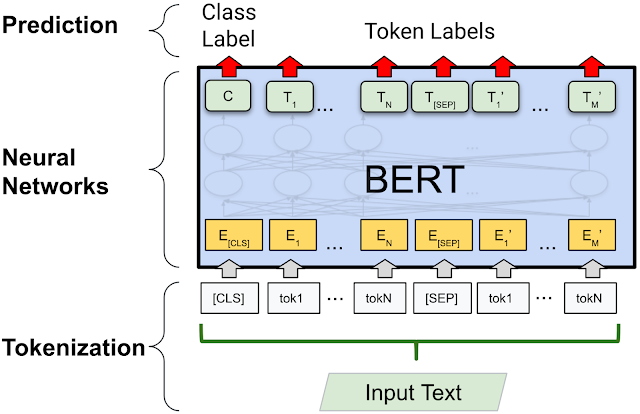

在大语言模型(LLM)中,Token 是处理文本或代码的基本单位。它可以是字符、单词、子单词,甚至是文本段落或代码段,具体形式取决于使用的 token 化(tokenization)算法。通过这个过程,每个 token 都会被分配一个数值 ID,实际处理过程中,模型操作的不是文字本身,而是这些数字化的 ID 标签。

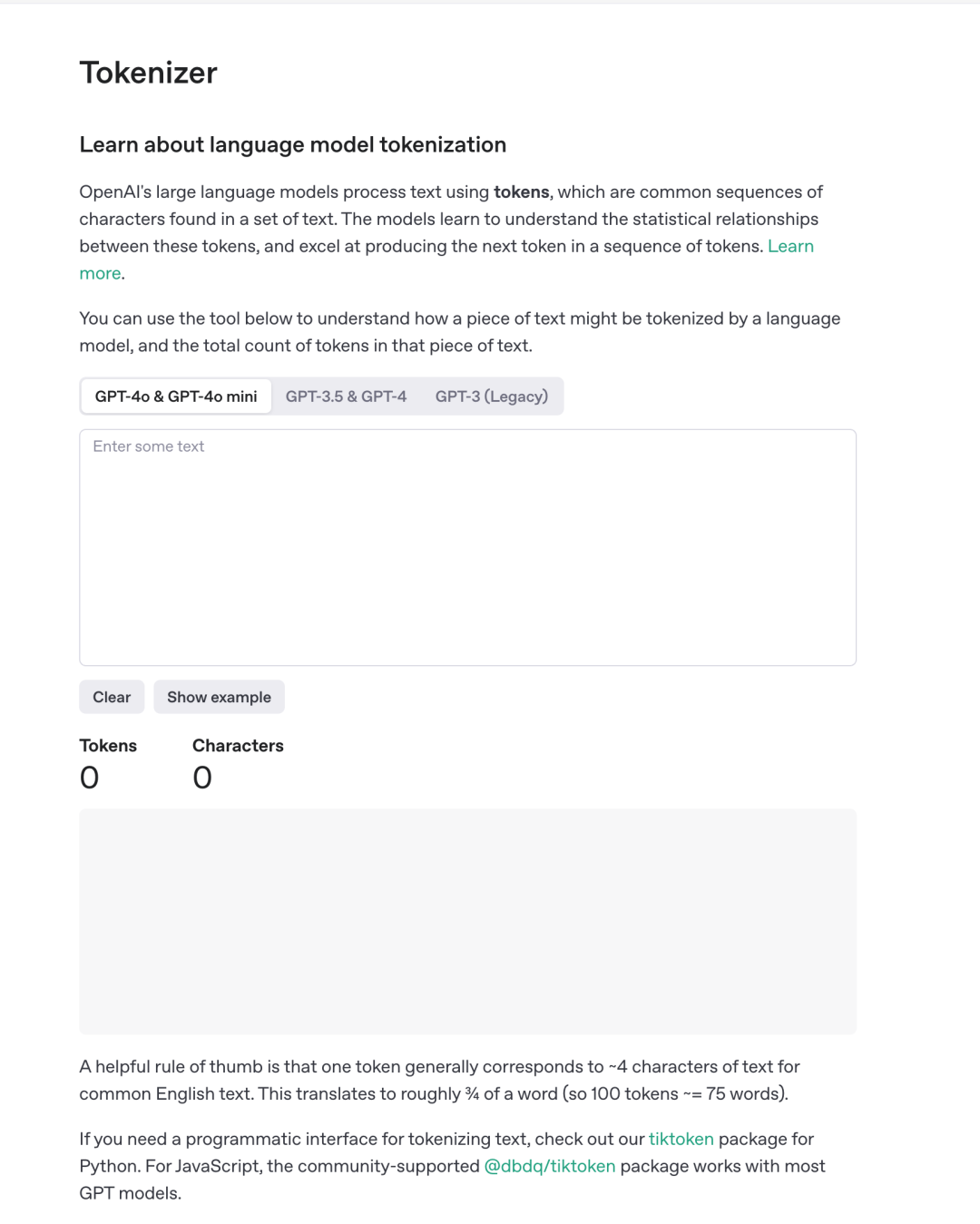

Tokenizer工具

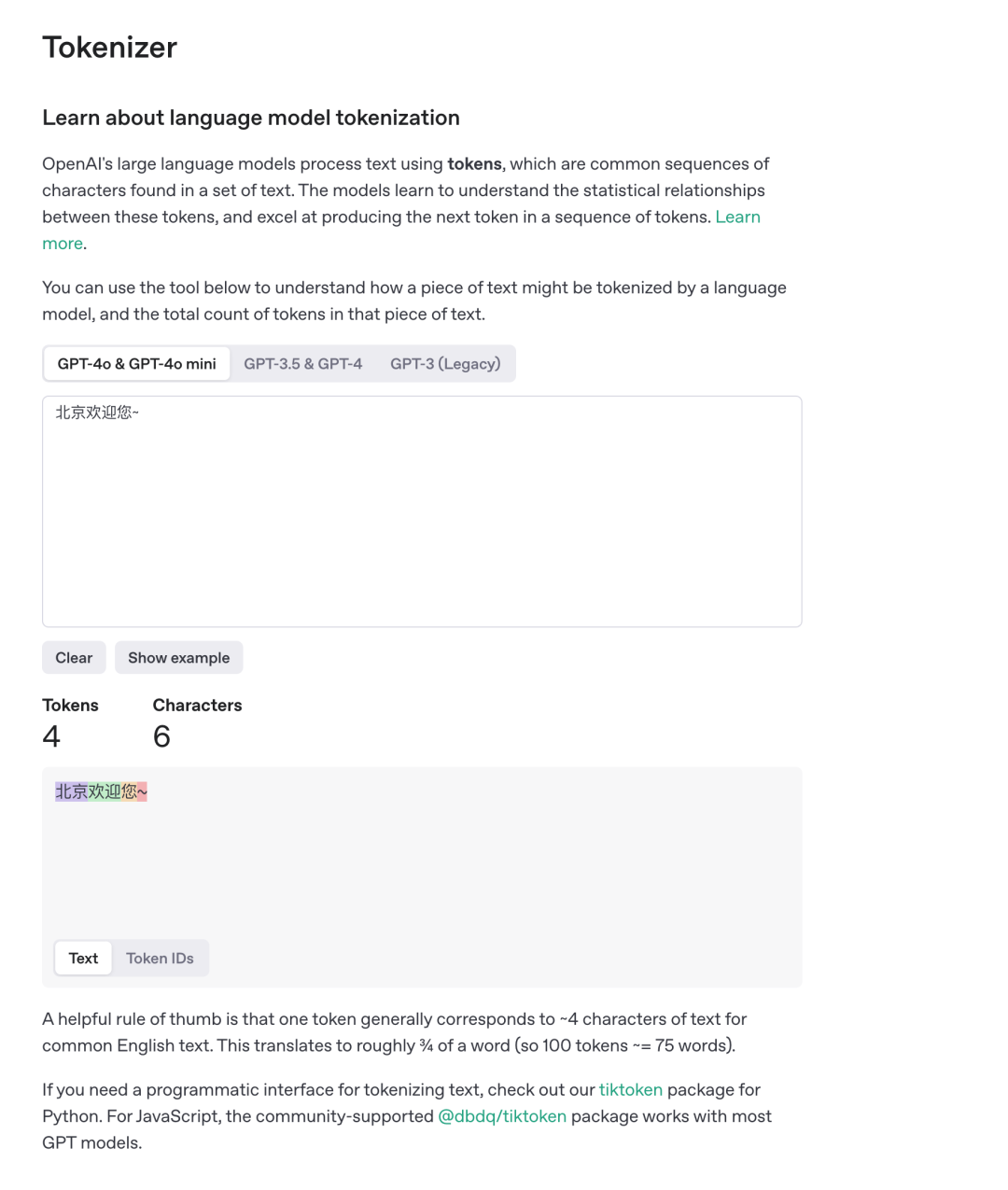

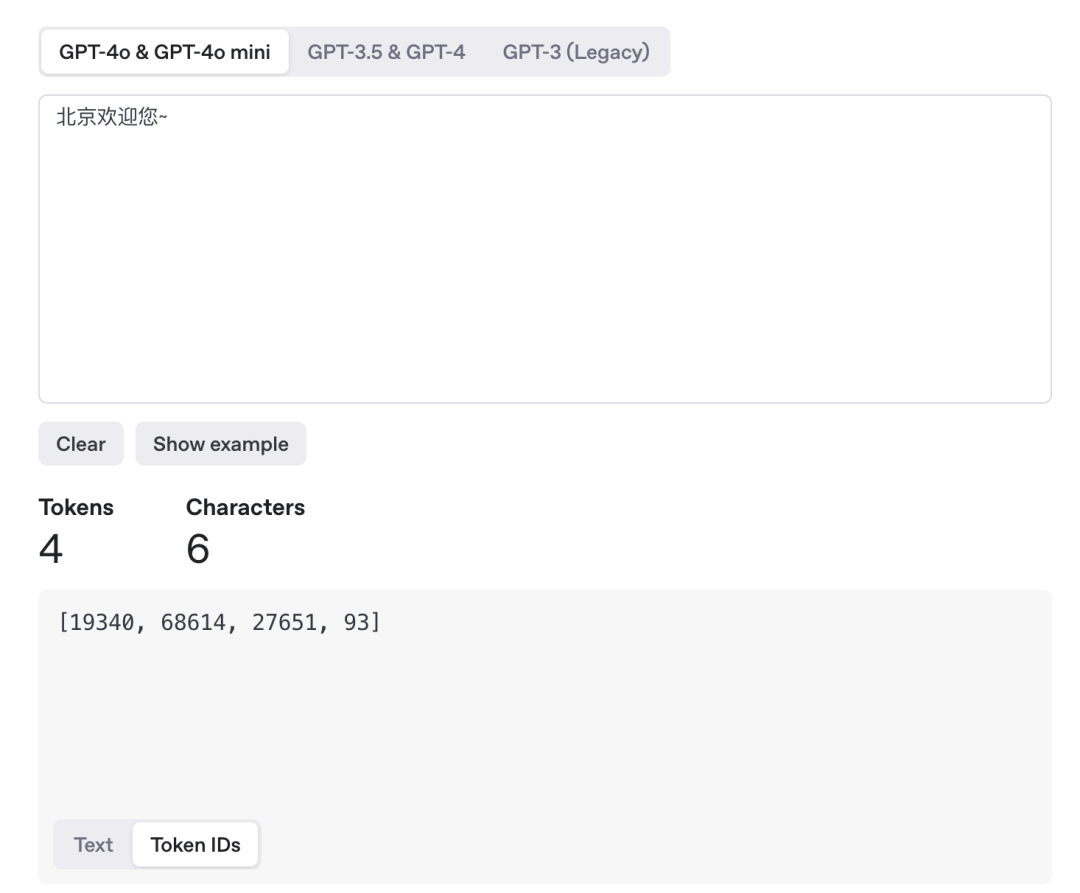

为了更好地理解 token,我们可以使用 DeepSeek 提供的 在线 Tokenizer Tool 进行实践。这款工具能够帮助我们直接查看文本经过 token 化后的具体表现,并展示每个 token 对应的数值 ID。 计算Token工具:https://api-docs.deepseek.com/zh-cn/quickstart/tokenusage 目前DeepSeek只提供离线工具,OpenAI提供在线工具:https://platform.openai.com/tokenizer

示例:

- 原始文本:输入需要 token 化的文本。

- token 化结果:文本经过 token 化后的形式,展示每个 token。

- 各 token 的 ID:每个 token 对应的数值 ID。

OpenAI的Token化

在 DeepSeek中,一个 token 大约等于 4 个英文字母的长度,经过换算,它大概相当于一个单词的长度。此外,DeepSeek 的 tokenizer 也能够处理中文文本,中文 token 化的结果与英文有所不同,并且不同于直接将每个汉字当作一个 token,有时多个汉字组成一个 token。例如,"北京" 被视为一个 token,其对应的 ID 为 70090。

使用OpenAI Tokenizer的代码示例

如果需要在代码中使用 DeepSeek 的 tokenizer,可以通过以下库进行操作:

- Python: 使用

tiktoken - JavaScript: 使用

dqbd/tiktoken

对于其他模型,比如百度的文心大模型,也提供了类似的 token 计算器工具(如“千帆Token计算器”),可以帮助用户计算输入文本的 token 数量。

Tokenization方式

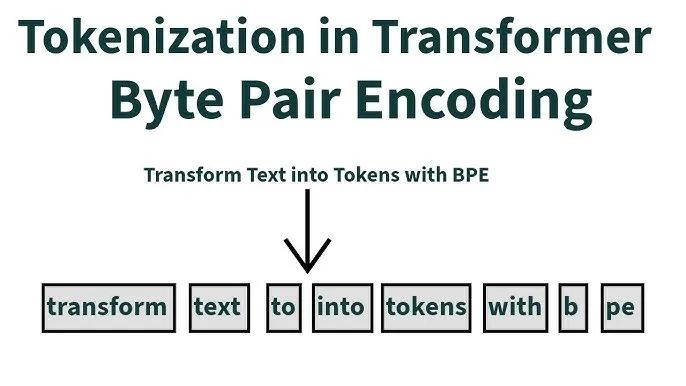

Tokenization 过程即是将文本拆分为更小的单位,这些单位是大语言模型能够理解并处理的基本元素。这个过程对于模型的效率和生成质量至关重要。不同的 Tokenization 方法,影响着模型的表现、处理速度和生成效果。目前,主流的 tokenization 方法包括 BPE(字节对编码)、WordPiece 和 Unigram Language Model。

BPE(字节对编码)

BPE(Byte Pair Encoding)最初是一种数据压缩算法,后被引入到自然语言处理领域。其核心思想是通过合并最常见的字符对来生成新的符号,从而减少文本的长度。在 2015 年,BPE 被广泛应用于 NLP,并且在 2019 年,BBPE(字节级 BPE)应运而生,将原本字符级的 BPE 扩展到字节级。

DeepSeek 使用的 tokenization 方法正是 BPE。它的优势在于能够有效处理稀有词汇或模型未见过的词汇,并通过创建紧凑而一致的文本表示来提升模型生成文本的多样性和表现力。

WordPiece

WordPiece 方法最初是为了处理日语和韩语中的语音问题而提出的,与 BPE 类似,WordPiece 也是通过合并词语单元来构建一个词表。与 BPE 的主要区别在于,WordPiece 是通过计算 token 之间的互信息来决定合并策略,从而更好地平衡词表大小与未知词汇问题(OOV)。

不过,WordPiece 在一些情况下可能会产生不合理的分词,尤其对拼写错误的处理不够强大。

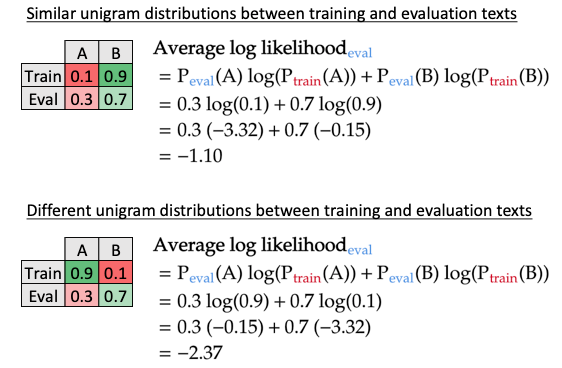

Unigram Language Model

Unigram Language Model 通过计算每个子词单元的损失来确定其在模型中的重要性,从而保留最重要的子词。与其他方法相比,ULM 可以为多种分词结果赋予概率,学习噪音并优化结果。

Token与模型成本的关系

Tokenization 的选择直接影响模型的计算成本。LLM 的处理过程需要依赖于 tokens,而 tokens 数量的增加将直接带来内存和计算资源的增加。特别是对于大语言模型,每个 token 的处理和生成都会消耗一定的成本。

OpenAI模型的成本

以 OpenAI 为例,GPT-4 的费用是 GPT-3 的 10 倍,而 32K 上下文模型的费用是 4K 上下文模型的 2 倍。以下是几个模型的费用比较:

- GPT-3.5-turbo-16k:每 1024 个输入 token 的费用为 0.003$

- GPT-4:每 1024 个输入 token 的费用为 0.03$

- GPT-4-32k:每 1024 个输入 token 的费用为 0.06$

- 文心 4.0 大模型:每 1000 个输入 token 的费用为 0.12¥

- DeepSeek: 每10w输出为8¥

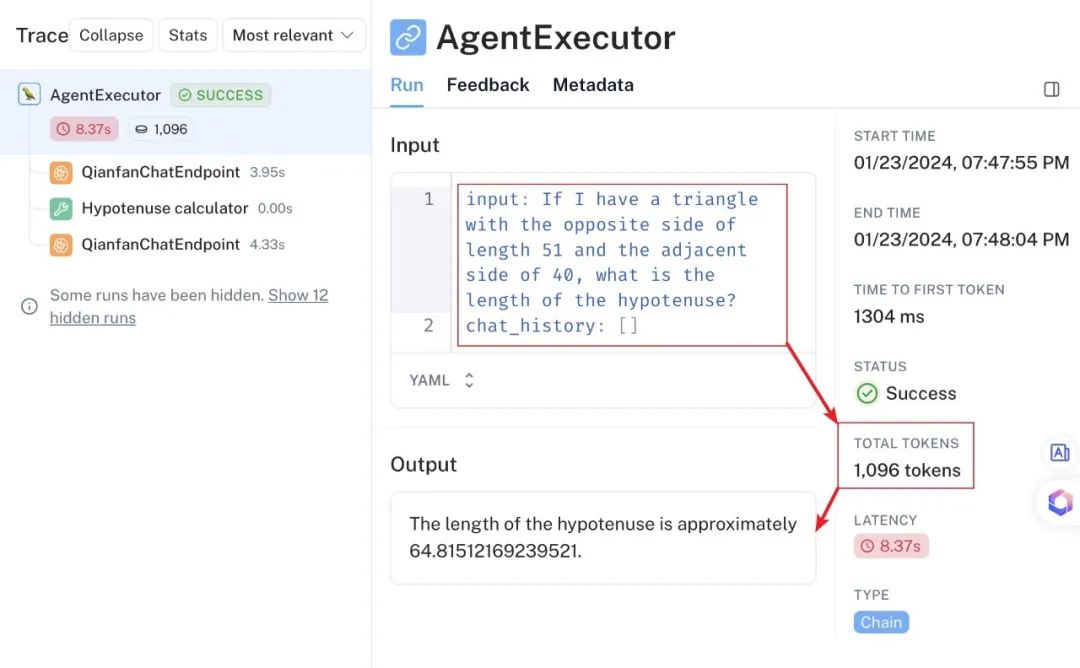

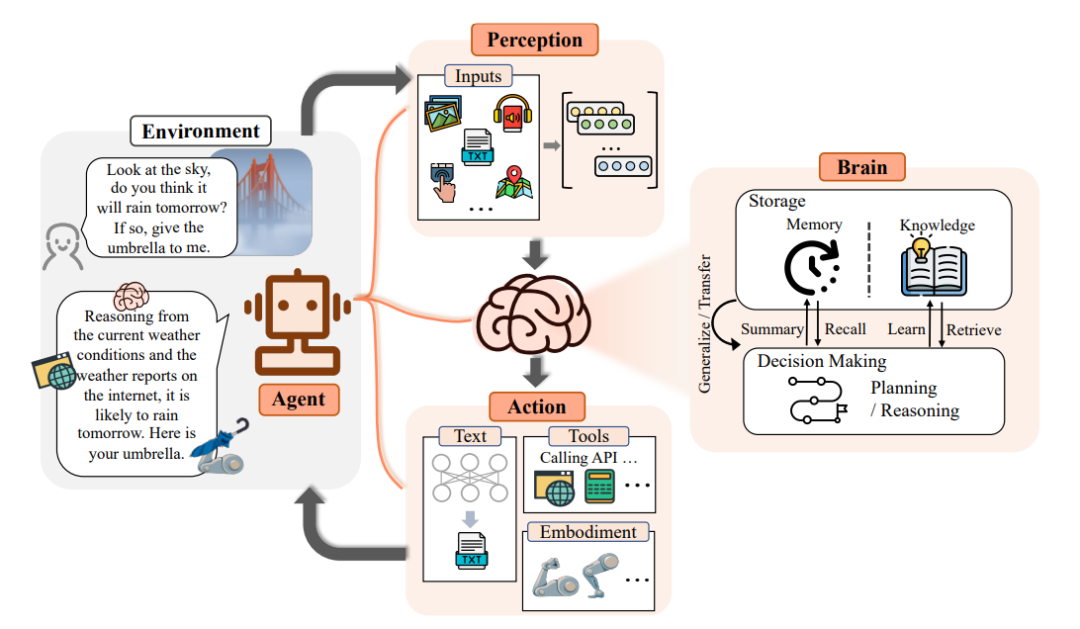

Agent与LLM的交互

在 LLM 与 Agent 的交互过程中,尤其是复杂的提示词模板和多轮交互,会导致 token 数量激增。例如,当 Agent 进行多次与 LLM 的交互时,每次请求和响应都会消耗大量 token,最终导致成本的显著增加。因此,优化 token 使用量和减少不必要的交互成为提升模型效率的关键。

总结

在本文中,我们探讨了Tokens在大语言模型(LLM)中的核心作用及其工作原理。Tokens是LLM处理语言和文本的基本单位,它们不仅影响模型的计算效率,还决定了生成文本的质量和多样性。通过深入理解Token化(tokenization)过程以及与模型成本之间的关系,我们可以更好地掌握如何通过合理的Token设计优化模型的表现。

Tokens是理解和应用大语言模型的基础,掌握Token化的原理及其与模型成本、生成质量的关系,将帮助开发者更好地利用LLM进行高效的文本处理和生成。