最近吴恩达在 LangChain Interrupt 峰会上关于 AI Agent 做了表述。我研读后很欣慰的是整个行业对于企业落地AI的方法路径已经开始慢慢趋同,这是一个很好的信号。

吴恩达的对于AI Agent的表述是:整个AI进入工程时代,构建核心在于任务拆解、流程建模、评估机制与工具认知,而非模型本身。基于吴恩达的核心观点(任务拆解、流程建模、评估机制、工具认知、执行速度),结合我的理解及企业落地AI Agent的最佳实践,总结以下详细路径、模拟案例及实施框架供大家参考:

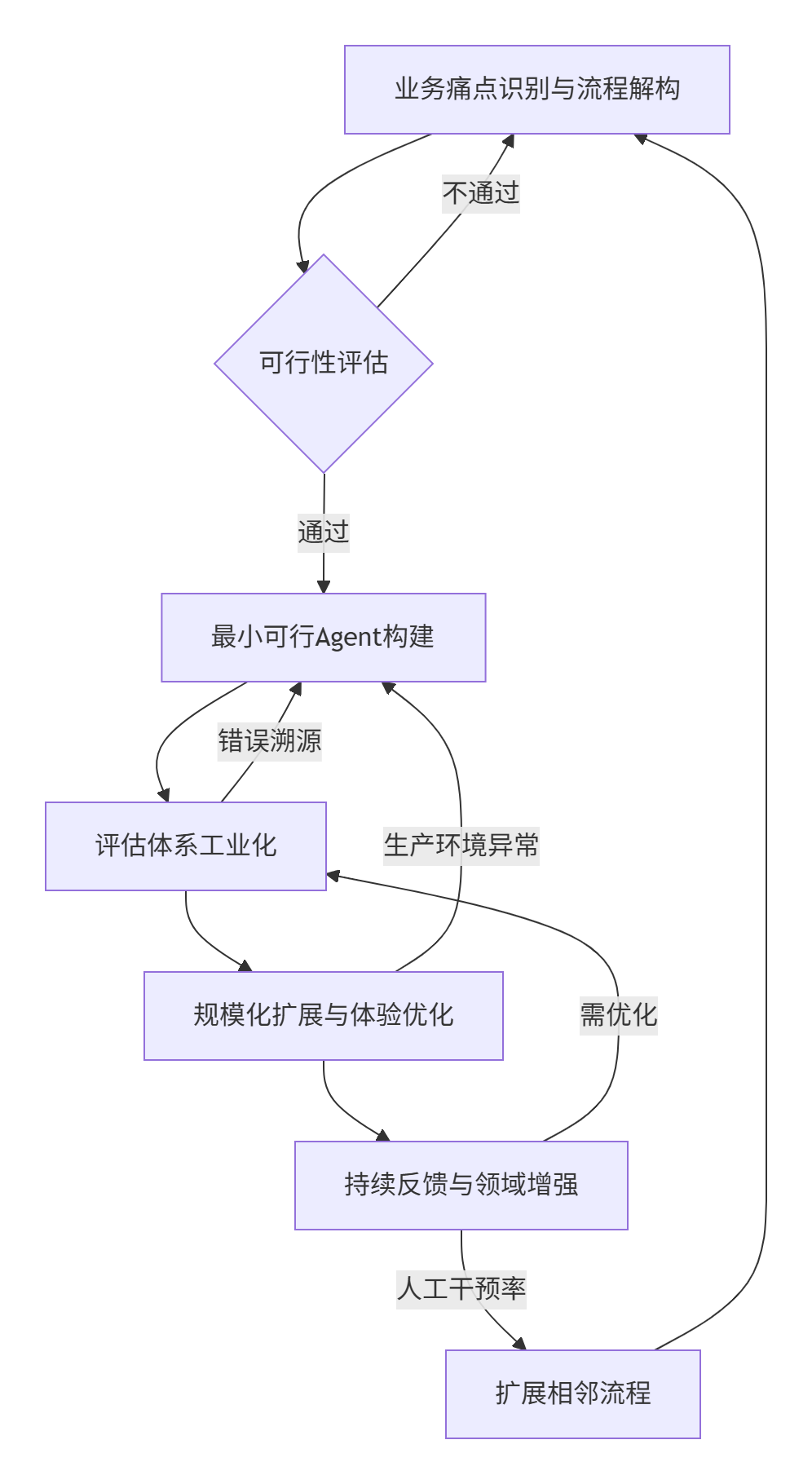

企业AI Agent落地路径详解(五步循环)

步骤1:业务痛点识别与流程解构(谁来做:业务负责人 + 流程专家)

-

做什么: -

识别高重复、规则明确的痛点流程(如合同审查、客服工单处理、报销审核)。 -

绘制当前人工流程图,标注决策点、数据源、参与角色、耗时环节。 -

解构任务粒度:将流程拆分为原子任务(如“提取合同金额”“验证供应商黑名单”“匹配报销政策条款”)。 -

交付物: -

流程拆解文档(含流程图、任务清单、输入/输出定义、失败分支)。 -

可行性评估报告(标注自动化潜力高的环节)。 -

评估标准: -

任务拆解是否覆盖全流程关键节点? -

原子任务是否具备明确输入/输出?(是/否判断或结构化数据) -

迭代点: 若流程复杂度超出预期,退回重新划定首期自动化范围。

步骤2:最小可行Agent(MVA)构建(谁来做:AI工程师 + 领域专家)

-

做什么: -

选择工具链:基于任务类型组合工具(如:LangChain管理流程 + RAG接入知识库 + Guardrail做合规过滤)。 -

构建任务管道:用LangGraph编排原子任务顺序,处理分支逻辑(如合同金额>100万需法务复核)。 -

开发初级评估脚本:针对每个原子任务,编写5-10个测试用例的验证脚本(如用规则引擎检查金额提取是否正确)。 -

交付物: -

MVA原型系统(可处理一条端到端流程)。 -

自动化测试集(覆盖核心任务+关键失败场景)。 -

初始评估面板(显示各环节通过率、耗时)。 -

评估标准: -

MVA能否在无人工干预下完成单条完整流程? -

核心原子任务准确率是否>70%?(低于则退回步骤1调整拆解粒度) -

迭代点: 根据测试结果优化任务拆解逻辑或工具选择(如RAG检索效果差改用结构化查询)。

步骤3:评估体系工业化(自动化)(谁来做:数据工程师 + QA团队)

-

做什么: -

规则型:编写校验脚本(如日期格式合规性)。 -

模型型:用轻量模型判断输出合理性(如用text-classification模型检测回复是否礼貌)。 -

构建评估流水线:利用LangSmith等平台,自动收集运行日志、输入输出、中间状态。 -

开发自动评估器: -

设计人工审核队列:将低置信度结果自动推送人工复核。 -

交付物: -

自动化评估流水线(实时监控各环节指标)。 -

问题溯源看板(快速定位失败环节,如“供应商验证”错误率骤升)。 -

评估标准: -

是否实现90%+的自动化评估覆盖率?(减少人工检查量) -

问题定位时间是否从小时级降至分钟级? -

迭代点: 根据错误模式反哺工具优化(如增加Memory机制避免重复查询)。

步骤4:规模化扩展与体验优化(谁来做:全栈工程师 + UX设计师)

-

做什么: -

语音场景:加入缓冲话术(“正在查询库存…”)+ 背景音降噪。 -

界面场景:可视化任务进度条 + 实时解释决策依据。 -

接入生产环境:通过MCP协议连接企业API(如ERP、CRM),替代测试数据。 -

优化交互体验: -

弹性伸缩架构:基于负载动态调度Agent实例(如使用LangServe部署)。 -

交付物: -

生产环境集成方案(含API对接文档、灾备机制)。 -

交互体验升级包(语音/UI组件库)。 -

评估标准: -

生产环境任务成功率是否与测试环境差异<5%? -

用户满意度(NPS)是否提升20%+? -

迭代点: 根据性能瓶颈重构模块(如高频检索场景用向量数据库替代SQL)。

步骤5:持续反馈与领域增强(谁来做:运维团队 + 业务用户)

-

做什么: -

建立反馈闭环:用户可标记错误结果,自动触发评估流水线复现问题。 -

持续数据增强:将人工修正结果自动加入训练集,迭代RAG知识库或微调模型。 -

探索高阶能力:引入多Agent协作(如“谈判Agent”调用“合规Agent”校验条款)。 -

交付物: -

动态知识库更新机制(每周自动纳入新政策/案例)。 -

Agent性能周报(准确率、耗时、成本趋势)。 -

评估标准: -

错误修复周期是否从周级降至天级? -

人工干预率是否每月降低10%? -

迭代点: 当人工干预率<5%时,启动相邻流程自动化(如从合同审查扩展到履约跟踪)。

模拟案例:企业「采购合同风险审查」Agent落地

背景

-

痛点: 法务部日均审查200份合同,人工检查条款耗时易漏,平均处理时长48小时。

落地步骤

| 阶段 | 执行内容 | 交付物 | 评估与迭代 |

|---|---|---|---|

| 1. 流程解构 |

1. 提取关键字段(金额/供应商/日期) 2. 黑名单校验 3. 条款合规匹配(如违约金上限) 4. 生成风险报告 |

|

|

| 2. MVA构建 |

- RAG接入企业法规库 - 规则引擎校验金额格式 - 测试10份历史合同 |

|

|

| 3. 评估工业化 |

- 开发自动评估器: • 正则校验日期格式 • 分类模型判断条款风险等级 |

|

|

| 4. 规模化扩展 |

- 增加语音播报:“正在比对第3.2条款…” - 部署K8s集群弹性扩容 |

|

|

| 5. 持续增强 |

- 新增“不可抗力条款”知识库 - 引入谈判Agent生成修订建议 |

|

|

最终成效

-

效率提升: 合同处理时间从48小时→15分钟,人力释放70% -

风险控制: 条款漏检率从5%→0.2% -

扩展能力: 6个月内覆盖采购、销售、投资三大类合同

关键成功要素

-

拒绝完美主义: 首期MVA仅需解决核心环节。 -

评估即生产力: 自动化测试覆盖率>90%是迭代速度的基石。 -

工具认知红利: 工程师熟练掌握相关工具(例如LangChain+LangSmith+MCP),故障修复速度提升10倍。 -

业务主导迭代: 法务人员提供反馈可直接触发知识库更新,形成“用户即训练师”闭环。 -

体验优先设计: 用研体验产品团队再次伟大。

终极目标: 通过持续迭代,将“AI Agent流程”转化为企业核心基础设施,使高度AI使用成为业务常态——人类仅处理例外决策与策略优化,重复性工作100%由Agent接管。