上篇从基础开始,先理解 AI 是什么(上篇)我们从AI、LLM、大模型、多模态等核心术语入手,理了一遍基础概念。

这篇,我们继续深入,把那些在产品搭建、Agent组合和生成式AI项目中常见、但容易混淆的术语彻底讲清楚。

不只是解释“它们是什么”,更要回答这些术语背后那些你一定想问的问题:

Prompt为什么有的人写得好,有的人写不出效果?

Langchain和LLAMA是干嘛的?能做出产品吗?

MCP到底是什么?和RAG、Agent又有啥关系?

Prompt:为什么难用?又该怎么写得好?

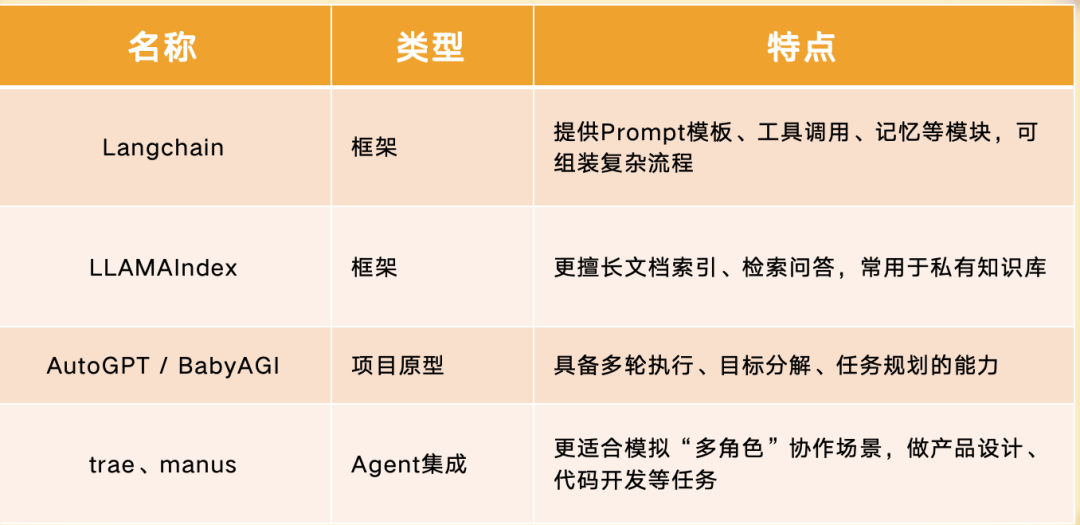

Prompt 就是你给大模型的“提问方式”或“提示词”。它不仅是一句话,可能是结构化的长文本,也可能嵌入函数调用、格式模板、指令组合。

新手最常遇到的问题有两种:

-

怎么写,才能让模型听懂?

-

写得好和坏,差别有多大?

这就是为什么我们会听到 Prompt Engineering(提示词工程) 这个词,它强调:

写Prompt不是写作文,而是设计输入,要结合模型上下文逻辑。

高质量Prompt通常具备结构清晰、角色设定、输入输出边界明确等特点。

举个栗子?:

你是一个资深儿童心理学家,帮我设计一份适合6岁小朋友、以“勇气”为主题的游戏互动剧本,要求包含3个关卡,每关1分钟,角色为:狐狸、小兔子。

这个提示词就比“帮我设计儿童剧本”清晰得多。

结构、目标、语境、输出内容边界都说清了。

Prompt库工具:

你可以在FlowGPT、PromptBase、PromptHero 中文站等网站上,查看热门Prompt模板,也可以收藏别人写好的提示词,复用参考。

Prompt管理工具:

像 Langchain / LLAMA / PromptLayer 等框架中,也提供提示词模板组件,可以集中管理和复用。

Agent:从聊天机器人进化到“自动执行者”

Agent(智能体)并不是大模型本身,而是一个“调度员”+“执行器”的系统,它可以:

自主决策: 根据目标判断下一步干什么

调用工具: 比如搜索网页、调用函数、读写文件

分步骤完成任务: 比如“帮我订酒店并发邮件通知我”

用户输入 → 思考(Thought) → 工具调用(Tool Use) → 观察结果 → 再决策 → 输出答案

和普通的 Chatbot 相比,它不只是“回答问题”,而是“解决任务”。

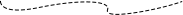

常见的Agent框架平台包括:

Langchain 和 LLAMA:不是大模型,

而是组装框架

Langchain 不是模型,而是一个“用来组装模型和工具”的 Python 框架。

它的核心目标是:

让你能像搭积木一样,把 LLM + Prompt + Agent + Memory + 工具调起来,做成“能执行任务的 AI 应用”。

串联多个步骤,比如“提取文本 → 搜索资料 → 生成内容”

管理多个Agent、多个模型调用

实现“记忆”功能,比如上下文管理、用户偏好记忆

?注意:这里的 LLAMA 不是 Meta 的模型 LLaMA,而是另一个拼写相近的工具LLAMAIndex(原名GPT Index)。专为连接大型语言模型(LLM)与外部数据设计的开源框架,通过结构化索引和高效检索机制,解决LLM在处理企业级知识库时的上下文限制与幻觉问题。适合做:

-

私有知识库构建

-

基于文件/数据库/网页的问答系统

-

和 RAG(检索增强生成)协同使用

?建议:需深度优化检索效果(如金融、医疗领域)选LlamaIndex;需快速搭建通用Agent选LangChain

Token:影响成本、长度、效果的关键单位

Token 是模型处理文本的基本单位。

不是“字”也不是“词”,而是“模型能识别的片段”,

比如:

“ChatGPT” 会被分成 2 个 token

中文“你好”会被分成 1 个 token

成本按token计费,比如GPT-4是0.03美元 / 1000输入token,DeepSeek-V3是4.8人民币/100万输入token。

Prompt不能太长,超过token上限会截断。

训练、推理、存储全部与token数有关。

MCP:用来理解“多轮上下文”

MCP = Model Context Protocol,是一类用于管理大模型“上下文状态”的协议或组件。

它的作用是:

-

定义模型如何记住你上一次说过什么(对话状态)

-

确保多轮问答之间的指令、身份、记忆一致

-

控制“系统提示词”(System Prompt)、“角色设定”、“历史对话”这类内容在上下文中的位置与优先级

你会发现:

-

大模型偶尔会“记不住你说过的话”

-

回答会出现人格错乱(上一轮是专家,这轮变学生)

-

Prompt不生效,可能是被上下文覆盖了

这背后很可能就是MCP配置问题。它常常集成在 Langchain、LangGraph、OpenAI Function Calling 等框架中,帮助你精细控制模型上下文。

✅总结一下:这些术语之间怎么联动?

我们把核心术语再串起来,形成这样一张“AI术语地图”:

? 最后提醒一句:

这些术语和工具,本质上都只是“搭积木的零件”。是否必要、是否好用,关键在你要解决的问题和使用的运行环境。

有的产品不需要Agent,用ChatGPT就够了;

有的Prompt非常复杂,要引入Langchain统一管理;

有的对话场景用不到RAG或私有知识库,直接API调用也能完成。

术语本身没有魔法,但理解术语的人能把魔法变成现实。

如果这篇文章帮你理清了这些术语的关系,欢迎收藏、转发给你的AI学习搭子。