docs.siliconflow.cn/api-reference/chat-completions

API 价格

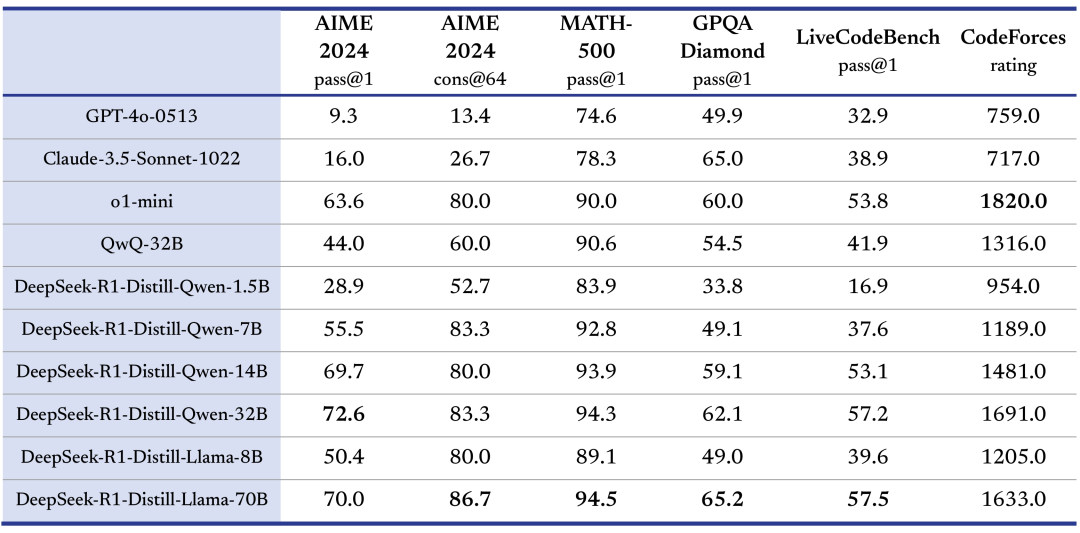

蒸馏小模型性能超越 o1-mini

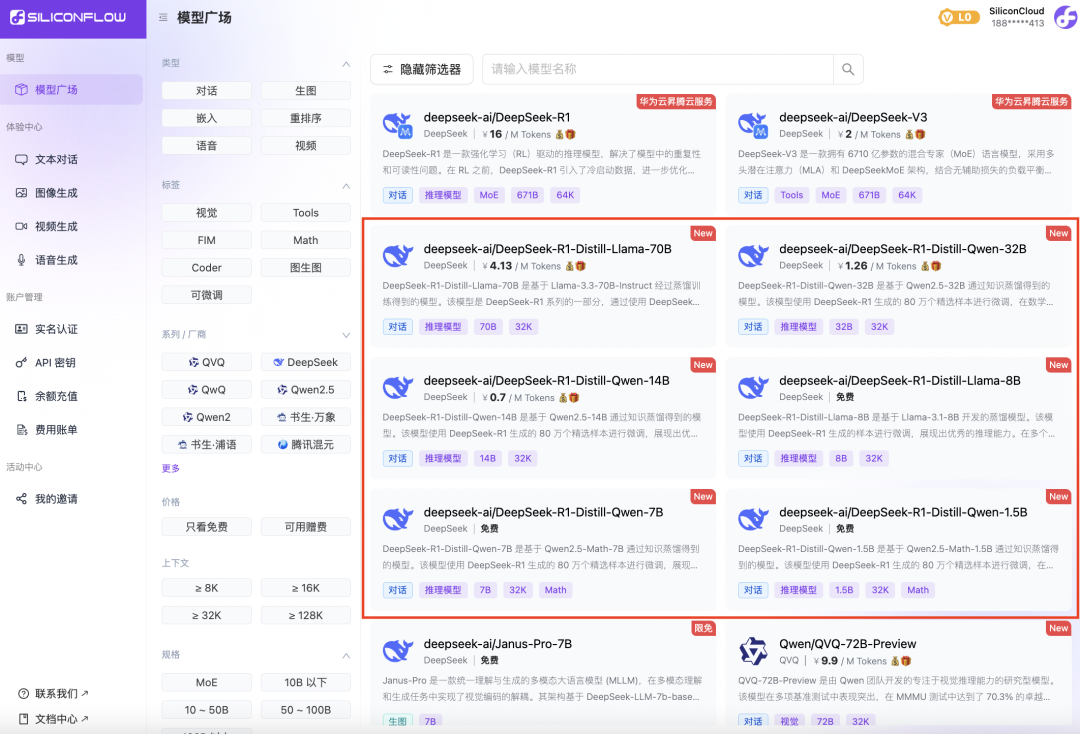

Token 工厂 SiliconCloud

Qwen2.5(7B)等 20+ 模型免费用

除了上述六款模型,SiliconCloud 已上架包括 DeepSeek-R1、DeepSeek-V3、Janus-Pro-7B、CosyVoice2、QVQ-72B-Preview、DeepSeek-VL2、DeepSeek-V2.5-1210、Llama-3.3-70B-Instruct、HunyuanVideo、fish-speech-1.5、Qwen2.5-7B/14B/32B/72B、FLUX.1、InternLM2.5-20B-Chat、BCE、BGE、SenseVoice-Small、GLM-4-9B-Chat 在内的数十种开源大语言模型、图片/视频生成模型、语音模型、代码/数学模型以及向量与重排序模型。平台支持开发者自由对比、组合各种模态的大模型,为你的生成式 AI 应用选择最佳实践。

附:DeepSeek-R1 系列模型 API 使用指南

安装与升级

pip3 install -U openai

API 参数

-

输入参数:max_tokens:回答的最大长度(包含思维链输出),最大为 16K。

-

返回参数:

-

reasoning_content:思维链内容,与 content 同级。

-

content:最终回答内容

上下文拼接

OpenAI 请求示例

流式输出请求

from openai import OpenAI

url = 'https://api.siliconflow.cn/v1/'

api_key = 'your api_key'

client = OpenAI(

base_url=url,

api_key=api_key

)

# 发送带有流式输出的请求

content = ""

reasoning_content=""

messages = [

{"role": "user", "content": "奥运会的传奇名将有哪些?"}

]

response = client.chat.completions.create(

model="deepseek-ai/DeepSeek-R1",

messages=messages,

stream=True, # 启用流式输出

max_tokens=4096

)

# 逐步接收并处理响应

for chunk in response:

if chunk.choices[0].delta.content:

content += chunk.choices[0].delta.content

if chunk.choices[0].delta.reasoning_content:

reasoning_content += chunk.choices[0].delta.reasoning_content

# Round 2

messages.append({"role": "assistant", "content": content})

messages.append({'role': 'user', 'content': "继续"})

response = client.chat.completions.create(

model="deepseek-ai/DeepSeek-R1",

messages=messages,

stream=True

)

非流式输出请求

from openai import OpenAI

url = 'https://api.siliconflow.cn/v1/'

api_key = 'your api_key'

client = OpenAI(

base_url=url,

api_key=api_key

)

# 发送非流式输出的请求

messages = [

{"role": "user", "content": "奥运会的传奇名将有哪些?"}

]

response = client.chat.completions.create(

model="deepseek-ai/DeepSeek-R1",

messages=messages,

stream=False,

max_tokens=4096

)

content = response.choices[0].message.content

reasoning_content = response.choices[0].message.reasoning_content

# Round 2

messages.append({"role": "assistant", "content": content})

messages.append({'role': 'user', 'content': "继续"})

response = client.chat.completions.create(

model="deepseek-ai/DeepSeek-R1",

messages=messages,

stream=False

)

注意事项

-

API 密钥:请确保使用正确的 API 密钥进行身份验证。

-

流式输出:流式输出适用于需要逐步接收响应的场景,而非流式输出则适用于一次性获取完整响应的场景。