新智元报道

新智元报道

【新智元导读】AI从医疗工具变身为协作队友,斯坦福大学研究揭示:医生诊断准确率竟飙升10%!70名美国执业医生参与的真实测试,AI-first、AI-second与传统诊断,谁能更精准破解临床谜题?

你敢让AI帮你看病吗?

斯坦福大学的一群医生和工程师,最近做了一项研究:让AI和人类医生组队,共同破解复杂的诊断难题。

论文链接:https://www.medrxiv.org/content/10.1101/2025.06.07.25329176v1.full.pdf

结果让人惊讶:当AI从「工具」变成「队友」,医生的诊断准确率直接飙升了10%。

网友惊叹:颠覆的临界点即将到来!

「充满热情的医生加上AI将势不可挡。」

「AI驱动的临床决策支持,仍然是该领域最有力的杠杆之一。」

还有人表示,「对于一个背负数十万美元债务的医生来说,这种发现有点令人害怕。这还只是用GPT 4,无法想象o3会有多厉害。」

过去几年,AI在医疗领域的存在感越来越强,从影像识别到药物研发。

但医生把它当搜索工具,用来查指南、找文献,却不敢真正把它当作「搭档」。

为什么会这样?斯坦福的研究团队发现,关键问题出在交互模式上。

早期的AI就像个沉默的助手,医生输入问题,它输出答案。

这导致医生很难信任AI的判断,甚至出现过「医生用AI辅助诊断,结果反而比AI单独诊断更差」的情况。

于是,他们决定做一个颠覆性实验:把AI变成会讨论的队友。

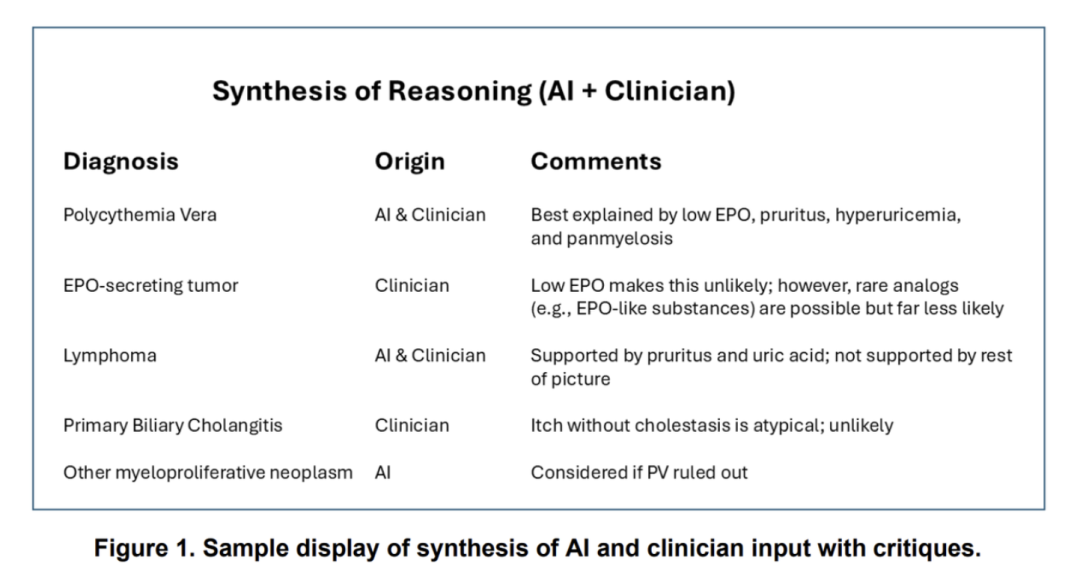

实验设计很巧妙:让医生和AI各自先独立分析病例,然后AI生成一份联合报告,不仅列出双方的共识和分歧,还会像资深医生一样点评每个诊断的合理性。

比如,当医生考虑真性红细胞增多症,AI会补充低EPO水平支持这一诊断,但需排除罕见的EPO分泌肿瘤。

当医生漏掉淋巴瘤的可能性,AI会提醒瘙痒和尿酸升高可能是这个方向。

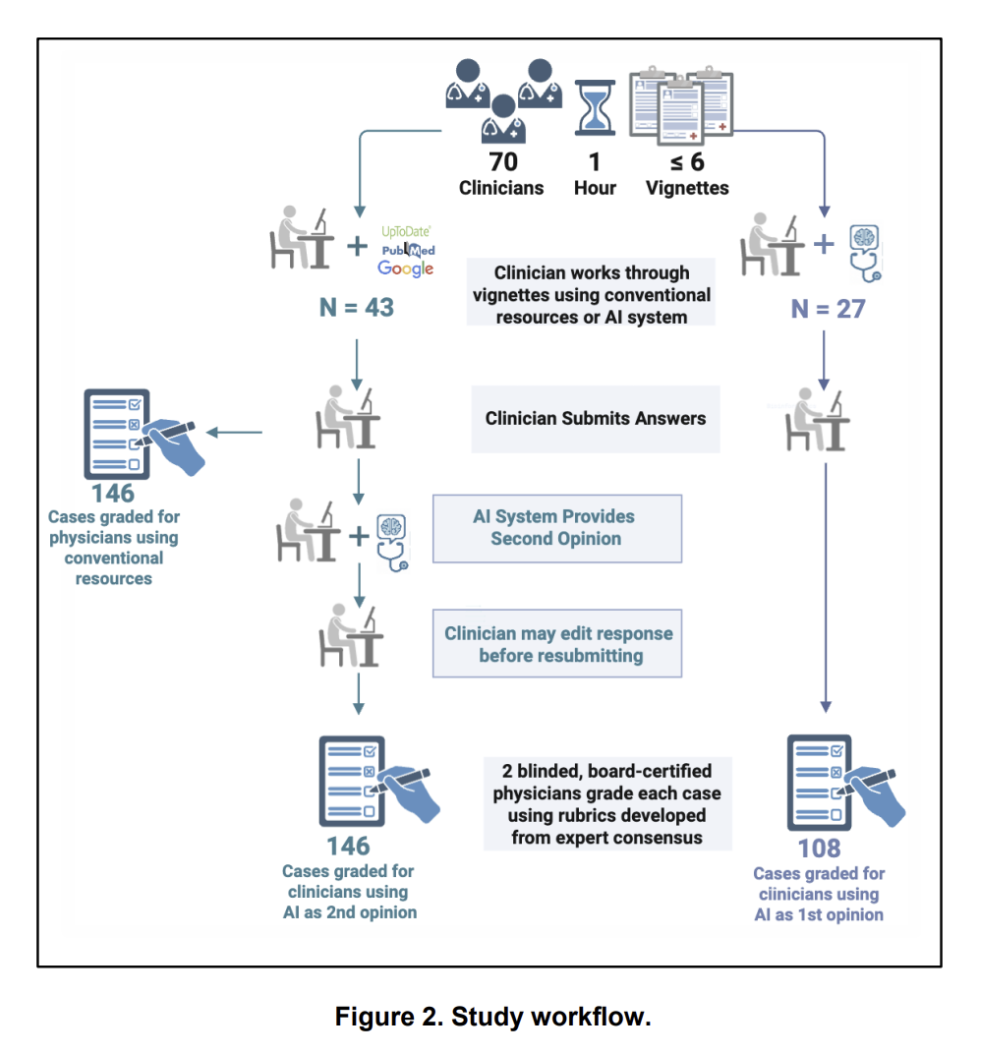

团队基于GPT-4开发了一款定制化的AI系统,设计了两种协作工作流程,分别测试AI-first和AI-second时的效果。

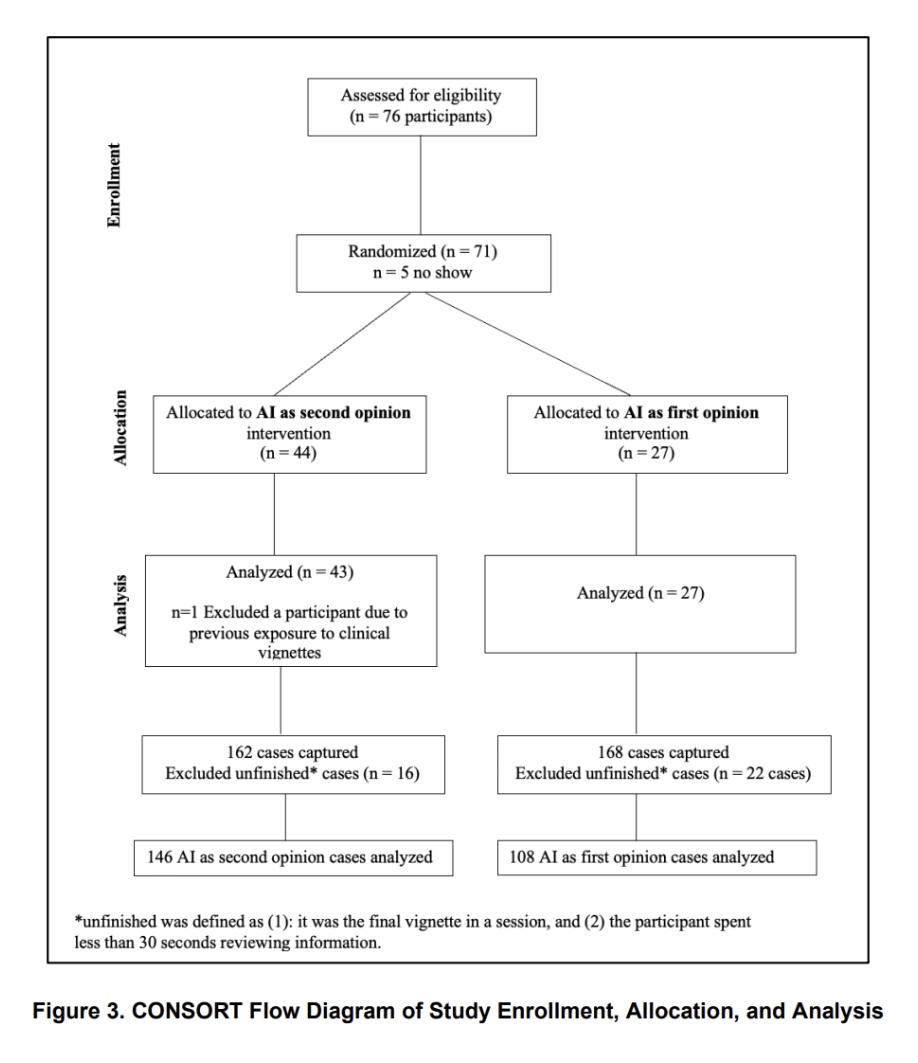

70名美国执业的内科或家庭科医生参与了这项试验,他们被随机分配到以下三种组别之一:

-

AI-first组:医生首先输入病例信息,查看AI生成的诊断建议(包括五个可能的诊断和七个后续步骤),然后结合自己的判断形成最终诊断。

-

AI-second组:医生先独立完成诊断(可以使用传统资源如UpToDate、PubMed等),再将病例和自己的初步诊断输入AI系统,AI会生成独立分析并与医生的诊断进行整合,生成一份综合报告。

-

对照组:医生仅使用传统资源完成诊断,不与AI互动。

实验使用了六个基于真实患者的临床病例,涵盖了复杂诊断场景。

每个病例包含病史、体检和实验室检查结果,医生需要提供三个可能的诊断、支持和反对的证据、最终诊断及三个后续步骤。

研究通过19分制的评分系统评估诊断的准确性,评分由两位内科认证医生独立完成,且评分者不知道答案来自医生还是AI,以确保公平。

AI系统的核心设计在于协作。

它不仅生成自己的诊断,还会对比医生和AI的判断,生成一份综合报告,清晰列出双方提出的诊断、共识点、分歧点,并对每个诊断提供评论。

这种设计旨在激发医生的批判性思考,而非简单依赖AI的输出。

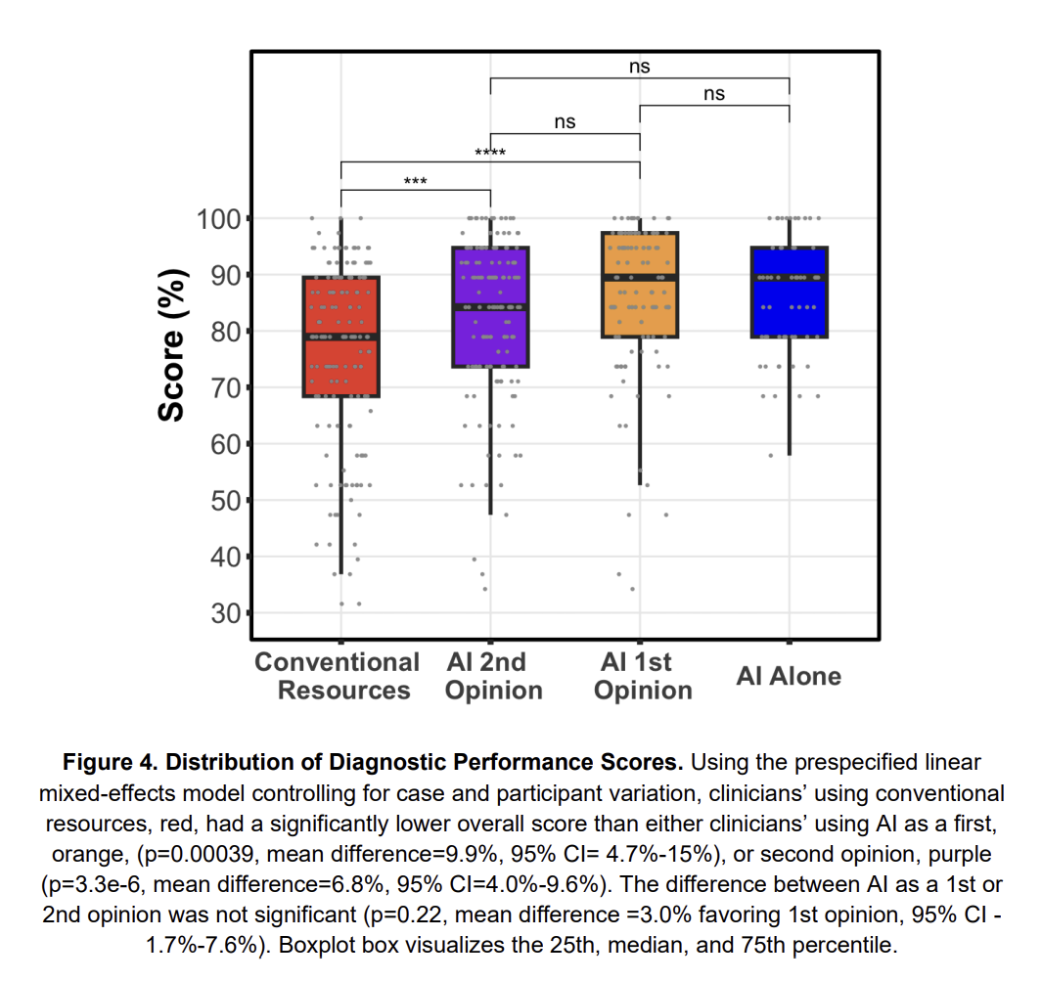

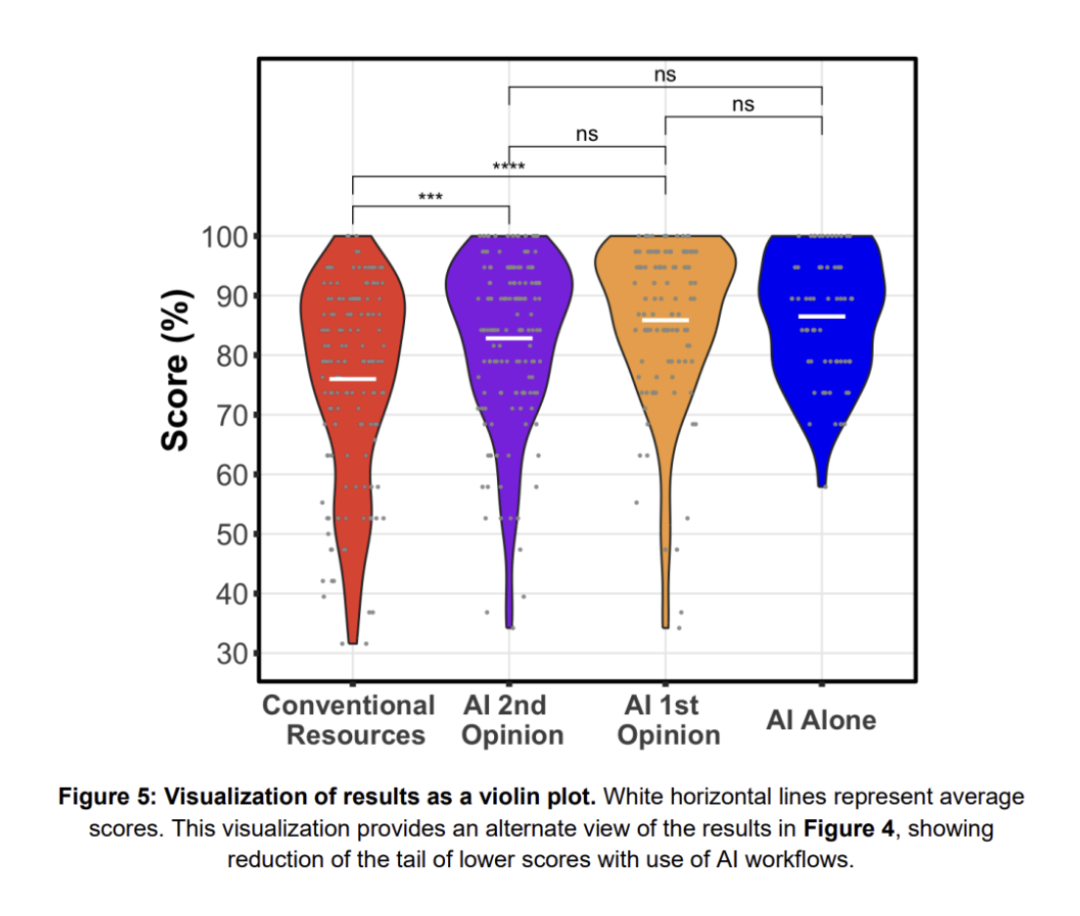

研究结果令人振奋,AI协作组的医生表现明显优于仅使用传统工具的对照组。

诊断准确性:

-

对照组(传统工具):平均得分75%。

-

AI-first组:平均得分85%,比对照组高9.8%(p<0.0004)。

-

AI-second组:平均得分82%,比对照组高6.8%(p<0.00001)。

-

AI单独运行:平均得分90%,略高于协作组但差异不显著。

医生和AI协作后,虽然没超过AI单独水平,却比医生单打独斗强。这说明,AI能补全人类思维的漏洞。

在最终诊断和后续步骤(即临床上可操作的决策)方面,AI-first比AI-second组表现更好(高8.9%,p=0.026)。

AI-second相较于对照组在这些决策上的得分提升了14.9%(p=0.00092),其中36%的病例在与AI互动后有所提高。

AI-first完成每个病例的平均时间为631秒,略快于AI-second的688秒。在剔除未严格遵循流程的病例后,AI-first的优势更明显。

所有医生在试验后对AI的态度显著改善,98.6%表示愿意在复杂临床推理中使用AI(试验前为91.4%,p=0.011)。

信息过载与遗漏:临床诊断就像拼拼图,每个病例可能包含几十条线索。

医生很容易漏掉某个实验室指标(比如「血清LDH升高」提示细胞破坏),但AI能瞬间扫描所有数据,精准关联高LDH+巨幼细胞贫血可能指向骨髓增生异常综合征。

经验依赖的陷阱:资深医生容易被典型病例固化思维。

比如看到老年女性、乏力、舌炎,可能优先考虑缺铁性贫血,但AI会跳出经验框架,提出维生素B12缺乏或甲状腺功能减退的可能性。

决策链的逻辑性:AI的诊断报告就像思维流程图:先列出3个最可能的诊断,再用支持证据和反对证据逐条论证,最后给出3个下一步检查建议。

为了让AI更懂医生,研究团队给它加了三个补丁。

1. 会「吵架」的批判性思维:当医生的诊断和AI不一致时,AI不会直接服从,而是会说:「您提到的原发性胆汁性胆管炎可能性较低,因为患者缺乏胆汁淤积的证据,但需要注意罕见变异型。」

这种挑战不是对抗,而是逼医生重新审视自己的逻辑漏洞。

2. 能「翻译」的沟通能力:传统AI输出的是学术化的语言,但实验中的AI会用口语化表达:「目前看,真性红细胞增多症是最可能的,但淋巴瘤不能完全排除,建议先查血清EPO水平和骨髓活检。」

这种说人话的能力,让医生更容易理解和接受。

3. 可「追溯」的透明化决策:每个诊断结论,AI都会标注证据来源,比如「支持淋巴瘤的证据是瘙痒和尿酸升高(引用文献X),反对证据是缺乏淋巴结肿大(引用指南Y)。」

这解决了医生对AI黑箱决策的不信任感,让协作建立在可验证的基础上。

研究发现,AI-second组中,AI的独立分析有时会受到医生初步诊断的影响。

实验中有个有趣的细节:AI-second组中,48%的病例中AI的诊断和医生初始意见完全重叠,而AI-first组仅为3%。

说明如果医生先入为主给出思路,AI可能会「迎合」人类判断,未能完全遵循独立分析的指令。

比如,有个病例中医生误判缺铁性贫血,AI在后续分析中居然也把这个诊断放在了第一位。尽管按照数据,维生素B12缺乏才是更合理的方向。

这意味着,AI的批判性依赖于独立思考的空间,一旦被人类思维锚定,反而会降低协作价值。

但反过来,当AI先发言时,医生会更主动地挑战它的结论。

有位住院医师在看到AI提出骨髓瘤时,立刻反驳:患者没有骨痛和蛋白尿,这个诊断可能性太低,并最终通过追问病史排除了这一方向。

这种「对抗性协作」,反而激发了更深入的临床推理。