Qwen3分别针对通用知识、推理能力和长上下文能力三步预训练;

-

通用知识训练:4096序列长度,30T总token,119种语言和方言;该阶段主要聚焦于语言结构、语法、常识与通用世界知识的学习,为后续阶段提供强大的多语言理解与生成能力支撑。

-

推理能力训练:4096序列长度,5T总token,学习率衰减加快,提高STEM、编码、推理和合成数据的比例;

-

上下文长度增加:32,768序列长度,10B总token,75%的文本长度在16,384至32,768 token之间,25%的文本长度在4,096至16,384 token之间,ABF技术,YARN和双块注意力(DCA);

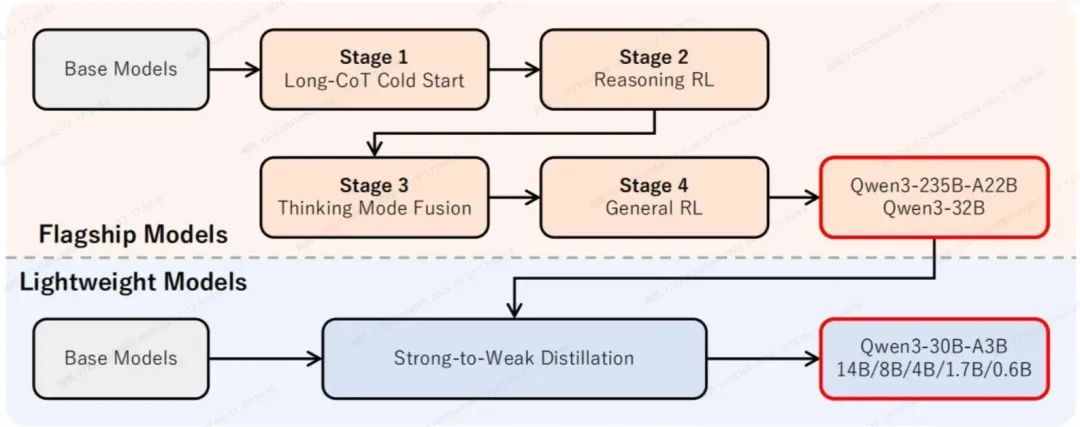

后训练

思维链冷启动

目标:精心挑选数据集,用于推理能力的初始冷启动训练,为了在模型中灌输基础推理模式,而不过度强调推理性能,确保在后续强化学习(RL)阶段具备更大的灵活性和提升空间。所以数据集不用太多,但需要多样性,防止过拟合,让模型保持一定的“未完成性”。

数据集特点:涵盖广泛类别的综合数据集,包括数学、代码、逻辑推理和通用STEM问题。数据集中的每个问题都配有经过验证的参考解答或基于代码的测试用例。

数据集构建:

-

查询过滤:使用大模型移除不易验证的Query,包括包含多个子问题或请求通用文本生成的Query,移除无需使用思维链的Query。为每个Query标注领域标签,确保领域数据均衡;

-

相应过滤:使用推理大模型为查询过滤后的Query生成N个候选响应,对于无法生成正确回答的进行人工过滤。过滤标准:

-

最终答案错误;

-

包含大量重复内容;

-

明显存在缺乏充分推理的猜测;

-

总结内容与思维过程不一致;

-

不恰当的语言混用和风格转换;

-

与验证集内容高度相似;

推理强化学习

数据要求:(3,995个数据对)

-

未在冷启动阶段用过;

-

对冷启动模型是可学习;

-

具有一定的难度;

-

覆盖领域广泛;

措施:

-

采用GRPO算法更新模型;

-

大批量+多rollout并行探索策略空间;

-

探索与利用平衡的动态熵控制;

-

离线策略训练提高样本利用效率;

思维模式融合

目的:将“非思维”能力集成到先前训练的“思维”模型中,使得能够管理和控制推理行为。

该模式下涌现出基于停止思考时刻积累的推理内容继续生成最终响应的能力。

措施:

-

对推理强化学习模型进行SFT微调;

-

“思维”数据是通过第二阶段模型对第一阶段的查询进行拒绝采样来生成;

-

“非思维”数据经过精心整理,覆盖编码、数学、指令遵循、多语言任务、创意写作、问答和角色扮演等多样化任务。

-

在系统消息中引入/think和/no_think标记来确定回答模式;确保模型输入格式一致,对于非思维模式样本,助手响应中会保留空的思考块。

通用强化学习

目的:提升模型在多样化场景中的能力和稳定性;

措施:建立一个涵盖20多种任务的奖励系统;

评估维度:

-

指令遵循:确保模型准确理解并遵循用户的指令,包括与内容、格式、长度及结构化输出,生成符合用户期望的响应。

-

格式遵循:遵循特定的格式规范,如对/think和/no_think标记做出恰当响应,并在最终输出中始终使用指定标记(如

和 )来分隔思考内容与回答内容。 -

偏好对齐:对于开放式查询,偏好对齐侧重于提升模型的实用性、吸引力和风格适配性,最终提供更自然且令人满意的用户体验。

-

Agent能力:这涉及训练模型通过指定接口正确调用工具。在强化学习展开过程中,允许模型与真实环境执行反馈进行完整的多轮交互循环,从而提升其在长程决策任务中的性能和稳定性。

-

专业场景能力:在更专业的场景中,我们针对特定上下文设计任务。例如,在RAG任务中,我们引入奖励信号引导模型生成准确且符合上下文的响应,从而降低幻觉风险。

奖励类型:

-

基于规则的奖励:基于规则的奖励已在推理强化学习阶段广泛使用,且对指令遵循和格式遵守等通用任务也很有用。精心设计的基于规则的奖励能够高精度评估模型输出的正确性,避免奖励破解等问题。

-

带参考回答的基于模型的奖励:在这种方法中,我们使用大模型A为每个查询提供一个参考回答,并让大模型A根据该参考回答对当前训练模型的响应进行评分。这种方法能够更灵活地处理多样化任务,无需严格的格式要求,避免了纯基于规则的奖励可能产生的假阴性问题。

模型蒸馏

离线策略蒸馏:学生模型学习老师模型对于两种模式下的响应输出,从而学会基础推理模式和模式切换能力;

在线策略蒸馏:最小化两种回答模式下学生与老师模型输出logits的KL散度。

其它

效果:

-

数学与编程的测试集上反应了蒸馏方法在性能上显著优于强化学习,并且它所需的 GPU 计算时间仅为强化学习的约十分之一。

-

对于知识类、STEM、数学和编程任务 ,思考模式融合与通用强化学习并未带来显著的性能提升;

数据合成:

-

利用 Qwen2.5-VL 进行文本识别;

-

使用垂直领域模型合成领域数据;

关键参数与技术;

-

Qwen3 模型使用(GQA)、SwiGLU、(RoPE)和 RMSNorm 等技术;

-

Qwen3 引入 QK-Norm 以确保稳定训练。

-

Qwen3 MoE 更细粒度的专家分割;

-

Qwen3 MoE 采用全局批处理负载均衡损失鼓励专家专业化;

-

Qwen3 MoE 共有 128 个专家,每个 token 会激活 8 个专家,没有共享专家;

三阶段预训练->思维链冷启动->推理强化学习->思维模式融合->通用强化学习->使用大模型蒸馏预训练好的小模型