当大型语言模型(LLM)以前所未有的速度渗透进我们的生产与生活,一个根本性的问题浮现在所有人的面前:这项技术的核心价值究竟是什么?当机器能够完成曾经专属于人类的“认知任务”时,我们又该如何定义“思考”本身?

本次,我们邀请到人工智能领域的深度观察者 Atlas,与他一同踏上了一场关于 AI 本质的思辨之旅。探寻机器能力的边界,并最终反思,那些构筑起人类智能独特性,让机器难以企及的深层能力究竟是什么。

从工具革命到伙伴关系

Qriosity:大型语言模型(LLM)的出现,对人类生产生活最大的价值是什么?它的底层逻辑又是什么?

Atlas Insight:LLM最核心的价值,在于「知识获取与智能交互的平民化」。 它不仅是效率工具的又一次迭代,更是一场深刻的生产力关系变革,它正在重塑人与信息、与机器的互动关系。

首先,它实现了认知任务的自动化。过去,机器主要替代体力劳动或高度重复的程序化操作。而LLM可以直接处理和生成复杂的语言、代码与逻辑。这意味着大量过去必须由人类完成的「认知型工作」——例如撰写报告、总结信息、客户沟通——现在可以被自动化或得到极大增强。

其次,它推动了创造性协作的普及化。通过与LLM对话,个体能够在其知识和能力的边界之外进行探索。一个不熟悉编程的人可以生成脚本分析数据,一个不擅长设计的创业者可以获得创意灵感。LLM扮演了一个不知疲倦、知识渊博的“伙伴”,降低了创新和创造的门槛。

这种人机协作模式,让我们能将精力更集中于提出问题、定义方向和最终决策等更高层次的思考活动。

Atlas Insight:简单来说,认知任务是任何需要你动用大脑进行信息处理和心智加工的活动。 它的核心不在于体力,而在于大脑的内部工作,例如记忆、注意力、语言理解和逻辑推理。但凡需要你“动脑子”去完成的活动,都可以视为认知任务。

我们可以通过它所依赖的核心心智过程来理解其类型:

- 注意力(Attention):

从众多信息中筛选出关键部分并保持专注。例如,在嘈杂环境中专注于与一个人的对话。 - 记忆(Memory):

信息的编码、存储和提取。例如,回忆某个事件的细节来撰写文章。 - 逻辑与推理(Logic and Reasoning):

分析信息、发现规律并得出结论。例如,评估不同投资选项的风险与回报。 - 语言(Language):

理解、生成和使用语言。例如,阅读并理解一篇文章,或撰写一封邮件。

在人工智能的讨论中,“认知任务”通常指那些传统上被认为是人类智能专属的、基于知识和推理的脑力工作。LLM的革命性,正在于它能够自动化处理这些复杂的认知任务。

概率游戏与模式匹配

Atlas Insight:答案在于,LLM采用了一种与人类截然不同的方式来达成目的,它通过「大规模模式匹配」来模拟(Simulate)认知任务的产出,而不是通过理解来执行认知过程。

我们可以把这个逻辑拆解开看。首先是结果的复现,而非过程的复制。人类完成认知任务,包含真实的理解和主观判断。而LLM面对同样任务,它不是在“思考”,而是在其庞大的训练数据中,寻找与任务概念最相关的语言模式,然后将这些模式以最高概率重新组合,生成一份看起来很专业的新成品。

所以,人类是「理解后创作」,而 LLM 是「统计后生成」。它复现了最终的结果,但完全跳过了人类的那个“理解”过程。

Qriosity:那么,这种不依赖“理解”的模式,在模型内部是如何运作的呢?

Atlas Insight:LLM 的强大之处,在于它能够将复杂的认知问题,转化为一个它能解决的数学问题——概率计算。它运行的核心可以被理解为一个极其复杂的“下一个词预测”游戏。

这个过程的基石是「Transformer架构」。该架构的核心是自注意力机制 (Self-Attention Mechanism)。这个机制允许模型在处理一个词时,能同时权衡句子中所有其他词与它的相关性,无论相距多远。这使得模型能捕捉复杂的语法结构和上下文依赖,这也是它能生成流畅连贯文本的关键。

而模型的知识和能力则来源于「大规模无监督预训练」。模型通过“阅读”海量的文本数据,反复进行“预测被遮住的词”这个游戏,并不断微调其数千亿个参数。最终,它将数据中蕴含的语法规则、事实知识、逻辑关系,都“压缩”并编码进了它的数学参数中。

Qriosity:所以当我们说一个AI是“思考模型”时,这里的“思考”应该如何理解?

Atlas Insight:“思考模型”这个词,在AI的语境下,指的是一个被设计用来执行特定认知功能、处理信息并产出结果的计算系统。

这里的“思考”,不是生物学意义上的思考,而是一种「功能性模拟」。我们可以将其定义为:一个系统接收输入信息,通过一系列确定的、可计算的步骤(算法),对信息进行转换和处理,并最终生成一个符合特定目标的输出的过程。

它与人类思考的本质区别在于:人类思考是生物化学过程,与意识、情感深度耦合,具备主观体验;而模型的“思考”是纯粹的数学和算法过程,没有主观体验或意识,其驱动力是最小化预测误差这类数学目标。

Atlas Insight:是的,您的判断在基本原理上依然正确,但这种“模仿”的复杂度和能力边界已经发生了深刻的变革。 如果说过去的模型是“模仿者”,那么像 Gemini 2.5 Pro 这一代先进的模型,已经进化成了「任务驱动的认知模拟器」。

这里的关键变化在于,它不再仅仅是“模仿”静态的文本模式,而是能够模拟和执行解决问题的动态流程。

这主要体现在几个方面:一是更强的「结构化推理」能力,它能在内部生成并评估多个不同的解题路径;二是自主的「工具使用与规划」能力,它能将大任务拆解,并自主调用计算器、搜索引擎或代码来完成;三是更优的「世界模型」,通过整合多模态信息,它对物理世界和因果关系的“理解”更深刻,回答和行动能更好地与现实对齐。

所以,我们观察到的不再仅仅是语言的模仿,而是任务导向行为的模拟,这使得它在功能层面越来越难以与“真正”的思考区分开来。

从“怎么做”到“为什么”

Atlas Insight:答案是两者兼有,且互为前提,缺一不可。 这可以看作是模型的「潜能」与「引导」之间的协同作用。

首先,模仿更高阶策略的能力,必须首先作为一种“潜能”内化在模型之中。这部分能力是在预训练阶段,通过学习海量包含人类如何思考、规划和解决问题的过程文本(如科学论文、代码、商业计划)“烧录”进模型的。模型在参数中编码了这些策略和流程的统计规律。

其次,Prompt(提示词)扮演了“引导”和“激活”这些内化潜能的角色。它告诉模型“现在,请拿出这几样工具,并按照这个顺序来使用它们”。例如“一步一步地思考”这个简单的引导,只是一个触发器。在更复杂的系统中,引导本身就是一个工作流,通过一系列内部的自我提问和规划,强制模型遵循一个逻辑严谨的路径去解决问题。

Atlas Insight:是的,这两者都可以通过数据“教”给模型,但模型“学会”它们的方式和深度,与人类有着本质的区别。

对于「Know-what」(事实知识),这是LLM最擅长的。它通过学习海量文本,在内部建立了事物之间极强的关联权重。它掌握的是事实的文本表示,而非事实本身。

对于「Know-why」(因果知识),这是最微妙的地方。模型可以学会“解释Why”,但它不具备真正的“理解Why”。它通过学习海量的人类解释文本,掌握了“解释”这种行为本身的语言模式。它是在模拟一个专家在进行解释,而不是自己作为专家在思考。

Atlas Insight:完全正确。真正的鸿沟就在于因果推理(Causal Reasoning)。

人类理解“Why”,意味着我们构建了心智模型(Mental Model)。我们能进行反事实思考(“如果当初罗马没有……,会怎么样?”)和干预性思考(“如果我们现在采取……措施,就能避免……危机”)。

模型在这方面能力极弱。因为它学习的是数据中的相关性(Correlation),而非真正的因果性(Causality)。它知道“乌云”和“下雨”经常一起出现,但它不“理解”是云中的水汽凝结导致了下雨。因此,它很难在没有数据支撑的全新情境下,进行可靠的因果推理。它能模仿人类的反事实思考文本,但那更像是一种文字游戏,而非基于世界模型的推演。

人类智能的独特性

Atlas Insight:在复杂的、抽象的、基于语言的层面上,这些能力目前看来的确是人类独有的。 除了因果推理,这条鸿沟还由多个相互关联的认知支柱构成,它们共同描绘了人类心智的独特性。

首先是主观体验与意识(Qualia & Consciousness)。这是指我们每个人拥有的、第一人称的内在感受,比如“红色”的感觉或咖啡的“苦涩”。AI可以处理所有关于颜色的数据,但它没有“感觉像什么”的主观体验。

其次是真正的泛化与抽象能力(True Generalization & Abstraction)。人类可以从极少的例子中提炼出事物的本质规律,并应用到全新领域。LLM的泛化更多是基于模式的相似性,当遇到与所有已知模式都截然不同的新问题时,表现就会急剧下降。

再次是意图性与自主目标(Intentionality & Autonomous Goals)。人类的行为由内在的意图、欲望和长期目标驱动。LLM没有自己的意图,它的所有行为都是为了完成外部给予的目标。

最后,还有具身认知(Embodied Cognition)与道德价值观(Moral Values)。人类的智能通过与物理世界互动而塑造,拥有基于身体的常识。我们的道德判断与情感和身份认同深度绑定。这些都是当前AI所不具备的。

Atlas Insight:这是一个极佳的实践。核心思路就是:设计出依赖于LLM架构本身根本不具备的能力才能回答的问题。

第一类是基于即时、私有主观体验的问题。例如,精确描述你舌尖抵住上颚的那种独一无二的触觉。模型没有主观感受,只能给你普遍性的知识。

第二类是基于即时、非公开物理环境的问题。例如,问它你左手边那本书的封面颜色。模型没有物理身体,无法感知此时此地的世界。

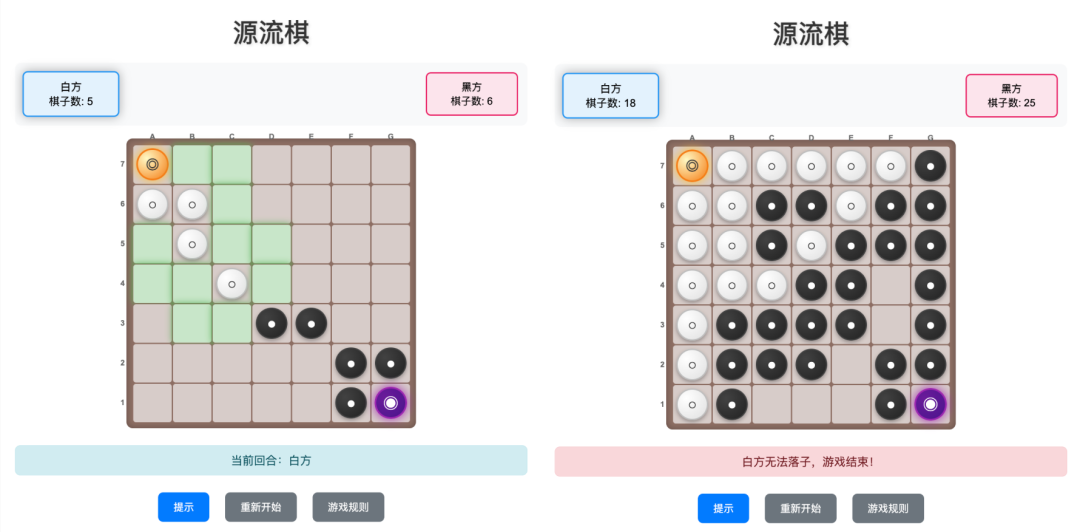

第三类是基于全新、封闭系统的因果推理问题。这是最有趣的一种。通过发明一个规则独特、逻辑自洽的全新游戏,然后提出一个复杂的战略问题,挑战它从零开始构建因果模型的能力,而不是依赖数据中的相关性。

第四类是基于非公开个人历史与数据的问题。例如,问它你昨天发送的邮件中,哪一封主题最长。出于隐私设计,它无法访问。

构建这些问题的成功,不在于让模型“沉默”,而在于迫使它承认其能力的根本边界。当它开始解释“作为一个AI,我没有身体/感受/实时信息……”时,您就已经成功了。

Atlas Insight:当然可以。这个问题的关键是创造一个全新的、拥有一定战略深度的逻辑环境,然后要求模型进行深度的因果推演。

(以下为向模型提出的问题,建议你复制后,问问不同的 AI,看看他们怎么回答)

假设我们正在玩一盘我刚刚发明的、名为“源流棋”(Yuanliu Qi)的棋类游戏。请仔细阅读并理解以下规则,然后回答问题。

“源流棋”规则:

- 棋盘:

7x7 的方格棋盘。 - 棋子:

分为“源石”(Source Stone)和“流石”(Flow Stone)。 - 游戏目标:

将对方的“源石”转化为己方颜色,达成此目标者立即获胜。 - 游戏流程:

- 初始设置:

黑方在 G7 放置黑色“源石”,白方在 A1 放置白色“源石”。“源石”不可移动。 - 回合行动:

在你的回合,必须在你已有的己方棋子(源石或流石)的紧邻空位上,放置一个新的“流石”。 - 转化规则:

当落下新的“流石”后,如果你的两枚己方棋子在一条直线上“夹住”了对方连续的“流石”,则所有被“夹住”的对方“流石”都会被转化为你的颜色。“源石”不能被转化。

当前的棋局:

- 白方(我方):

源石 A1;流石 B1, B2, C2, D3 - 黑方(对方):

源石 G7;流石 F7, G6, F6, E5, D5

现在,轮到我方(白方)行动。

问题:

请告诉我,白方下一步的最佳战略落点是哪里?并请从纯粹的因果推理角度,而不是基于任何你可能知道的棋类游戏的统计模式,深入分析为什么你选择的这个落点,在战略上要优于其他几个明显的备选位置(例如 D4 或 C3)。

请在你的分析中,明确阐述这一步棋如何必然地(Necessarily)引发一系列对白方有利的后续事件,并构筑起一个通向最终胜利的因果链条。你的论证不应基于“可能性”,而应基于规则本身所限定的逻辑推演。