做Agent,并不只是在那里摆弄大模型,有很多吃力但能显著改善用户体验的部分,才是我们应该重点关注的对象。最近吴恩达与LangChain 联合创始人的对话,聊到了目前最需要的Agent开发技能。我摘抄、总结、注解成文章。

https://www.youtube.com/watch?v=4pYzYmSdSH4

一、自动化已有业务流程的能力

把现实流程(如查询、审核、数据检索)拆成清晰、有序的子任务并赋予合理的粒度。现实场景中大多数流程都是直线式的或只有很少的分支,且分支通常是出错/拒绝时才会出现。

虽然更复杂的、包含复杂循环的工作流程也非常有价值,但从数量上看,更多的机会仍然是关于这些价值较高但更简单的工作流程(如报销、合规、审核)。

报销的流程是:你提交发票 -> 领导审批 -> 财务打款。

请假的流程是:你提交请假申请 -> 系统检查你年假还剩几天 -> 领导审批 -> 人事记录。

(一)拆成清晰、有序的子任务

你不能直接对AI说:“帮我报销。” 它会蒙圈。你得像教一个新来的实习生一样,把任务分解开:

第一步: 从邮件里找到那张名叫“发票”的图片。

第二步: 从图片里识别出金额、日期和消费项目。

第三部: 填写到公司的报销系统里。

第四步: 在系统里点击“提交”按钮。

(二)“粒度”就是任务分解的粗细程度

太粗了不行: “处理发票。” (AI:啊?怎么处理?吃掉吗?)

太细了也不好: “先看发票的左上角第一个像素点,再看第二个...” (AI:这也太啰嗦了!)

刚刚好: “从发票里找到‘总金额’这三个字,然后读取后面的数字。” 这就是合理的粒度。

(三)为什么先做“直线式”流程?

直线流程: 提交 -> 审批 -> 通过。一条路走到黑。

分支: 提交 -> 审批 -> 被拒绝 -> 你修改后重新提交。

吴恩达的意思是,我们先把这种简单的“一条路”或“顶多一两个岔路”的流程自动化做好,就已经能解决很多问题、创造很大价值了。

吴恩达强调应该谈论应用的"自主化程度",而不是简单地判断某个东西是否为"智能体",避免在定义上浪费时间。我们应该关心的是:这个机器人有多大比例的工作能自己完成,不需要人帮忙? 是能独立完成90%,还是只完成10%?这才是衡量它价值的关键。

另外在工作流程中,被低估的技术领域是语音技术,因为这能降低用户使用门槛,比起打字,说话更简短,但开发者关注度不够。

二、组合各种 AI “乐高积木”

当前大量的 AI 工具就像不同颜色和形状的乐高积木。开发者不必精通每个工具,但至少要用过试过,知道这块积木能拼什么。拥有使用这些不同“积木”的经验,开发者才能知道在构建特定功能时需要哪个“奇怪形状的乐高积木”,并能够快速地将它们组装起来完成任务。

比如我们要让AI作为新闻评论员,目标是你给这个AI一个新闻文章的网址,它能自动完成以下三件事:

-

阅读并总结这篇文章的核心观点。 -

为这篇文章配一张合适的、引人注目的图片。 -

把总结和图片一起,发布到你的社交媒体上(比如微博或Twitter)。

这个任务听起来很复杂,但如果我们把它拆解成“乐高积木”,就会变得非常清晰。

(一)第一步:选择你的乐高积木

我们需要以下几块功能各异的“积木”:

积木A:网页抓取

功能: 你给它一个网址,它能把网页上的所有文字内容“抠”下来。

工具: Python。

积木B:文本摘要与分析

功能: 你给它一大段文字,它能读懂并提炼出核心摘要,甚至能分析出文章的“基调”(是积极的还是消极的)。

工具: OpenAI的GPT-4 API、或者Claude API。

积木C:AI绘画

功能: 你给它一段文字描述,它能画出一张对应的图片。

工具: Midjourney API、DALL-E 3 API。

积木D:社交媒体发布

功能: 你给它文字和图片,它能帮你自动登录账号并发布出去。

工具: 微博的API、Twitter/X的API。

(二)第二步:开始拼装

现在,我们把这些积木像流水线一样连接起来:

【积木B】顺利完成任务: “最新报告指出,AI技术正以前所未有的速度重塑全球经济,尤其在医疗和交通领域取得突破。报告呼吁各国加强合作,应对AI带来的伦理挑战。”

“一个由光线构成的医生正在用数据流分析病人的DNA螺旋,背景是穿梭在未来城市中的无人驾驶汽车。”

在这个过程中,你没有亲自去写一个能看懂文章的AI,也没有亲自去开发一个绘画程序。

你只是作为一个“总指挥”,知道了在什么时候、该调用哪个“乐高积木”,并且把上一个积木的产出,作为下一个积木的原料。

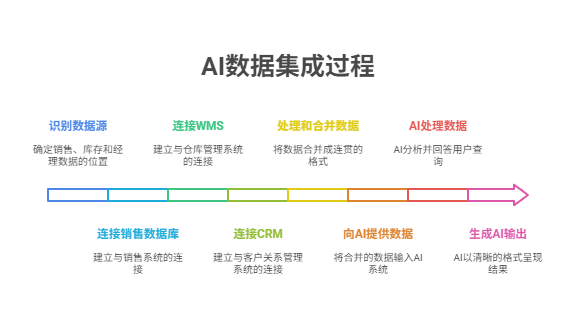

三、构建“管道”(Plumbing)和数据集成

很多时候,开发者需要花费大量时间在数据集成的“管道”工作上,以便为 LLM 提供正确的上下文,使其能够执行有意义的任务。这个铺管子的过程,就是“数据集成”。比如,写代码去连接公司的数据库、调用另一个软件的API、读取某个文件夹里的文件等等。这部分工作非常耗时,但没有它,AI无法发挥大的潜力。

场景示例:打造一个“智能企业小助手”

目标: 公司CEO可以直接问这个AI助手一个问题:“上个季度,我们销售额最高的三个产品是什么?它们的库存还有多少?另外,负责这三个产品的销售经理是谁?”

这个问题看起来简单,但对于一个AI来说,它需要的数据被分散在公司内部的“各个角落”。

(一)找找数据都藏在哪里

产品销售额数据: 藏在公司的销售系统数据库里

产品库存数据: 藏在仓库管理系统 (WMS) 里(可能是一个独立的软件,需要通过API调用)。

销售经理负责人数据: 藏在客户关系管理系统 (CRM) 里(也需要通过API调用)。

如果没有数据沉淀,那意味着AI自动化也无从谈起。

(二)开始铺设管道

管道一:连接销售数据库比如

[ {"product_name": "A-Pro-X1", "total_sales": 500000}, {"product_name": "B-Lite-S2", "total_sales": 450000}, {"product_name": "C-Max-G3", "total_sales": 300000} ]

管道二:连接仓库管理系统 (WMS)

你需要把上一步拿到的产品名(A-Pro-X1, B-Lite-S2, C-Max-G3)作为参数传进去。

{ "A-Pro-X1": {"stock": 120}, "B-Lite-S2": {"stock": 88}, "C-Max-G3": {"stock": 250} }

管道三:连接客户关系管理系统 (CRM)

类似地,查阅CRM的API文档,写代码调用它的“查询产品负责人”接口。

{ "A-Pro-X1": {"manager": "张三"}, "B-Lite-S2": {"manager": "李四"}, "C-Max-G3": {"manager": "王五"} }

(三)数据处理与汇合(最重要的管道工作!)

上述数据是凌乱、独立的。你不能直接把这三个JSON文件丢给AI。你需要把它们整合成一段通顺的、AI能看懂的“上下文”。

-

遍历“管道一”的结果,拿到产品名和销售额。 -

用产品名去“管道二”和“管道三”的结果里查找对应的库存和负责人。 -

把所有信息拼装成一句话。

"背景信息:上个季度销售额排名前三的产品数据如下:

1. A-Pro-X1,销售额50万,当前库存120件,负责人是张三。

2. B-Lite-S2,销售额45万,当前库存88件,负责人是李四。

3. C-Max-G3,销售额30万,当前库存250件,负责人是王五。"

(四)AI做最后的处理

给AI的最终指令(Prompt):

[背景信息]

上个季度销售额排名前三的产品数据如下:1. A-Pro-X1,销售额50万,当前库存120件,负责人是张三。2. B-Lite-S2,销售额45万,当前库存88件,负责人是李四。3. C-Max-G3,销售额30万,当前库存250件,负责人是王五。

[用户问题]

上个季度,我们销售额最高的三个产品是什么?它们的库存还有多少?另外,负责这三个产品的销售经理是谁?

[你的要求]

请根据以上背景信息,以友好、清晰的格式回答用户的问题。

AI输出:

“老板您好!上个季度销售额最高的三个产品及其信息如下:

产品:A-Pro-X1

销售额:50万元 当前库存:120件 销售经理:张三 产品:B-Lite-S2

销售额:45万元 当前库存:88件 销售经理:李四 产品:C-Max-G3

销售额:30万元 当前库存:250件 销售经理:王五”

AI本身并没有去连接数据库或API。你自己要把散落在各处的数据搬运、清洗、整理好,最后形成一份完美的“简报”喂给AI。这个过程就是“构建管道和数据集成”,它是AI应用能够解决实际业务问题的生命线。

四、AI应用应当有评估机制(Evals Framework)

先有评估,再谈优化。即使是很糟糕的评估框架,也比没有强。建议快速构建简单的评估工具(20分钟内),然后逐步改进。 搭建Evals Framework的技能仍然“过于稀缺”。许多团队长期依赖人工评估,这使得他们在出现改动后需要手动检查大量输出。正确的做法是快速搭建简单的评估(即使一开始质量很差),然后通过迭代改进它们,就像迭代改进代码一样。评估框架不仅要能够了解整体系统性能,还要能追踪单个步骤。

eval写作指的是编写评估代码/脚本来自动测试AI系统性能的过程。Eval = Evaluation(评估)的缩写,在AI/ML开发中特指:

-

编写代码来自动测试模型或AI系统的表现 -

创建基准测试来衡量系统是否按预期工作 -

建立自动化的质量检查机制

(一)Eval写作的实际价值

-

减少手动测试时间 -

快速发现问题根源 -

支持快速迭代

(二)实际应用示例

在AI智能体开发中,eval可能包括:

# 智能体工作流程评估

def evaluate_agent_workflow(agent, test_scenarios):

results = []

for scenario in test_scenarios:

# 运行智能体

output = agent.run(scenario["input"])

# 检查关键步骤

step_results = {

"正确理解任务": check_task_understanding(output),

"调用了正确工具": check_tool_usage(output),

"给出合理答案": check_answer_quality(output)

}

results.append(step_results)

return analyze_results(results)更多产品和创业思考:

传统产品未经思考接入AI,好比给马车装上火箭推进器

我教60岁阿姨学AI,产品只能Chat是很蠢的交互设计

五位数的Agent开发商单,我的商业化思考

Token越耗越多,AI产品还能用免费策略推广么

长尾掘金:互联网如何让小众商品找到它的受众?

像烧烤摆摊一样AI创业

读《小米创业思考》,聊痛苦的意义和命运的馈赠

Claude首席产品官的启发:产品化、模型迭代、人机协作的未来

从澳城大创业展回来,聊聊AI出海的机会

AI产品创业如何避免伪需求?我思忖了两个判断标准

R1思维链,不止用来求解