在人工智能飞速发展的今天,明星公司Manus无疑是聚光灯下的常客,其产品和商业模式也引发了诸多讨论与争议。然而,抛开这些纷扰,当我们审视其技术内核时,不得不承认其团队在AI智能体(Agent)领域的探索是深刻且极具价值的。

近日,Manus的创始人Yichao 'Peak' Ji发表了一篇深度复盘文章,坦诚地分享了团队在构建智能体过程中“踩过的坑”和最终沉淀下的工程哲学。这篇文章的核心观点振聋发聩:决定智能体成败的关键,或许并非无休止地追逐更强的基础模型,而是回归本源,做好“上下文工程(Context Engineering)”。

这篇复盘没有空谈理论,而是充满了来自“百万级用户真实测试”的实践智慧。对于所有致力于构建AI智能体的开发者而言,这份“干货满满”的总结,无疑是一份宝贵的战术地图。以下是我们提炼出的六条黄金法则。

法则一:围绕KV缓存进行设计——成本与效率的命脉

在生产环境中,KV缓存命中率是衡量一个AI智能体性能最核心的指标,没有之一。Ji指出,智能体的工作模式是典型的“长输入、短输出”(Manus的输入输出Token比高达100:1),上下文会随着任务的进行滚雪球式地增长。能否有效利用KV缓存,直接决定了产品的延迟和成本。以Claude Sonnet模型为例,命中缓存的Token成本比未命中的要便宜10倍。

Manus的对策:

- 保持前缀稳定

坚决避免在系统提示词等前置上下文中加入时间戳这类动态变量。 - 上下文只增不减

避免修改历史记录,并确保所有数据结构(如JSON)的序列化方式是确定且稳定的,防止“隐形”的缓存失效。 - 显式管理缓存

在必要时,手动标记缓存断点,确保核心指令被有效缓存。

法则二:掩蔽,而非移除——在复杂性中保持稳定

随着智能体能力增强,其工具集会爆炸式增长。一个常见的误区是动态地从上下文中移除当前不需要的工具,以期让模型更“专注”。然而,这是一种致命的错误。

错误做法的代价:

- 缓存灾难

工具定义通常位于上下文前部,任何改动都会导致整个KV缓存失效。 - 模型混淆

当历史记录引用了当前已不存在的工具时,模型会陷入困惑,导致行为异常。

Manus的对策:使用“掩蔽(Masking)”代替“移除”。他们通过一个上下文感知的状态机,在解码阶段通过操纵Token的Logits来动态“屏蔽”或“推荐”某些工具的调用,而不是物理上删除它们。这既保证了上下文的稳定性,又实现了动态的工具选择。

技术深潜:什么是“操纵Logits”?

简单来说,Logits是AI模型在决定输出下一个词(Token)前,为词汇表中所有候选词给出的原始“信心分数”,分数越高,被选中的可能性越大。

“操纵Logits”就是在模型产生这些分数后、将其转换为最终概率前,进行的外科手术式干ervention。例如,通过将非法工具的Logit值直接设为负无穷大,就能“掩蔽”该选项,使其被选中的概率变为0。这种方法不像从上下文中“移除”工具定义那样会破坏宝贵的KV缓存,因此它能在不牺牲效率的前提下,实现对智能体行为的精准、动态控制。

法则三:将文件系统作为“无限”上下文——突破窗口限制

即便是128K甚至更大的上下文窗口,在真实的智能体任务面前也常常捉襟见肘。网页、PDF等非结构化数据能轻易撑爆窗口。同时,过长的上下文不仅昂贵,还会导致模型性能下降。

Manus的对-策:将文件系统视为终极的、无限的上下文。智能体被训练成能够自主地将信息写入文件,并在需要时读回。这种“外部化记忆”的策略,配合可恢复的压缩(例如,在上下文中只保留文件的路径或网页的URL,而非全部内容),实现了在不丢失任何信息的前提下,大幅缩减上下文长度。

法则四:通过“复述”操纵注意力——对抗模型的“遗忘症”

你可能见过Manus在执行任务时,会反复读写一个todo.md文件。这并非多余操作,而是一种精妙的注意力操纵机制。在长达几十步的复杂任务中,大模型很容易“迷失在中间”,忘记最初的目标。

Manus的对策: 通过不断地重写待办事项列表,智能体将最重要的全局计划“复述”到上下文的末尾。这利用了模型对最近信息更敏感的特性,相当于在不断提醒自己“勿忘初心”,从而有效对抗目标漂移。

法则五:拥抱错误——失败是最好的学习数据

智能体在任务中犯错是常态。许多开发者的第一反应是隐藏或清除这些错误记录,让上下文显得“干净”。但Manus的经验恰恰相反:要刻意保留错误信息。

Manus的对策: 将失败的动作、返回的错误码、甚至是堆栈跟踪信息完整地保留在上下文中。当模型看到这些失败记录时,它会像人类一样从中吸取教训,隐式地调整其行为策略,避免重蹈覆辙。在他们看来,出色的错误恢复能力,是衡量高级智能体与简单脚本的核心区别。

法则六:警惕“少样本陷阱”——避免思维僵化

少样本提示(Few-shot Prompting)是提升模型表现的利器,但在智能体中却可能成为陷阱。模型是出色的模仿者,如果上下文中充满了大量重复、相似的成功范例,模型就会陷入“思维定势”,即使外部条件变化,也倾向于僵化地重复已有模式。

Manus的对策:主动在上下文中引入“受控的随机性”。通过在序列化模板、措辞、格式等方面引入微小的结构化变动,来打破上下文的单调性,从而“激活”模型的注意力,使其保持对新情况的敏感和适应性,避免变得脆弱。

结语

Manus创始人的这篇复盘,揭示了一个深刻的行业现实:在通往通用人工智能的道路上,我们需要的不仅是更大、更强的模型,更需要懂得如何与这些模型“沟通”的智慧。上下文工程,正是这门沟通的艺术和科学。

无论外界如何评价Manus这家公司,其团队分享的这些从实战中淬炼出的法则,无疑为整个AI社区提供了宝贵的财富。它提醒我们,真正的护城河,往往建立在这些看似朴实无-华,却直击问题本质的工程细节之上。未来,将由一个个精心设计的上下文构建而成。

原文地址:

https://manus.im/blog/Context-Engineering-for-AI-Agents-Lessons-from-Building-Manus

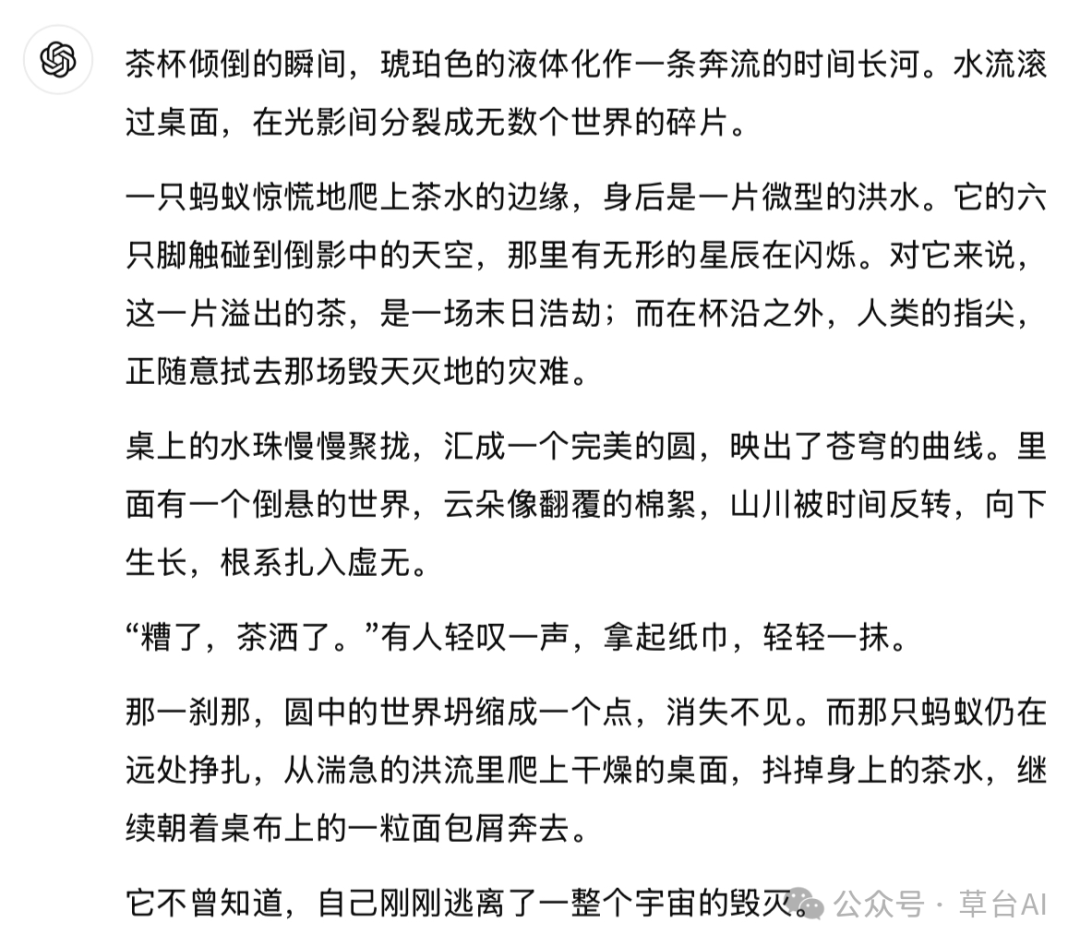

如果您想要让大模型写出优质的短篇小说,以及对其他内容感兴趣,也欢迎点击下面的链接,效果不错哦,很多朋友都说好。

点击这里:超强写作提示词 以及 最强写作指导

效果如下

AI写作批改助手

雪花写作法

prompt自动优化

一文读懂4种AI Agent设计模式