还在为本地部署DeepSeek大模型发愁吗?

今天给大家介绍一个超强神器 - Ollama! 从只有135m参数的“迷你怪兽”,到671B参数的“地球最强AI”,你都能一键拥有!

从只有135m参数的“迷你怪兽”,到671B参数的“地球最强AI”,你都能一键拥有!

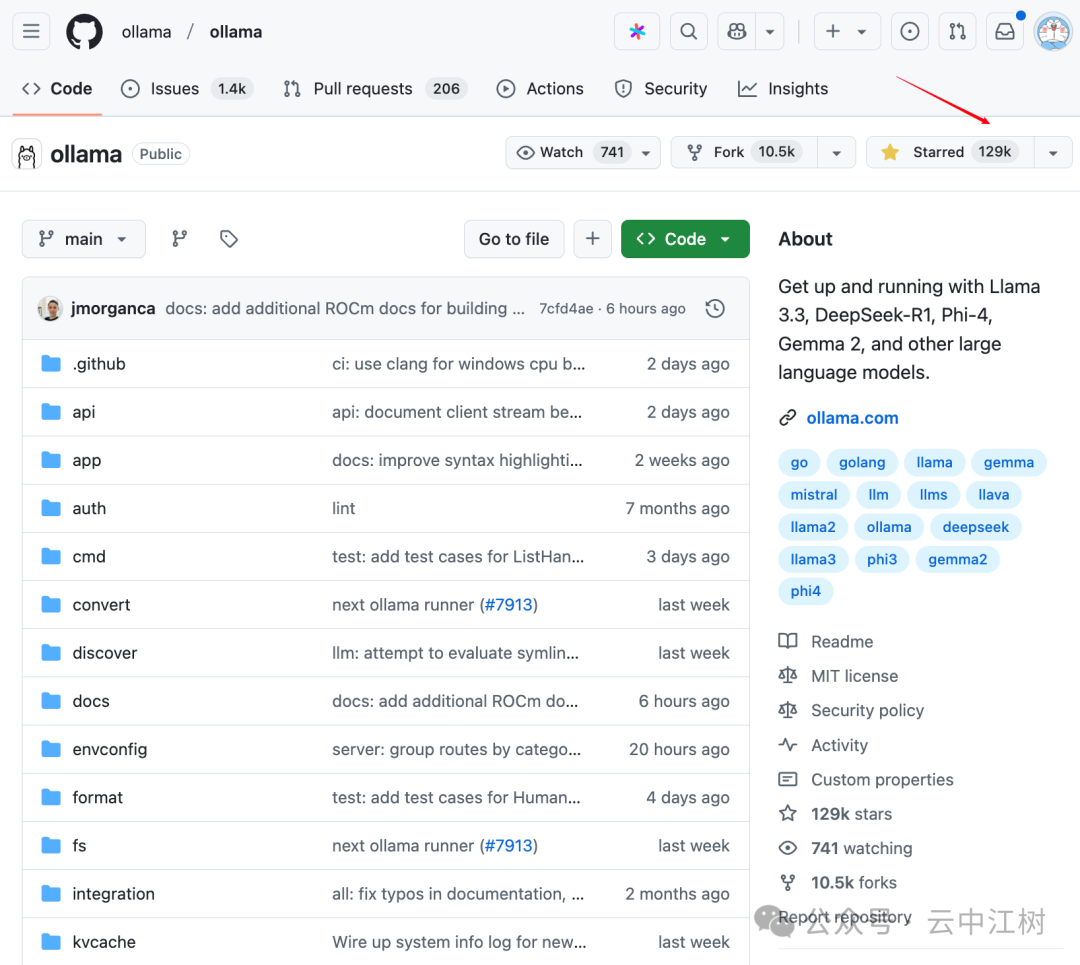

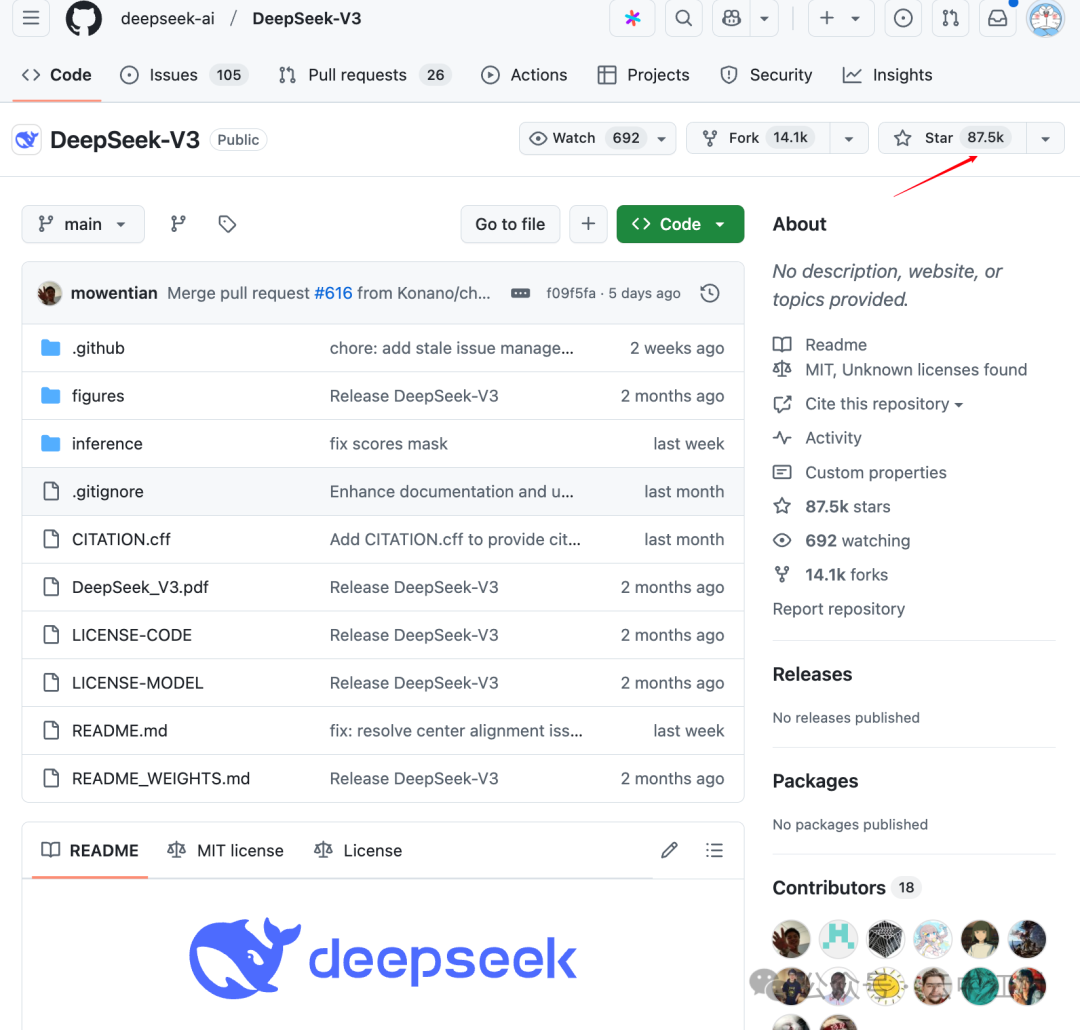

没错,这个工具已经在GitHub上获得了惊人的12.9万Star!

它到底有多强?看看这个数据:比DeepSeek-V3的8.75万Star还要高出整整一个量级!

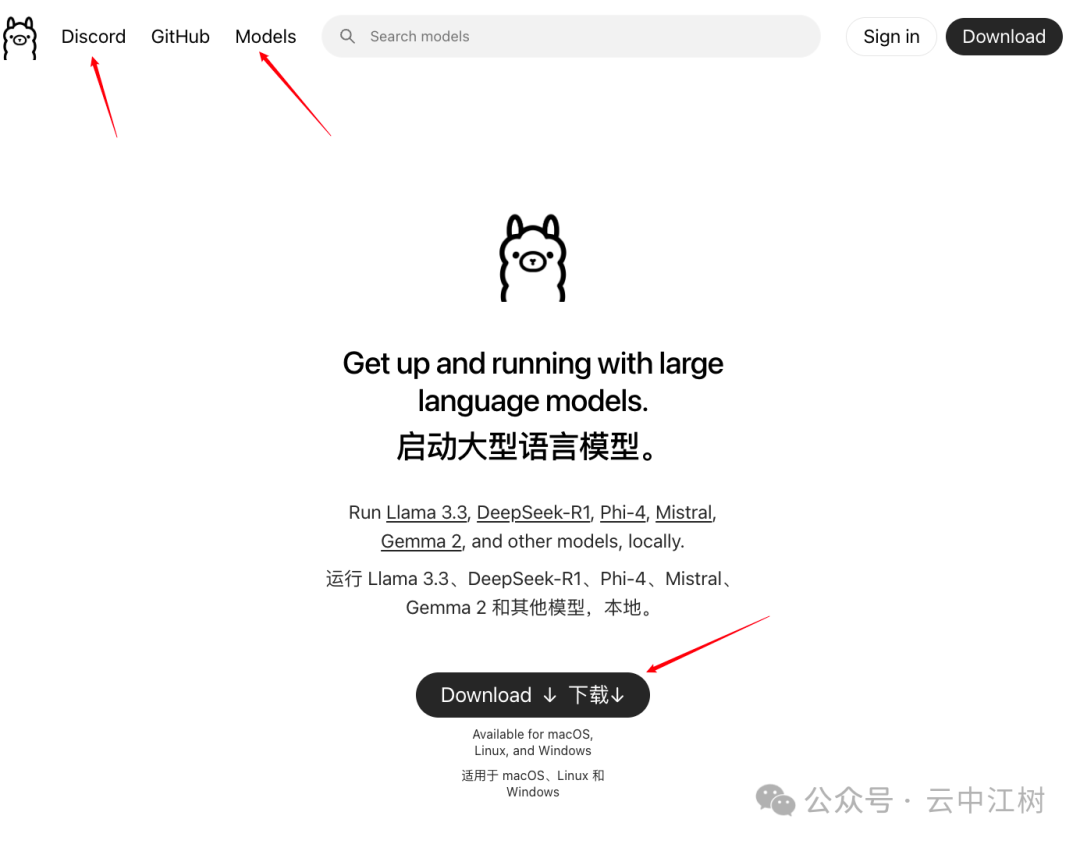

Ollama究竟是什么?

一句话:Ollama让你一键驾驭全球顶级大模型!

从DeepSeek-R1到Qwen,再到Llama 3.3、Phi-4、Gemma 2,啥都有!

官网直达:https://ollama.com/

三大核心功能,一个都不能少:

-

软件下载:一键安装部署 -

模型库:海量顶级模型任你选 -

社区互动:加入Discord论坛(要魔法上网)

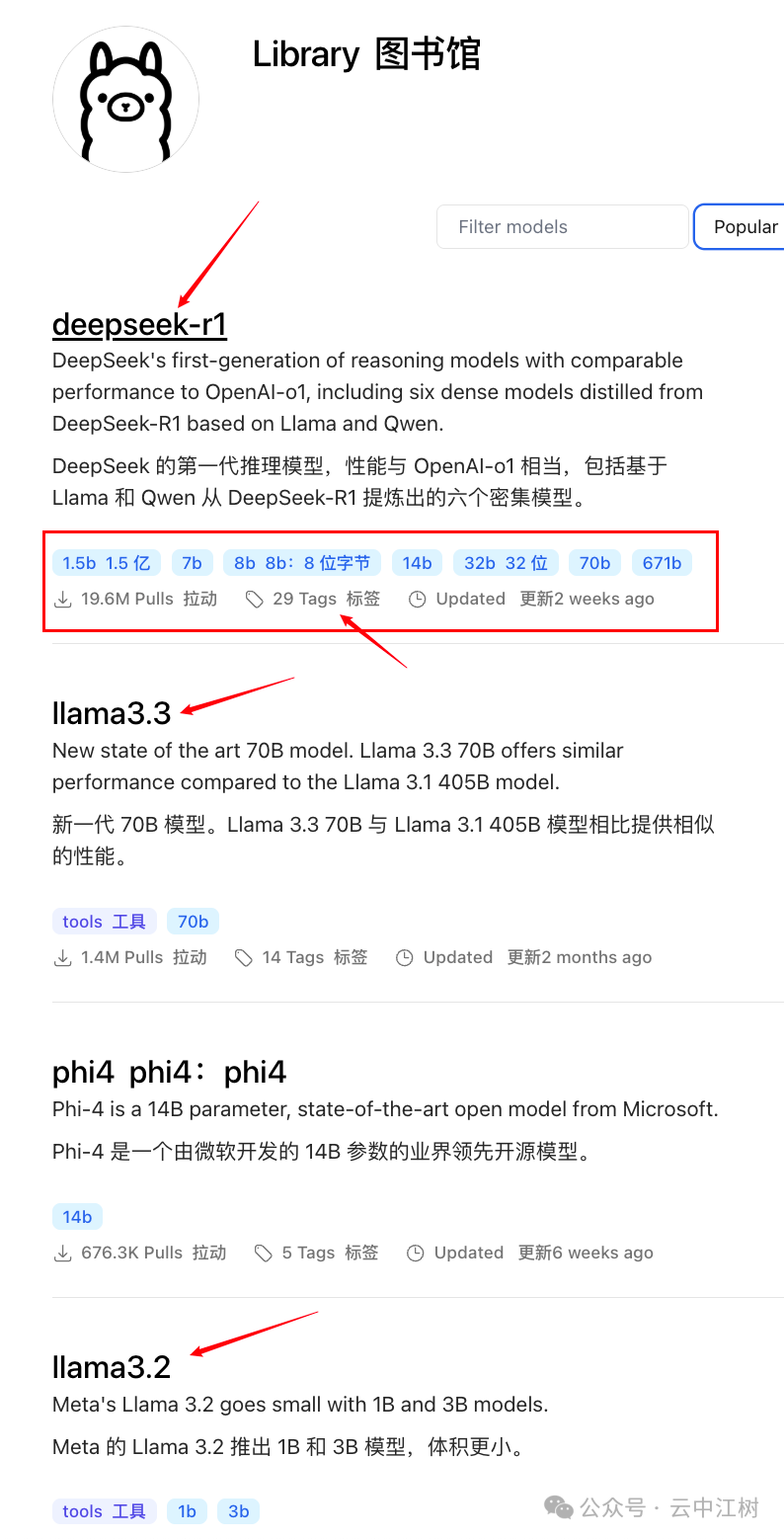

超强AI模型库大揭秘

打开ollama模型库(https://ollama.com/library),

最吸睛的当属DeepSeek-R1!

为什么?因为DeepSeek太强了呗hh!

从1.5B到671B参数,29种不同部署方案,总有一款适合你!

除了DeepSeek-R1,这些模型也超级给力:

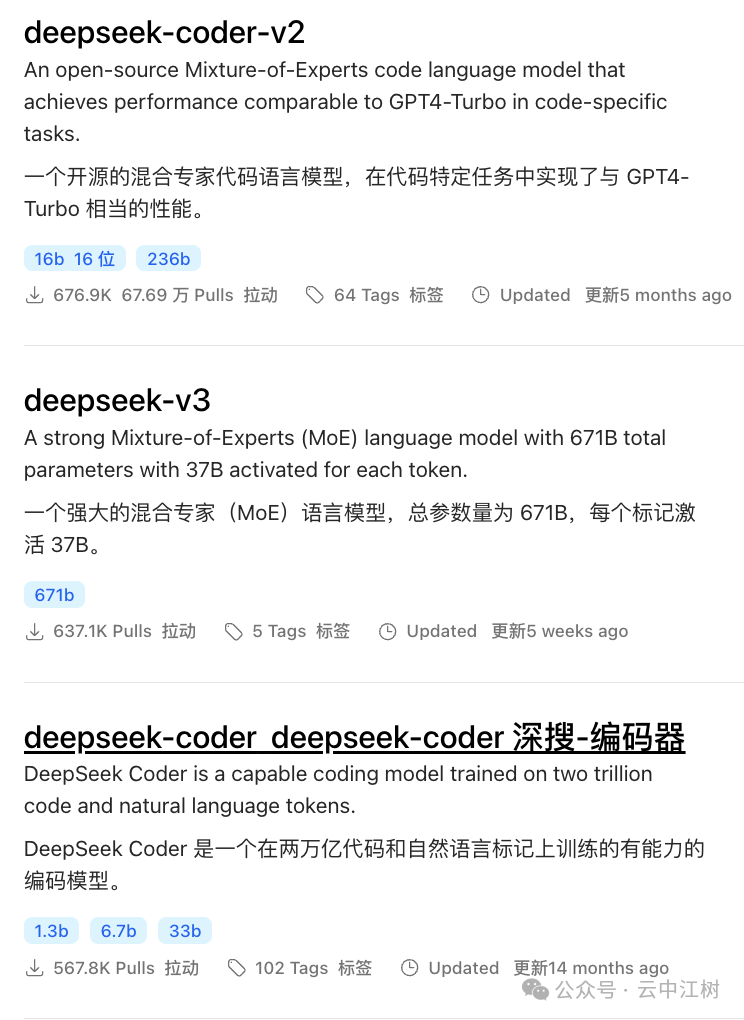

1. DeepSeek全家桶

不只是R1,DeepSeek还有超多实力派:

-

DeepSeek-V3:通用智能王者 -

DeepSeek-Coder:代码领域专家 -

DeepSeek-Coder-V2:最新升级版

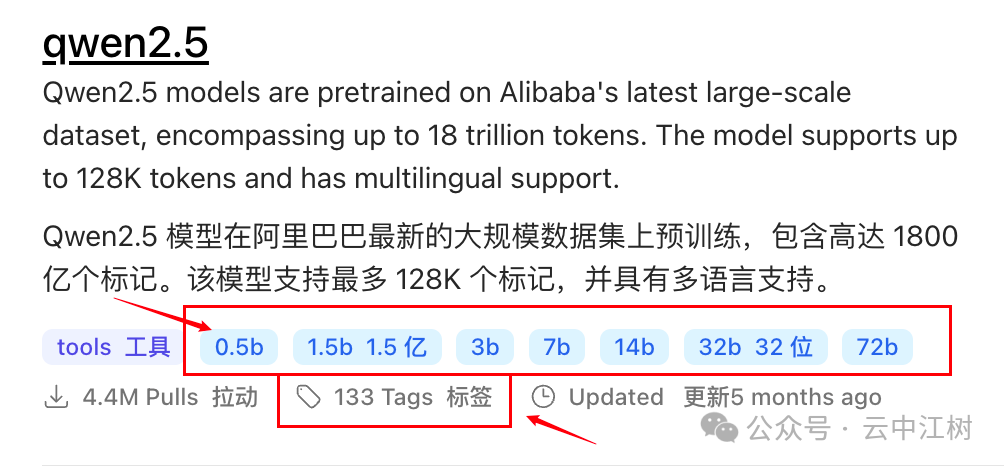

2. 国产之光:阿里Qwen

Qwen2.5系列绝对是实力担当!从0.5B到72B全系列覆盖,性能超强,部署超易!

3. 最迷你大模型:Smollm2

只有135M参数,比Qwen2.5最小版本还要小一半多!完美适配端侧部署!

(小提示:中文场景建议选择Qwen2.5,外国模型中文支持普遍偏弱)

超简单!三步上手搞定AI

Step 1:轻松安装

首先打开官网,选择适合你电脑的安装包:

-

Windows系统:点击下载Windows版 -

Mac系统:选择macOS版本 -

Linux用户:直接选Linux版

?下载太慢?国内专属通道:

链接:https://pan.baidu.com/s/1dlMY-Y-XW2lhbC8Bz9vaTg?pwd=gefg

提取码: gefg

下载后双击安装程序,一路点"下一步"就行,完全不用担心设置问题!

Step 2:简单配置

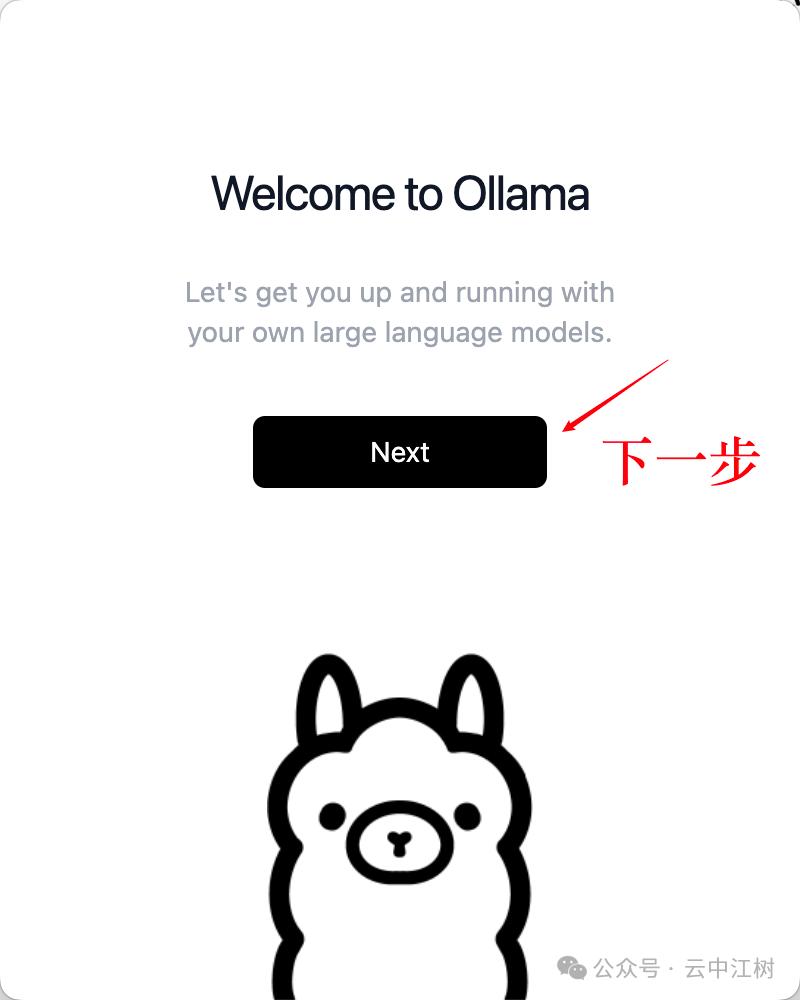

安装完成后,你会看到这个界面:

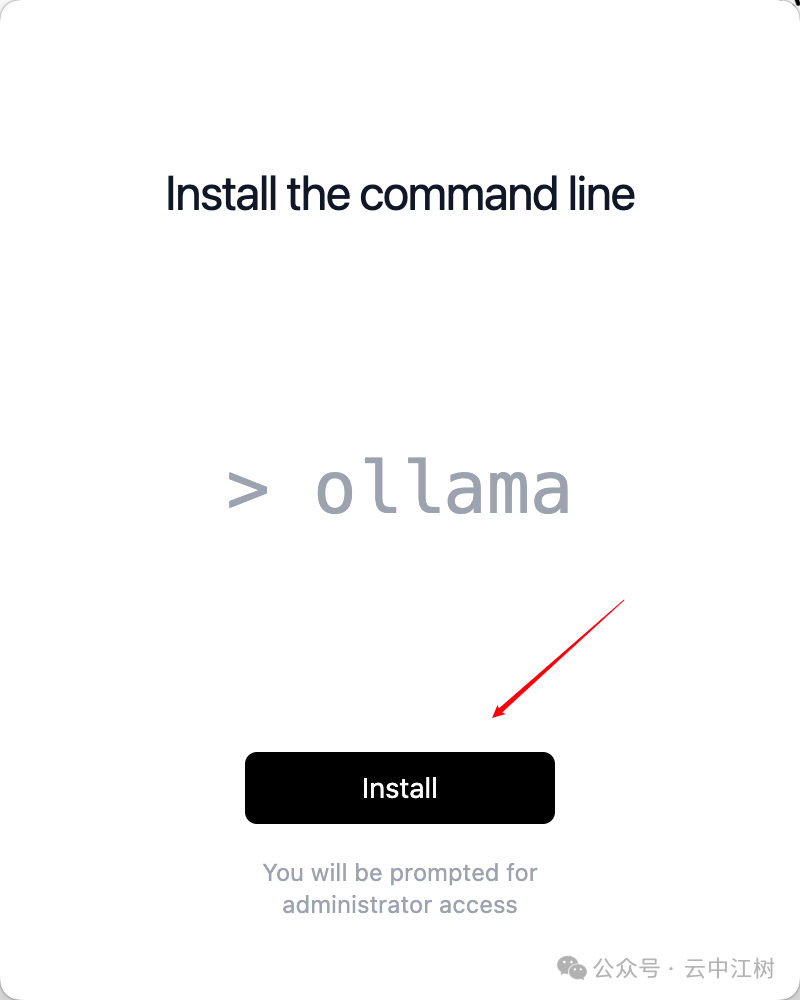

这时会弹出一个框问你"是否允许安装到命令行",选"允许"就对了!

Step 3:开启AI之旅

接下来重点来了!我们要打开"命令行":

-

Windows用户:按Win+R,输入cmd,回车 -

Mac用户:在启动台找到"终端"(Terminal) -

实在找不到?直接按Command+空格,搜"终端"也行!

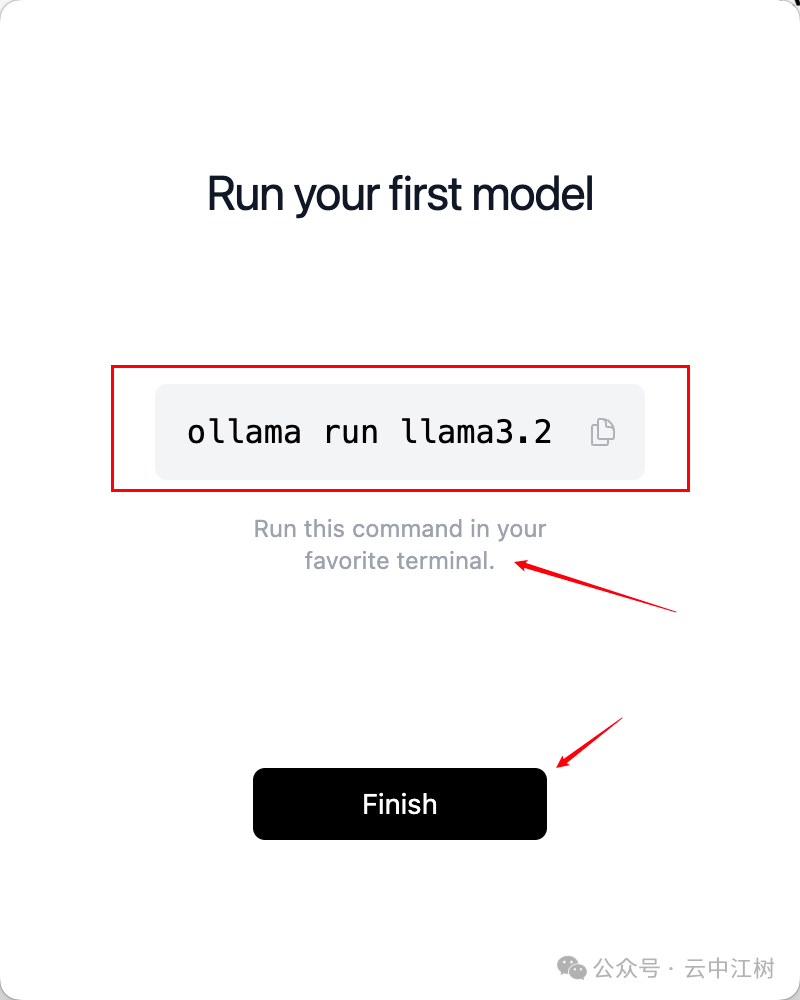

系统默认给了个命令:ollama run llama3.2

但这个模型中文不太行,我们换个更厉害的!

DeepSeek-R1实战攻略

1. 选择合适的模型

打开模型库,找到DeepSeek-R1。这里的选择很关键:

-

1.5B版本:只要1.1GB空间,适合初次体验 -

7B版本:4GB左右,性能更好,推荐日常使用 -

671B版本:需要404GB,土豪专属!

新手建议:先试试1.5B版本,熟悉了再升级!

2. 下载运行

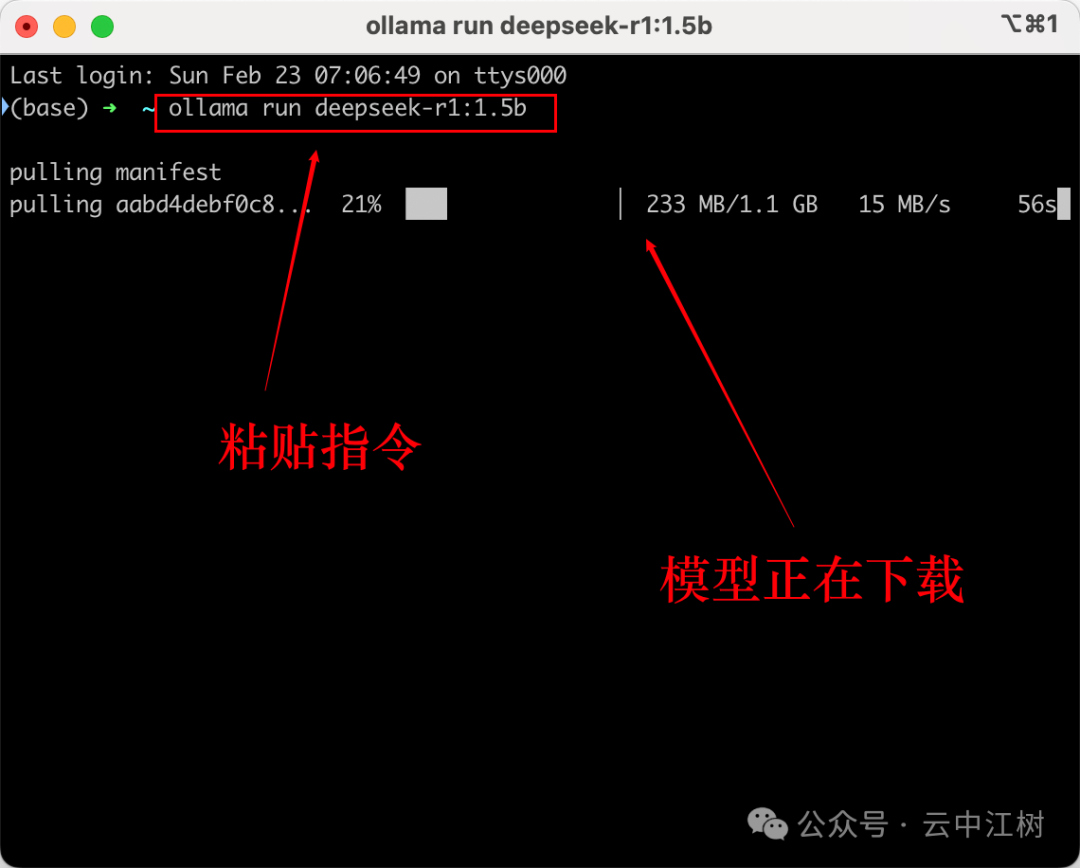

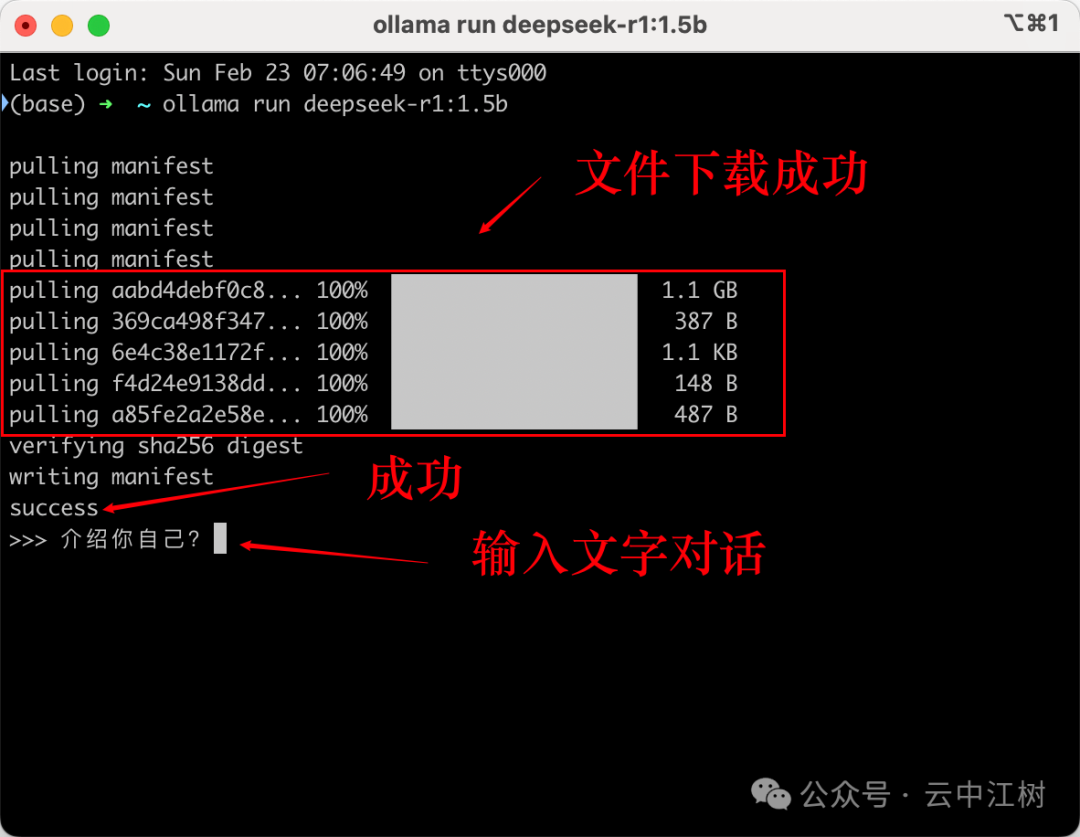

在命令行输入:ollama run deepseek-r1:1.5b

等待下载开始:

看到"success"就是成功啦!如果下载特别慢,可以Ctrl+C中断重试。

3. 实测体验

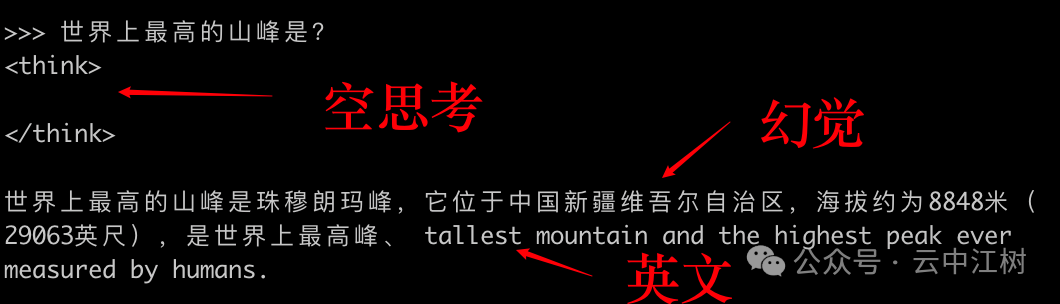

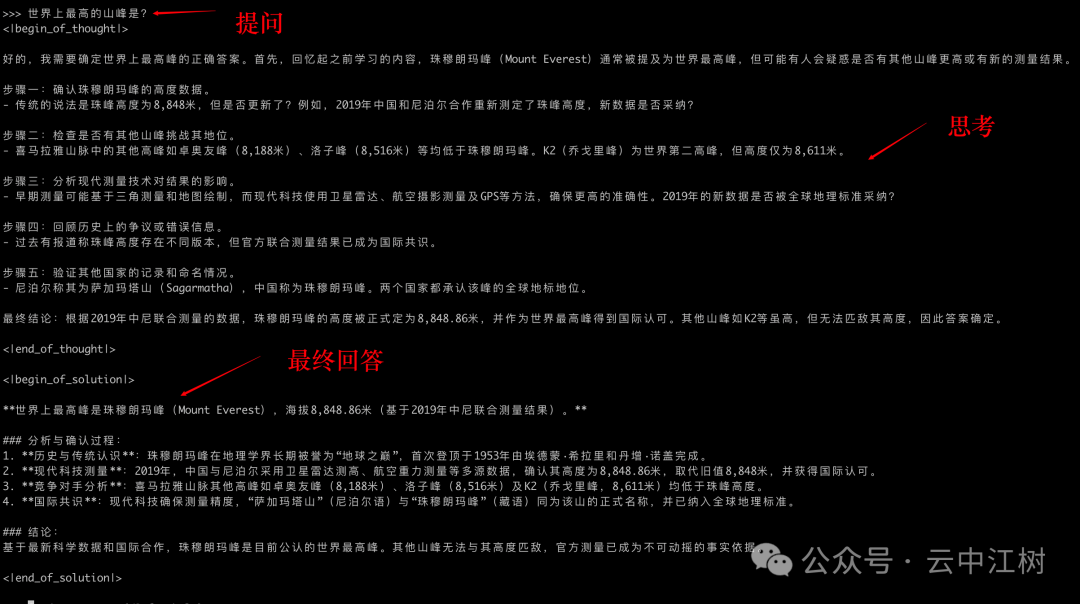

让我们问问:"世界上最高的山峰是?"

1.5B版本的回答:

咦?这回答怎么还带"新疆"?这就是小模型的问题了:

-

容易产生幻觉(说错地理位置) -

中英文混杂 -

回答不够精确

别担心!换个7B版本试试:

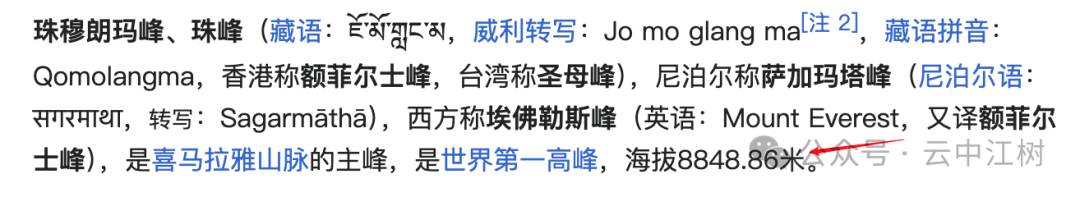

完美!回答准确、清晰、专业!

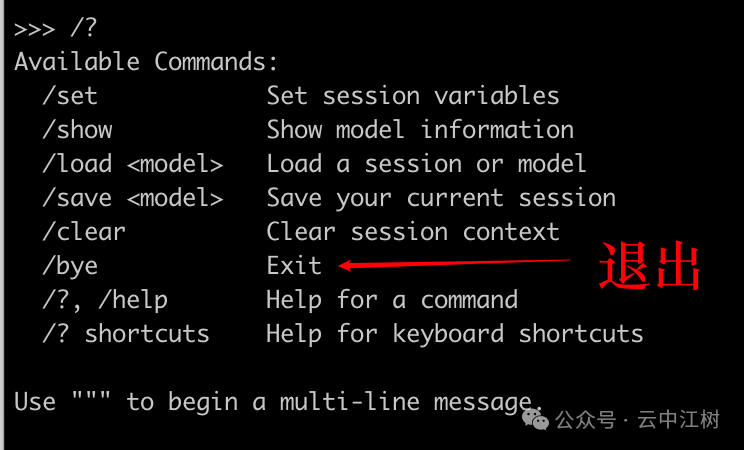

4. 如何优雅退出

聊完了想退出?超简单! 输入/bye,按回车就行!

?小贴士:

为什么要在自己电脑本地部署大模型?

-

数据安全:所有对话都在本地,避免敏感信息泄露 -

低成本:一次部署,永久使用,不用付费 -

高自由度:想怎么改就怎么改,完全掌控在自己手中 -

离线使用:不依赖网络,随时随地都能用

使用小贴士:

-

模型选择建议: -

电脑配置一般:就选1.5B -

8G以上内存:建议上7B -

高配电脑:可以试试更大的模型 -

常见问题: -

下载慢:可以多试几次 -

运行卡顿:选择更小的模型 -

回答不准:换大模型就好

目前在命令行界面不够美观,下期江树将为大家介绍如何把Ollama接入ChatBox等AI聊天界面,让使用体验更上一层楼!

写在最后

如果这篇文章对你有帮助,别忘了:

-

关注「云中江树」 -

点赞+收藏+转发,一键三连支持! -

有问题随时留言交流

我是江树,下期带来更多AI实用技巧,我们不见不散!