引言

在AI发展史上,2023年OpenAI发布了Function Calling功能,让AI模型第一次具备了调用外部API的能力。紧随其后,Anthropic推出了MCP协议,Google发布了A2A框架

三大技术巨头不约而同地瞄准了同一个目标:让AI从封闭的文本生成器,进化为开放的工具操作者。

在这场变革中,三种技术协议扮演着关键角色:

- Function Calling

- 让AI学会使用工具的第一步 - MCP(Model Context Protocol)

- 工具调用的标准化解决方案 - A2A(Agent-to-Agent)

- 多智能体协作的通信桥梁

技术演进脉络

三个发展阶段:

- 第一阶段

:Function Calling - 模型与API的"点对点"调用 - 第二阶段

:MCP - 模型与工具的"标准化接入" - 第三阶段

:A2A - 多个智能体的"协作与通信"

|

|

|

|

|

|---|---|---|---|

| 主要目标 |

|

|

|

| 标准化程度 |

|

|

|

| 学习成本 |

|

|

|

| 适用场景 |

|

|

|

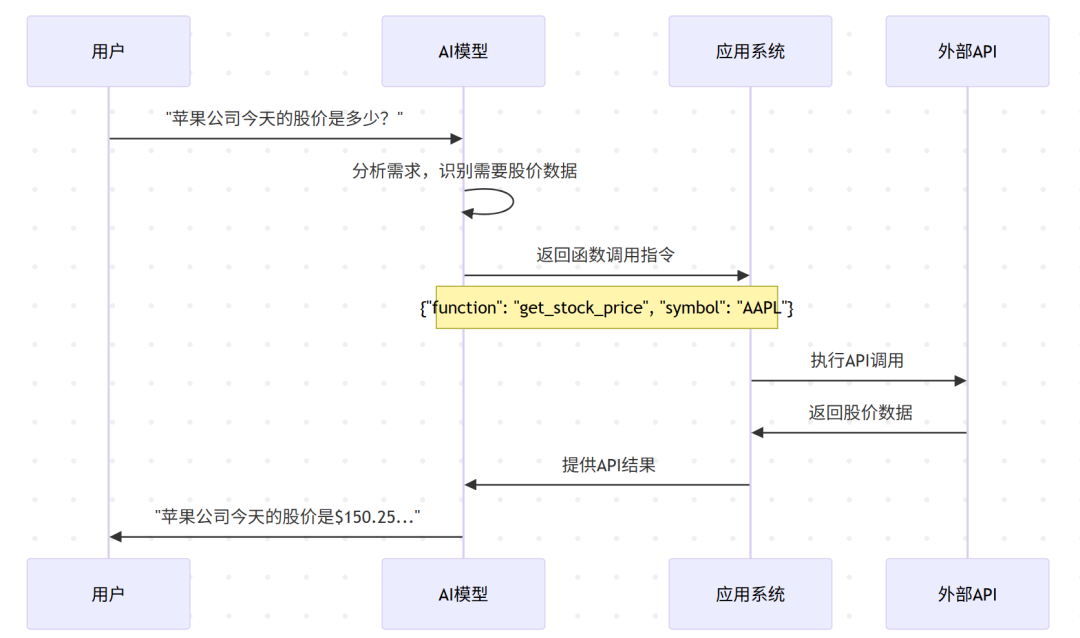

Function Calling:AI的第一把"工具"

背景概述

Function Calling是OpenAI推出的一项突破性功能,它让大语言模型能够识别何时需要调用外部工具,并生成正确的调用参数。

工作机制:

架构组成

优势与局限

核心优势:

- 学习成本低

:开发者只需掌握JSON Schema即可快速上手 - 响应迅速

:单次调用延迟低,适合实时交互场景 - 生态成熟

:OpenAI生态支持完善,文档丰富

关键限制:

- 标准缺失

:各厂商实现差异巨大,代码难以复用 - 流程固化

:无法处理需要多步骤、条件分支的复杂任务 - 维护成本高

:每个应用都需要单独集成和维护工具

MCP:工具调用的"统一标准"

背景概述

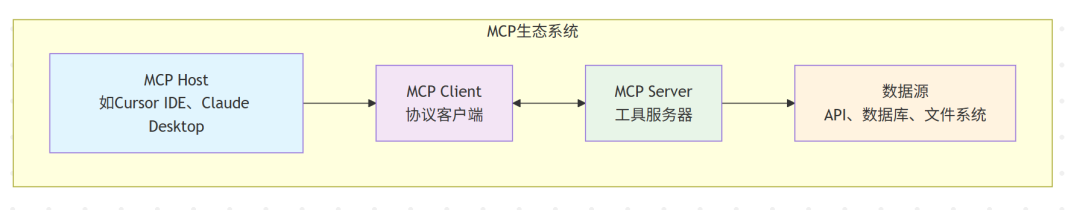

MCP(Model Context Protocol)由Anthropic推出,旨在解决Function Calling面临的标准化问题。它创建了一个统一的协议,让不同的AI模型能够无缝接入各种工具和数据源。

架构设计:

架构组成

简单配置,即刻可用

以Cursor IDE集成Firecrawl为例,只需在配置文件中添加几行设置,就能获得强大的网页抓取能力。无需编写任何代码,AI助手立即具备了:

-

网页内容抓取 -

批量URL处理 -

结构化数据提取 -

搜索引擎集成

丰富的社区生态

MCP社区已经提供了大量现成的服务器:

- 数据库连接器

:支持MySQL、PostgreSQL、MongoDB等 - 云服务集成

:AWS、Azure、Google Cloud等 - 开发工具

:Git、Docker、Kubernetes等 - 办公软件

:Notion、Slack、Trello等

核心优势

标准化协议

-

一次开发,多模型复用 -

统一的工具发现和调用机制 -

降低集成复杂度从M×N到M+N

生态丰富

-

社区贡献的大量MCP服务器 -

覆盖数据库、API、文件系统等各种数据源 -

持续增长的工具生态

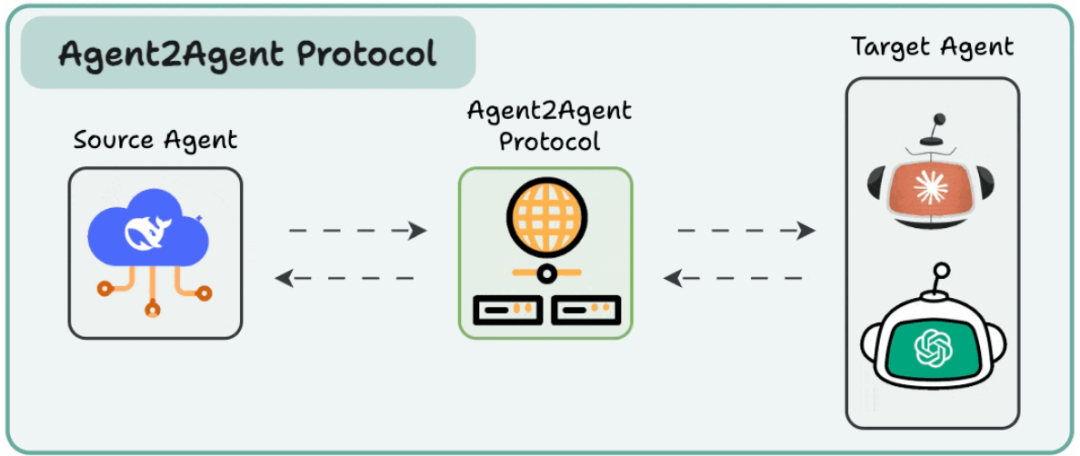

A2A:智能体协作的"通信语言"

背景概述

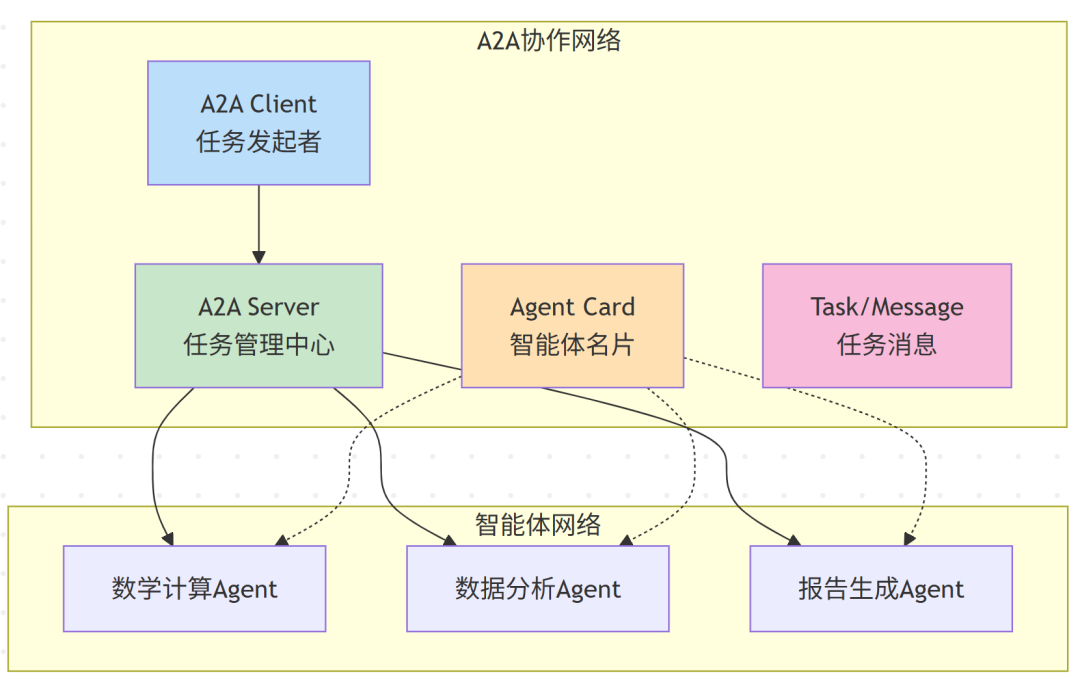

A2A(Agent-to-Agent)协议是Google推出的开放标准,专门解决多个AI智能体之间的通信和协作问题。与前两者不同,A2A关注的是"智能体如何与智能体对话"。

核心组件:

架构组成

核心组件:

- Agent Card

:Agent的"电子名片",描述其能力、接口、权限等 - A2A Server

:管理任务分发与协同执行 - A2A Client

:负责发起任务的应用或Agent - Task/Message

:表示任务和任务过程中的消息交换

协作优势

智能任务分解

-

复杂任务自动拆分为子任务 -

根据Agent能力智能分配工作 -

支持并行处理提高效率

容错与扩展

-

单个Agent故障不影响整体系统 -

新Agent可以动态加入协作网络

三者关系:分工协作、未来融合

可以把三者理解为AI系统中不同层级的能力:

层级关系:

- Function Calling

:模型与API的"点对点"调用 - MCP

:模型与工具的"标准化接入" - A2A

:多个智能体的"协作与通信"

未来很可能看到这三种机制融合在一个统一系统中,例如模型通过MCP调用工具,又通过A2A与其他模型协作完成任务。这将极大增强AI系统的自动化能力和复杂任务的处理能力。