阿里这一周,真的要翻天了!

👆先用狠图震场,可点击放大详细查看👆

就在美国刚刚发布雄心勃勃的AI 行动计划,要把美国打造成「世界无可争议的AI 冠军」之时,阿里通义用一连串重磅模型发布,给这份计划来了个措手不及的暴击。

这份刚出炉的美国AI 行动计划,包含90个要点,分为三大支柱:加速AI 创新、建设AI 基础设施、领导国际AI 外交和安全。特朗普政府雄心勃勃,要削减繁文缛节、大规模扩建电网、收紧对先进芯片的出口管制。

但计划刚发布,阿里的连环出击似乎就在告诉白宫——

你们的计划可能要重新考虑了。

本周,阿里AI 三连发,从7月22日到25日,接连推出三款震撼业界的模型。

先是Qwen3-235B非思考版本横空出世,紧接着23日发布480B参数的Qwen3-Coder,今天(7月25日)更是压轴推出了Qwen3-235B-A22B-Thinking-2507推理模型。

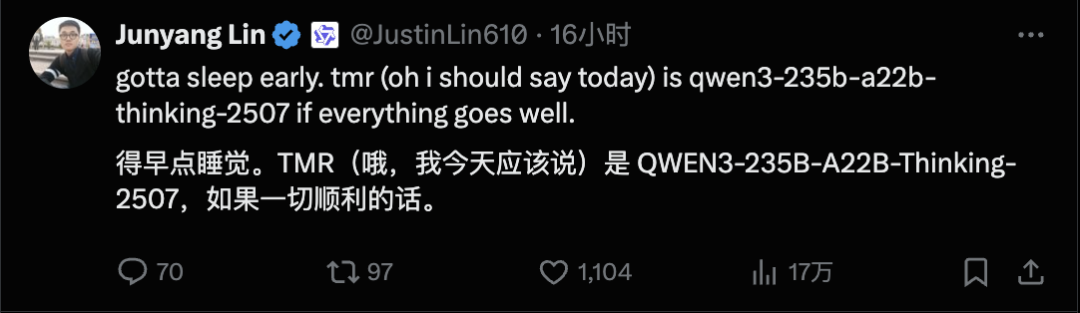

昨天凌晨,千问团队的林俊阳(@JustinLin610)发了一条让人期待了一整天的推文:

得早点睡了。明天(哦我应该说今天)如果一切顺利的话,就是qwen3-235b-a22b-thinking-2507了。

看到这条消息,我就知道阿里这是要玩个疯狂一周啊!

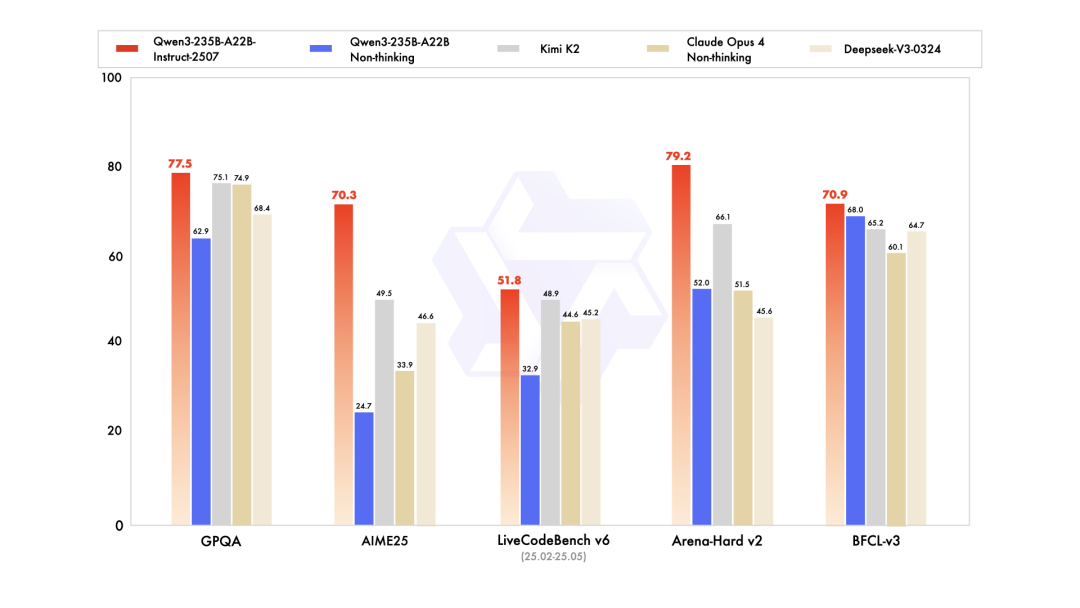

非思考模型称王

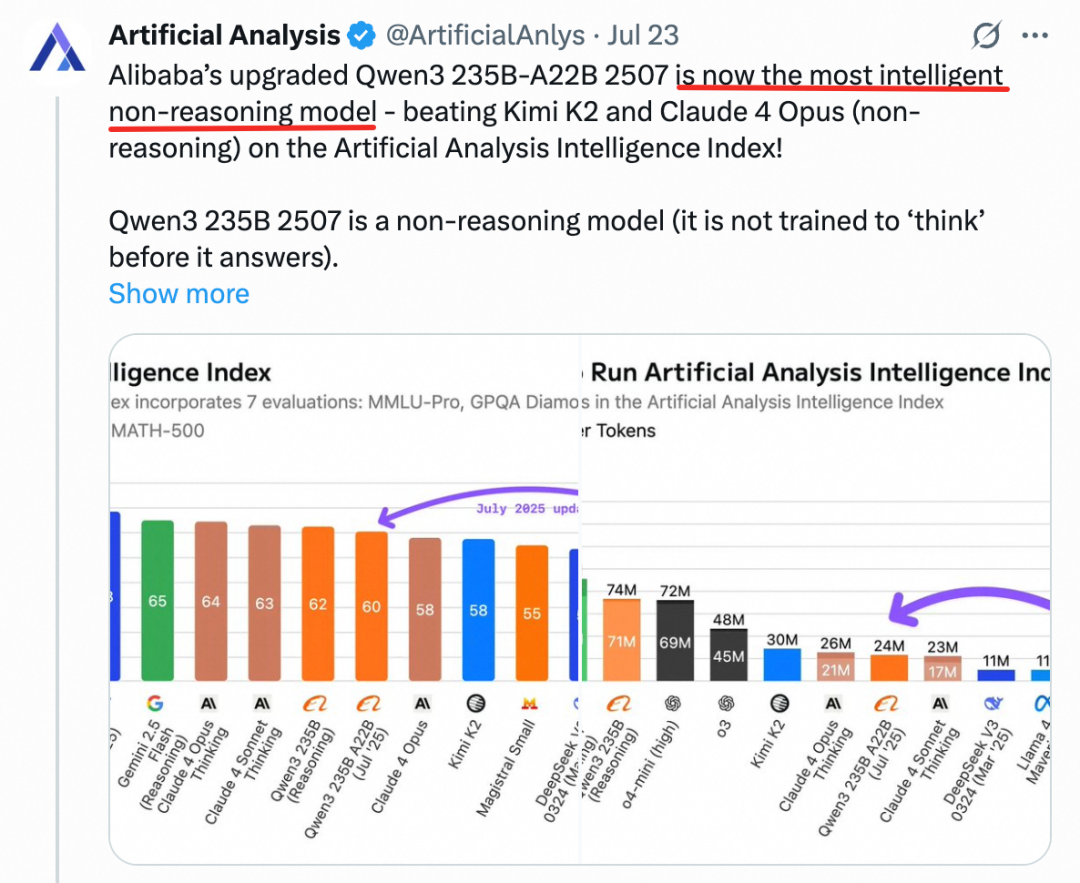

在非推理模型领域,千问3已然成为全球最强。

3天前开源的Qwen3-235B-A22B-Instruct-2507(非思考版)新模型,性能显著提升,在GPQA(知识)、AIME25(数学)、LiveCodeBench(编程)、Arena-Hard(人类偏好对齐)、BFCL(Agent能力)等众多测评中表现出色,超越Claude4(Non-thinking)等领先闭源模型。

权威AI 研究机构Artificial Analysis指出,「千问3是全球最智能的非思考基础模型」。

Qwen3-Coder

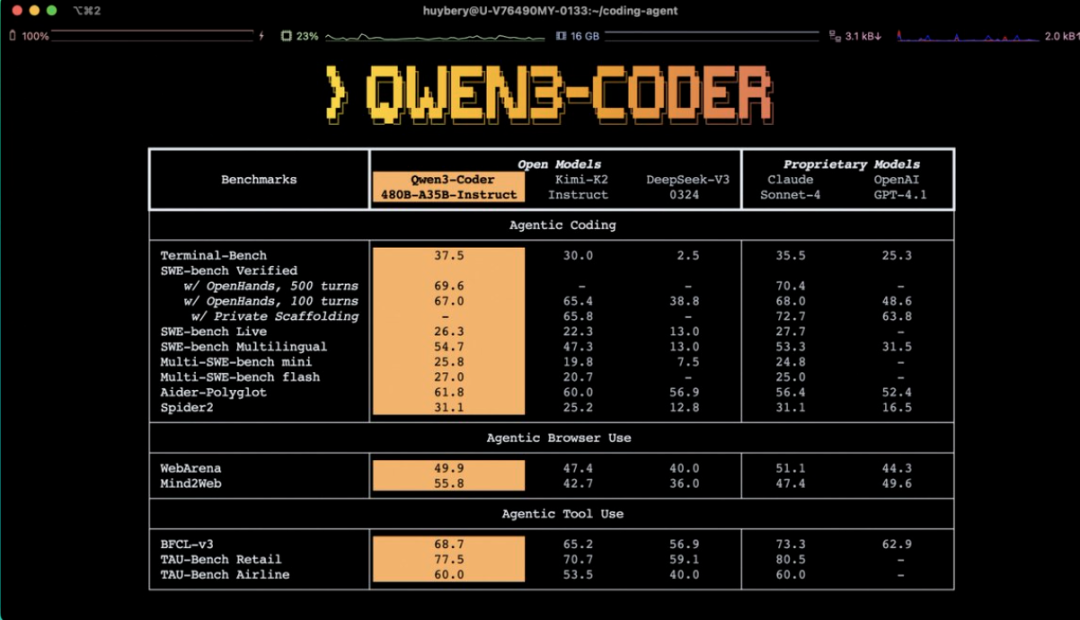

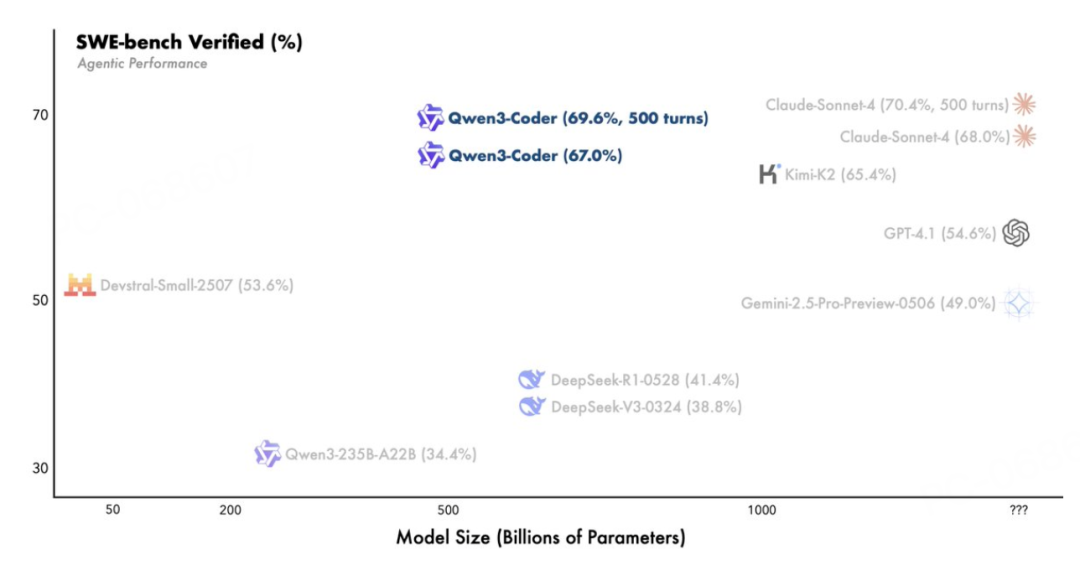

7月23日发布的Qwen3-Coder更是一个基于MoE架构的庞然大物,总参数达到480B,激活参数35B,原生支持256K上下文,可扩展至1M。

在SWE-bench Verified这个开发者最关注的基准测试上,Qwen3-Coder取得了开源模型中的最佳表现。

更重要的是,阿里不仅开源了模型,还推出了配套的命令行工具Qwen Code,基于Gemini CLI开发但针对Qwen3-Coder进行了深度优化。

LM Studio(@lmstudio)第一时间支持了这个模型,并指出:

Qwen/Qwen3-Coder支持工具调用,现已在LM Studio 0.3.20中可用。480B参数,35B激活。本地运行大约需要250GB。

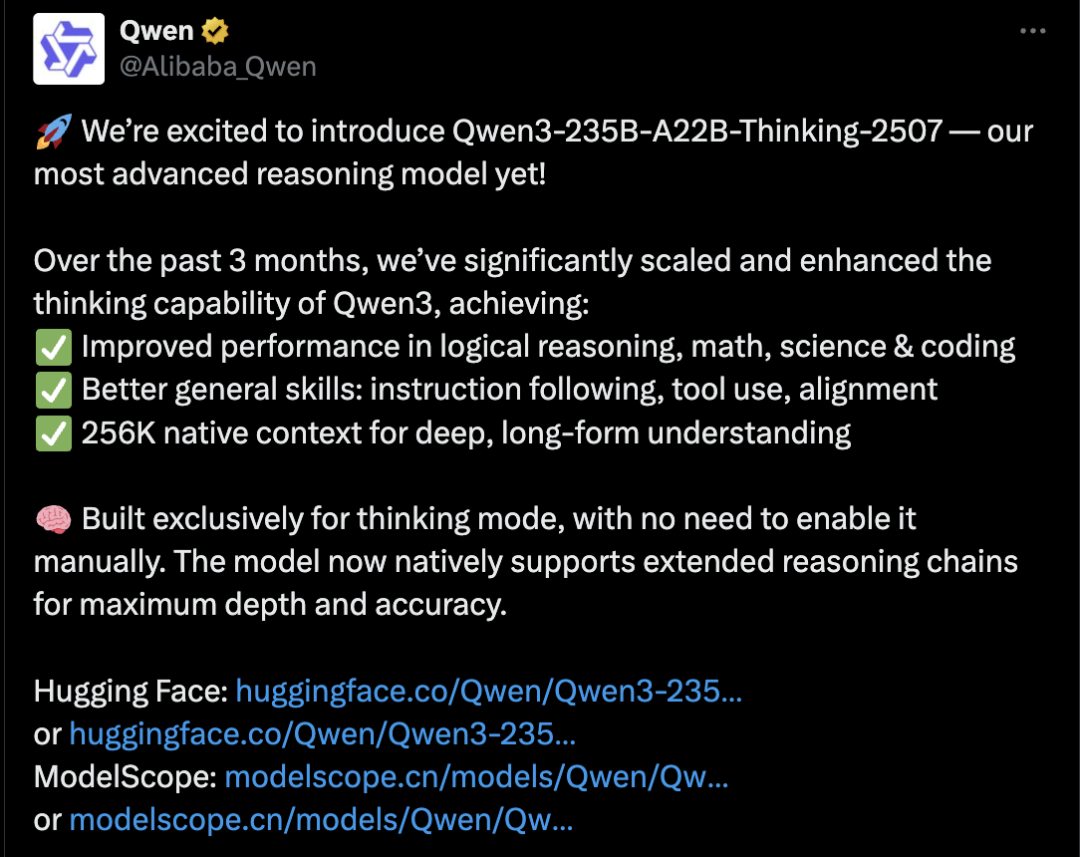

重磅推理模型横空出世

回到今天的重头戏——

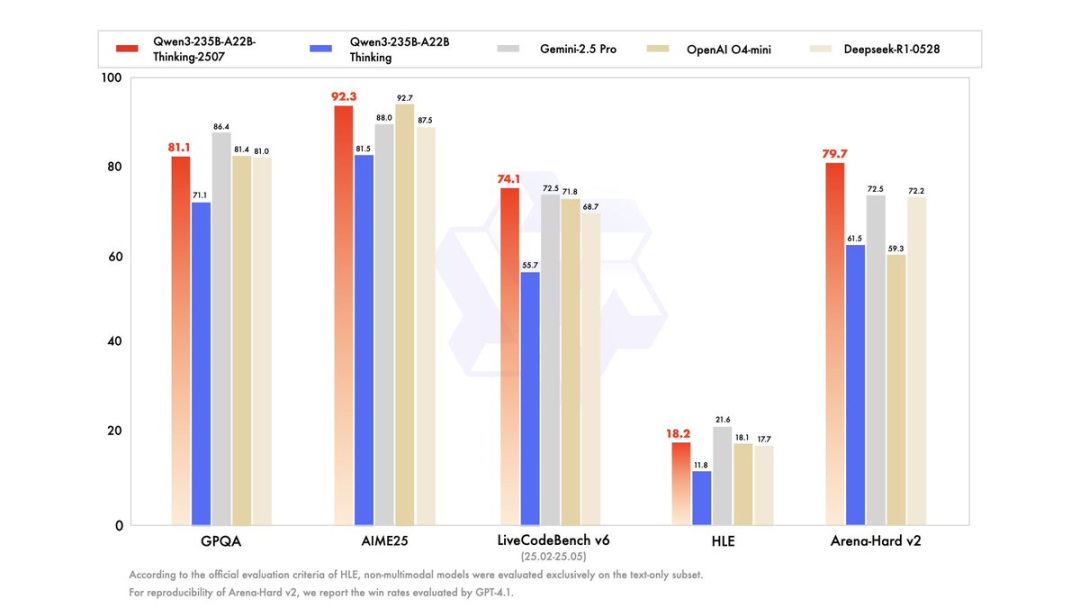

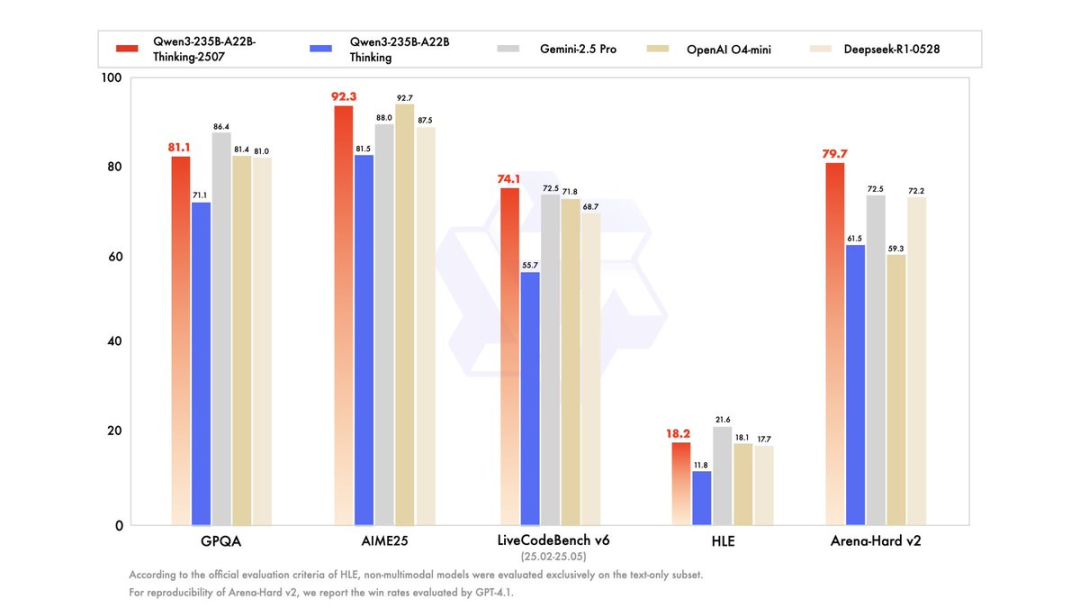

千问3推理模型重磅更新,比肩Gemini-2.5 pro、o4-mini。

就在刚刚,阿里巴巴全新开源千问3推理模型,性能大幅提升,一举夺下「全球最强开源模型」王座,比肩顶级闭源模型Gemini-2.5 pro、o4-mini。

本周阿里已连续开源3款重磅模型,分别斩获基础模型、编程模型、推理模型等主流领域的三项全球开源冠军。

最新推出的千问3推理模型,登顶全球最强开源推理模型。

自千问3旗舰模型Qwen3-235B-A22B发布后,阿里通义团队一直在扩展大模型的推理极限,全新开源的千问3推理模型在通用能力和深度思考能力上实现巨大飞跃。

性能跻身顶尖模型最强行列:

-

AIME25(数学):92.3分,超越大多数闭源模型

-

LiveCodeBench v6(编程):74.1分,全面领先

-

WritingBench(写作):88.3分,创意能力出众

-

PolyMATH(多语言数学):60.1分,多语言能力顶尖

从技术架构来看,Qwen3-235B-A22B-Thinking-2507具有以下核心特性:

-

参数规模:总参数235B,激活参数22B

-

架构设计:94层,64个注意力头(Q),4个键值头(KV)

-

专家系统:128个专家,激活8个

-

上下文长度:原生支持262,144 tokens

模型专为思考模式构建,默认聊天模板自动包含<think>标签。

使用代码示例:

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "Qwen/Qwen3-235B-A22B-Thinking-2507"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype="auto",

device_map="auto"

)

# 模型会自动进入思考模式

messages = [{"role": "user", "content": "给我简短介绍一下大语言模型。"}]

网友炸了

全球网友也是被通义的最强推理模型给炸了……

网友DDT 表示直接惊呆:

JB 则称:中国开源了o4-mini!

AI Thinkers(@TheAIThinkers) 更是评论道:

🚨 🇨🇳 中国刚刚投下了一个怪物级AI 模型

Qwen3-235B-Thinking来了: 阿里巴巴迄今最强大的推理模型 🤯

✅ 提升的逻辑、数学、科学、代码能力 ✅ 256K上下文长度 ✅ 自动启用深度推理模式

🇨🇳 中国推动AI 边界的力度太猛了。🚀 🚀

Amila(@amila_wjsr)也给出了专业点评:

Qwen3-235B-A22B-Thinking-2507在推理能力上实现了惊人的飞跃。逻辑、数学和多领域深度的无缝扩展非常出色——256K原生上下文窗口对自主智能体工作流来说是变革性的。LLM扩展推理的新时代!🚀🤖

Paulo Batalhão(@batalhao)还在对两天前的Qwen3-Coder激动不已:

🤯 480B参数,35B激活?! 这绝对不可思议!

恭喜取得这一巨大成就!规格令人震惊: • 480B MoE,35B激活参数——前所未有的规模 • 256K原生上下文,通过外推扩展到1M • 在开源模型中SWE-bench-Verified性能顶尖 • 内置原生智能体编程能力 • 开源Qwen Code CLI工具(基于Gemini Code分支) • 与现有开发者工作流无缝集成

「世界中的智能体编程」愿景正是我们所需要的!

还有网友送上模型对话调侃模型命名:

「我用4o,你呢?」

「哦,我只是用qwen3-235b-a22b-thinking-2507」

话说这模型名,属实是有点长……

胜在比OAI 的4o-mini, o4-mini 啥的好分辨多了

不完美的小插曲

当然,本周的疯狂发布中也有些意外的小插曲。

有用户反馈Qwen Code在使用时费用较高,甚至出现了「一个/init指令,直接从充100变成欠179.36」的情况。

对此,阿里官方已经给予了费用减免,并表示正在优化计费系统。

但也有网友在对比了Qwen3-Coder和Claude Code处理同一问题的结果后,发现Qwen3-Coder的处理其实更准确:

虽然在我昨天对接上cc(claude code)给我一条问题就给我扣欠费了28,今天各种骂。但是今晚当通义灵码扩展(免费搞)上了q3c(qwen3-coder),我拿它与cc处理同一个问题,就是一个处理后,把文件复制一份,原文件还原,又让它处理另外一个。发现cc处理的是错的,它还是先处理的,一个是我是用提及限制了文件,q3c后处理的对的,它也没被干扰。

此外,魔搭社区也提供了每天免费两千次的使用额度,让更多开发者能够体验。

关于费率问题,有国内网友表示理解:「这是预期中的,毕竟阿里没学OpenAI 吊胃口灰度,也没学其他家饥饿式的邀请码,算是足够厚道了。」

我个人目前还在使用Claude Code,主要是由于许多项目一直在用,并设置了不少hooks和commands。但对于那些无法方便使用Claude Code的开发者,Qwen3-Coder确实是个值得尝试的选择。

也希望Qwen团队能够进一步完善Qwen Coder的周边能力,不要被Google 开源Gemini CLI 给拖累了,可以参考Claude Code的实现取长补短(确实有许多值得借鉴之处),多关注核心用户的真实反馈并真正提升体验。

等我的CC 会员到期了,希望q3c 能承受住我的暴力轰炸

中国开源vs 美国闭源

回看美国的AI 行动计划,读起来像一家雄心勃勃的科技公司路线图,需要跨机构协调、数十亿美元资金,还可能需要一些许可方面的奇迹。

而相比之下,阿里用实际行动证明:与其制定宏大计划,不如直接交付强大产品。

当美国还在讨论如何扩建电网来支撑AI 发展时,阿里已经把全球最强的开源模型摆在了所有人面前。这不仅是技术实力的展示,更是对全球AI 发展路径的一次重新定义。

开源,正在成为中国AI 弯道超车的密码。

真正重要的不是谁在大写特写「必赢」的计划,而是谁在真正行动、定义未来。

当阿里用疯狂的一周刷新开源AI的天花板时,全球开发者用脚投票,选择了开源,选择了创新,选择了更加开放的千问。

这或许就是对美国AI 行动计划最好的回应:

别光说,来真的。

Qwen3-235B-A22B-Thinking-2507 (Hugging Face): https://huggingface.co/Qwen/Qwen3-235B-A22B-Thinking-2507

[2]Qwen3-235B-A22B-Thinking-2507-FP8: https://huggingface.co/Qwen/Qwen3-235B-A22B-Thinking-2507-FP8

[3]ModelScope: https://modelscope.cn/models/Qwen/Qwen3-235B-A22B-Thinking-2507

[4]Qwen Code (GitHub): https://github.com/QwenLM/qwen-code

[5]Qwen3-Coder模型: https://hf.co/Qwen/Qwen3-Coder-480B-A35B-Instruct

[6]官方博客: https://qwenlm.github.io/blog/qwen3-coder/

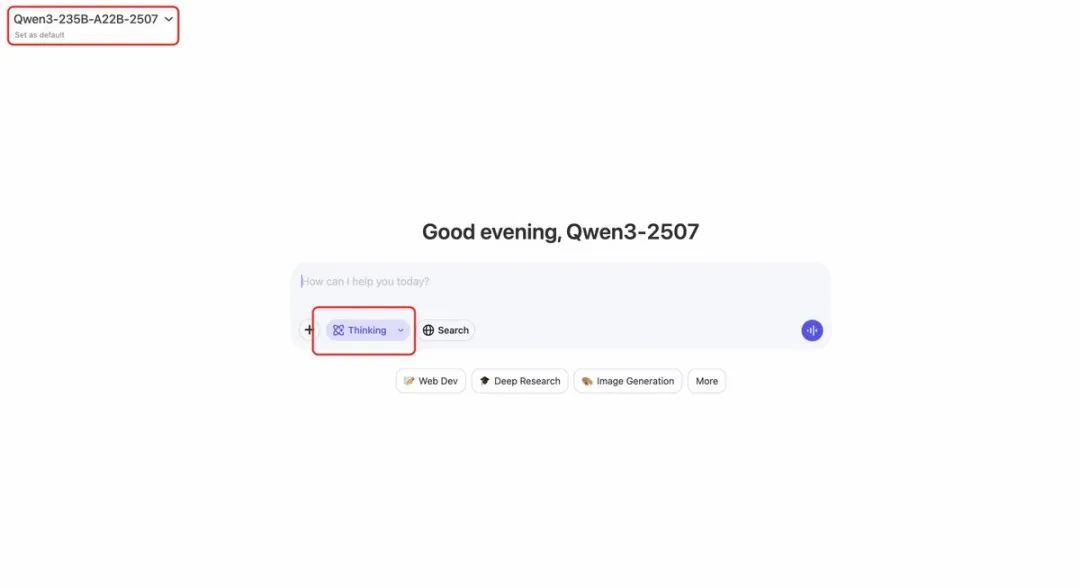

[7]在线体验: https://chat.qwen.ai/

👇

👇

👇

另外,我还用AI 进行了全网的AI 资讯采集,并用AI 进行挑选、审核、翻译、总结后发布到《AGI Hunt》的实时AI 快讯群中。

这是个只有信息、没有感情的 AI 资讯信息流(不是推荐流、不卖课、不讲道理、不教你做人、只提供信息、希望能为你节省一些时间)

欢迎加入!

也欢迎加群和5000+群友交流。