如火如荼的大模型应用落地,其系统设计中不可或缺的一环便是科学、可落地的评估体系。

这不仅是指引效果迭代的依据,更是项目顺利交付的基石。

因此,一套完善的评测框架至关重要。

其核心在于:业务方需根据自身客户诉求与实现难度,设计类似GAIA的多等级定制化测试集;而交付方则需确保在双方约定的、固定数据集上的整体准确率达标。

可评估性与Benchmark挑战

评估AI Agent的能力比评估单轮问答的LLM更加复杂。 后者通常用准确率、BLEU等指标衡量固定输出是否正确,而Agent可能涉及交互过程、中间产出以及最终结果的综合评判。 例如,一个Agent可能通过不同路线完成任务:有的步骤多但很稳妥,有的步数少但冒风险。我们需要既看它是否完成任务,也看用多长时间/步骤、是否高效、过程是否符合规范等。 因此,一套完善的评测框架至关重要。

目前比较通用的评估标准是GAIA基准(前期出现的 Manus 使用的就是)。

GAIA,是一个通用人工智能助手的基准测试。如果能解决这个测试,那将是人工智能研究的一个重要里程碑。GAIA提出了一些真实世界中的问题,这些问题需要一系列基本的能力,比如推理、多模态处理、网页浏览,以及一快捷的工具使用技巧。对人类来说,GAIA的问题在概念上很简单,但对大多数高级人工智能来说却很有挑战性:人类回答者的正确率达到92%。

除了GAIA,OpenAI、Meta等也在内部制定更细粒度的Agent评估指标,如工具调用的准确率、无用动作比例、错误恢复能力等等。

然而,评估仍然存在挑战:

-

标准的缺失——不同任务何谓“成功”有时并不客观明确; -

自动化的难度——有些复杂任务需要人工判断结果质量; -

对比的公平性——不同Agent可能擅长领域不同,简单汇总分数未必公允。

未来,我们可能需要多维评估,比如用雷达图形式描述Agent在知识、推理、工具、速度、安全等维度的表现,以全面刻画其实力。

那么我们如何构建自己应用的评估体系呢? 这就需要需求方(PM、PDSA)与客户定好需求范围、支持力度等。 我们不妨先看看 GAIA 是怎么定义评估标准的

GAIA评测内容

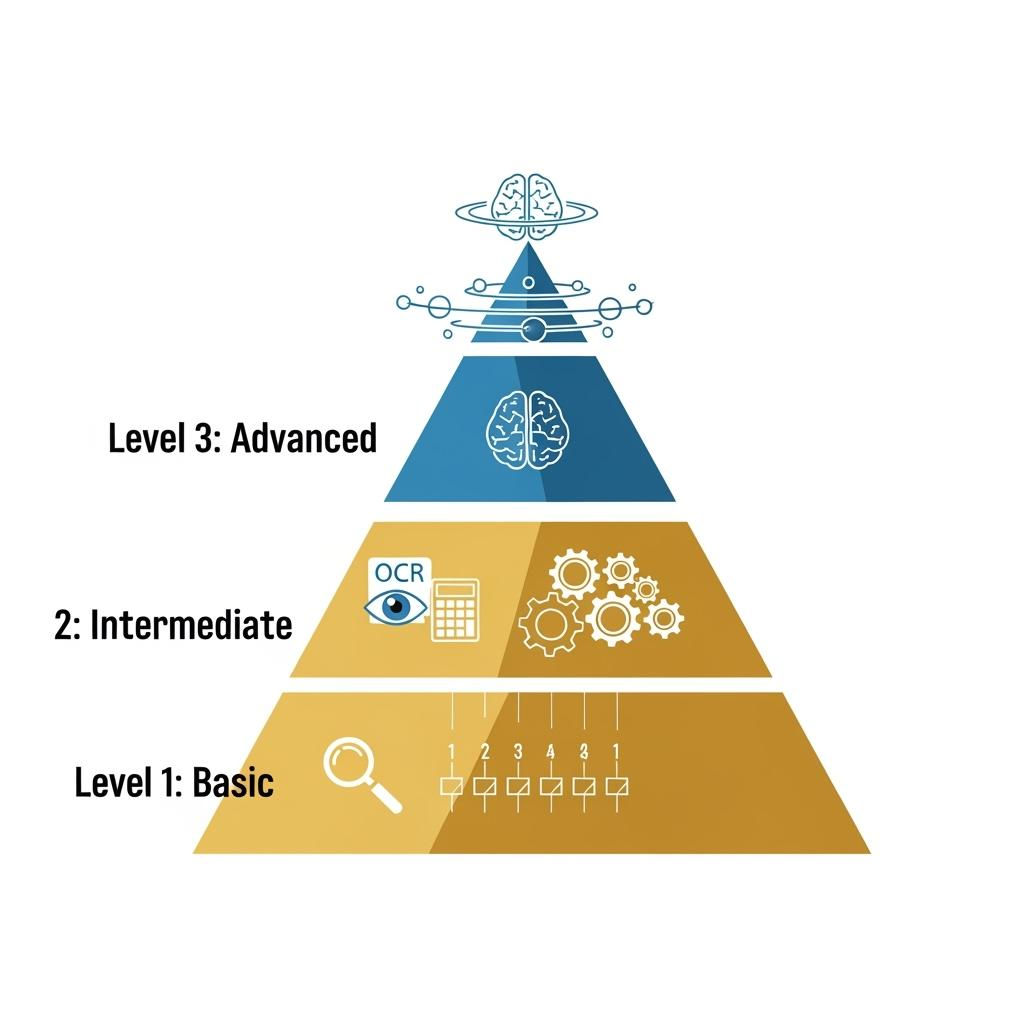

GAIA的评测分为三个维度,从一级到三级难度递增,可全方位评测一个AI agent的能力

-

Level 1. 难度约为:5 steps within + 1 tool,如图所示仅要求agent在指定网站进行查询即可

-

Level 2. 难度约为:5-10 steps within + multiple tools 如图所示,

-

通过多模态ocr提取图片数据 -

wikipedia查询标准 -

calculator计算

-

Level 3. 难度约为:任意长度steps within + 所有tools = AGI 如图所示

-

browser找到pic -

图像识别宇航员 -

推理,谁更大/更小 -

在NASA找到宇航员 -

计算时间等等

GAIA的启示:分级评测框架

GAIA的核心价值在于其“分级评测”的理念,这正是业务方构建自身评估体系时需要借鉴的关键。 GAIA通过三个难度递增的等级全方位评测Agent能力:

- Level 1 (基础):

约5步内 + 1个工具。例如:在指定网站查询特定信息。 - Level 2 (进阶):

约5-10步内 + 多个工具。例如:OCR提取图片数据 -> Wikipedia查询标准 -> 计算器计算。 - Level 3 (复杂):

任意步长 + 所有工具 ≈ AGI。例如:浏览器找图 -> 图像识别宇航员 -> 推理比较 -> NASA查资料 -> 时间计算等。

GAIA的核心启示在于:

- 能力要求分级递进:

覆盖浏览器、编码、多模态、OCR等核心能力,L1-L3在工具多样性和步骤复杂性上逐级提升。 - 模拟现实难度阶梯:

为不同复杂度的任务设定了清晰的难度标尺。

构建业务自身的评估体系:聚焦定制化与交付约定

那么,如何构建符合自身业务需求的评估体系?关键在于:业务方(PM/PDSA)需与客户紧密协作,深入理解其核心诉求与任务实现的预期难度。以此为基础,模拟GAIA的分级思想,量身定制多等级测试集。

例如:

-

根据客户业务场景的关键任务,定义不同难度级别(如:基础信息查询 L1 -> 多步骤流程处理 L2 -> 复杂问题解决与决策 L3)。 -

为每个级别设计代表性的测试用例,明确输入、期望输出及评判标准。 -

这些测试集应真实反映客户期望Agent处理的任务范围和难度层次。

与此同时,交付方的核心责任在于:与客户明确约定,针对上述定义好的、固定的多等级测试集,达成预设的、可量化的整体准确率目标。 这确保了评估的客观性、可衡量性,并聚焦于满足双方约定的核心交付成果。

结论:路径明确,聚焦执行

评估AI Agent虽具挑战,但路已逐渐清晰。业务成功落地的核心在于:摒弃追求通用基准的高分,转而深度理解客户需求,构建反映自身业务场景难度的多级测试集(仿GAIA思路)。同时,清晰界定交付目标——即在双方共同约定的、固定的测试数据集上,实现可验证的整体准确率承诺。 这种务实、定制化的评估方法,才是驱动效果迭代和保障项目成功交付的坚实基石。