大家好!回想起我在2017年创办全球机器学习技术大会(ML-Summit),在各位的支持下一起陪着AI一路走了八个年头,非常感慨。八年来,整个人工智能领域也发生了波澜壮阔的变化。接下来我想和大家分享一下我对大模型最新发展的一些研究和思考。

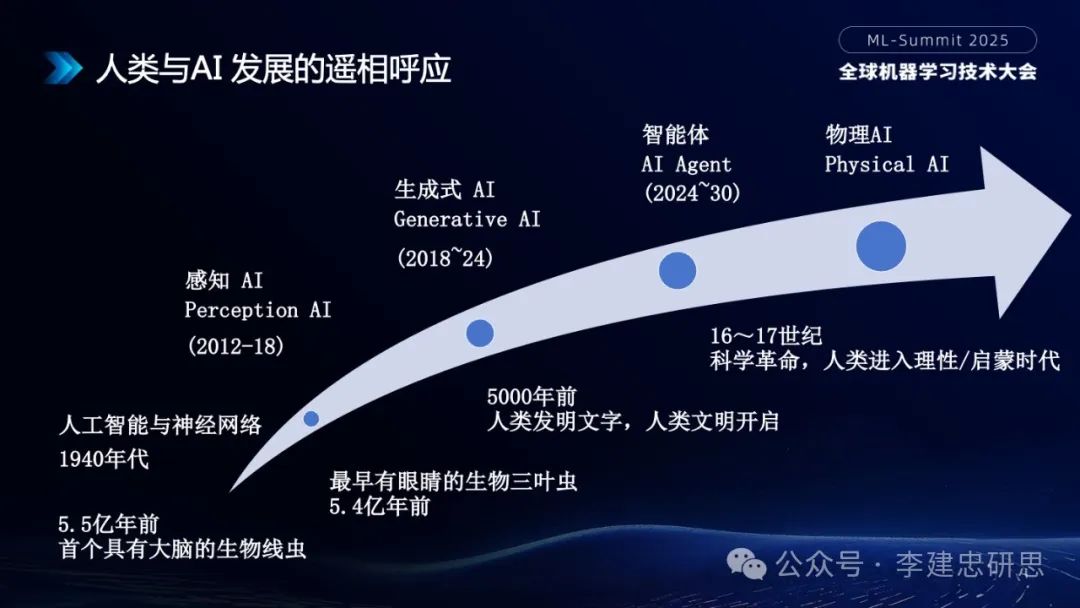

我把AI的发展阶段和地球上从生物智能到人类智能的发展阶段做了一个对比,发现一些非常有意思的规律。大家首先来看AI发展的四个阶段。第一阶段:1940年代开启人工智能的元年,整个人工智能从1940年代图灵提出计算机理论模型和神经网络的初始构想,到1956年达特茅斯会议首次提出人工智能,此后人工智能进入符号主义、行为主义、连接主义的曲折发展;第二阶段:2012~2018年间的感知AI(Perception AI),这里的标志事件是AlexNet利用深度神经网络在ImageNet大赛上拔得头筹,开启了AI在视觉领域的革命;第三阶段:2018~2024年间的生成式AI(Generative AI),这里的标志事件是基于Transformer架构的GPT 1.0模型在2018年发布和2022年底ChatGPT的出现,语言模型在这个阶段取得了突破性进展;第四阶段:2024年~2030年的AI智能体(AI Agent),这里的核心是强化学习带来的推理范式转换,给智能体注入关键驱动力;第五阶段:普遍预计是物理AI(Physical AI),具身智能的发展出现端倪,它将把AI从数字/比特世界带入物理/原子世界。

在AI发展曲线的下面,我又勾勒了生物和人类智能的发展阶段。第一阶段:生物智能的元年,大约5.5亿年前,首个具有大脑的生物线虫诞生。第二阶段:动物视觉时代,大约5.4亿年前,首个具有眼睛的生物三叶虫出现。第三阶段:人类文明出现,大约5000年前,人类发明文字,包括咱们中国的仰韶文化、龙山文化等,被认为汉字的起源,人类智能开始腾飞,人类文明开启。其实文明这个词起的很好,“文是文字、明是智慧”,文明的含义就是“有文字才有智慧”。第四阶段:现代科学革命,16-17世纪,从哥白尼日心说,牛顿经典力学,到康德等的逻辑哲学,引领人类进入理性时代、启蒙时代。

对比来看,AI的发展和生物智能的发展都经历了“大脑的诞生”,“视觉智能”,“语言智能”,“推理智能”这样一个里程碑的过程。而且发展的速率都是前期很缓慢,后期指数级加速。不谋而合,非常有启发意义。

其中在人工智能和生物智能的发展过程中,都有一个关键的要素:自然语言。这也是我一直以来强调的一个观点:“自然语言在智能中处于中心地位”。

从生物演化的历史来看,动物界已经存在视觉5亿多年,但这样的智能是感知层次的,比较低阶的智能。直到人类出现了语言,整个智能的程度得到大大的提升。AI领域也非常类似,我们知道视觉智能曾经一直处于主导地位,直到2017年开始OpenAI独辟蹊径押注自然语言的路线,终于在2022年通过大语言模型推出ChatGPT,大大提升了机器的智能水平。无论是生物演化的历史,还是AI的发展历史,我们都看到了“语言”在智能中的关键作用。

我承认我的这个判断并不是全行业的共识,典型的有两个学派是反对的。一个是统计学派;一个是视觉学派,以图灵奖得主Yann Lecun为代表。统计学派认为大语言模型只是概率输出,没有严肃的思维过程。而视觉学派认为自然语言无法理解物理世界的智能。

但最近Anthropic公司有一个研究,《追踪大语言模型的思维Tracing the thoughts of a large language model》,https://www.anthropic.com/research/tracing-thoughts-language-model,通过类似对人类大脑做核磁扫描的方式来研究大语言模型的内部计算结构,有一些非常重要的发现。我把其中几个关键点列在这里。

首先:统计学派一直认为大语言模型的“predict next token”表明大模型没有思维过程,就是一种概率模型。而Claude的研究表明,大语言模型内部在“predict next token”之前,对整个句子或者段落是有规划的,在完成规划之后,才进行token的输出。一个一个输出token只是最终的表现形式,就像人类说话也是吐出一个一个词,但并不能因此就说它是概率模型,人类在说话前显然经过了思维过程。Claude的研究是对统计学派认为大模型是简单概率模型的一个强有力的反驳。

其次:Claude研究也发现了大模型跨语言泛化能力的明确证据,也就是在一个语言里面学习到的知识,可以在另外一个语言里面去运用。这其实也是对大模型是概率模型的一个反驳。

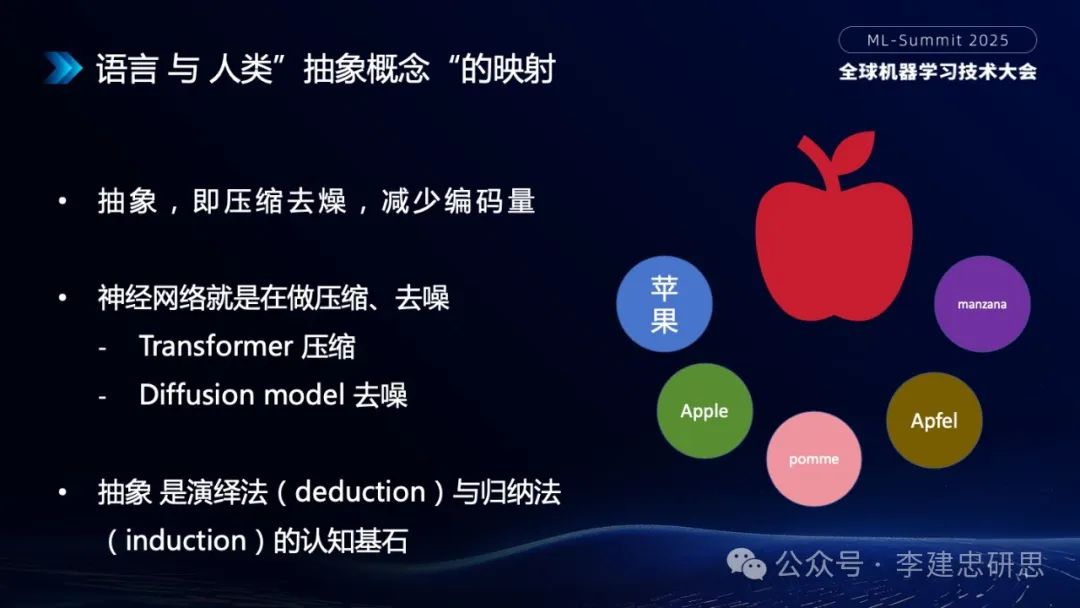

再次:Claude更进一步研究发现,大模型在内部,不同的语言如果表示的同一事物,它们会共享同一个“概念区域”。类似下面这幅图:

“苹果”在不同语言里面有不同的名称表示。但Claude发现,它在扫描模型内部计算单元时,不同语言中的“苹果”会触及同一个概念区域。也就是在模型内部,有一个“苹果的抽象概念”。当模型使用不同语言在思考“苹果”时,都会首先使用这个“苹果的抽象概念”,然后在最后输出时再将其映射为具体的语言。

我们来看人类思维中的“抽象”,它是人类思维核心方法论“演绎法(deduction)”和“归纳法(induction)”的“基石”,其本质上是“压缩”和“去噪”。而神经网络的本质也是“压缩”和“去燥”,比如说Transformer典型是个压缩模型,Diffusion Model典型是一个去噪模型。

这个发现非常厉害,我们知道LLM没有训练任何“思维中的概念”,但仅仅通过训练自然语言语料,LLM就建立了“思维中的抽象概念体系”。我个人认为这是对以Yann Lecun为代表的视觉派关于“语言模型达不到人类智能”的强有力的反击。这也印证了著名哲学家维特根斯坦关于“语言是思想的图画”等一系列关于语言与人类思维的论断。维特根斯坦1940年代在剑桥大学和图灵有过关于计算机、语言、人工智能的很多深刻的讨论。我认为维特根斯坦是人工智能领域的思想先驱,非常值得我们研究。

我记得2023年4月份我在硅谷,见了当时OpenAI的首席科学家Ilya Sutskever,当时有人问他为什么大家都选择视觉路线来寻求AGI时,OpenAI为什么独独选择自然语言路线来寻求AGI,我记得Ilya说他相信“语言是对人类智能的压缩”。这和维特根斯坦的哲学判断如出一辙。

最后,再说一下有一些论断认为“大模型只是对训练语料的简单记忆”,不具备推理能力。Claude的研究也发现,在模型内部推理和记忆是两件事情。它回答问题时,不是在简单地背诵训练过的知识,而是经历了各种推理过程。其实维特根斯坦在他的哲学研究中也谈过“语言蕴含人类丰富的推理”。Claude这个研究包含两篇论文,我觉得是对我们认识大语言模型和AGI的非常本源性的东西,如果再结合维特根斯坦的哲学论述,对大模型的研究有非常重要的启发。

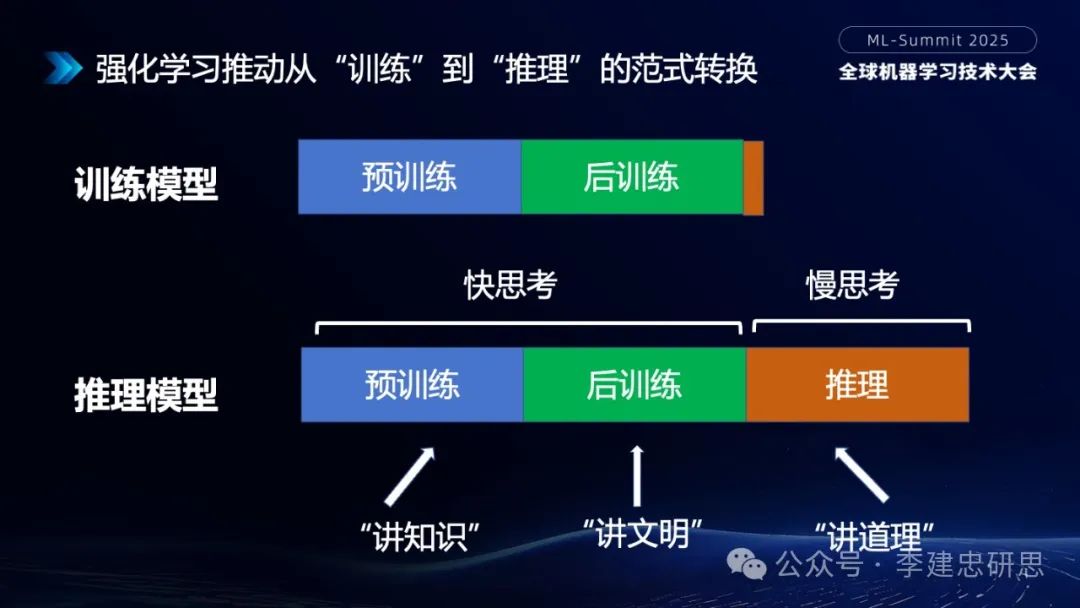

接下来谈谈,从大模型从“训练”到“推理”的范式转换。我们知道,在去年9月份OpenAI O1出来之前,业界主流的还是预训练模型。O1出来之后,因为是闭源模型,业界各种揣测和研究,都没有完成对O1的复现。直到今年1月份DeepSeek R1通过开源强化学习,将“推理模型”变成业界主流范式。我觉得这是DeepSeek最大的贡献。

我们知道大语言模型当前有三个阶段:预训练、后训练、推理。简单的概括,预训练是所谓的“讲知识”,后训练是所谓的“讲文明”,跟人类的价值观对齐。而推理就是“讲道理”,需要逻辑思维支持。预训练和后训练构成了我们所谓的“快思考”,推理构成了“慢思考”。这映射了诺贝尔经济学奖得主丹尼尔·卡尼曼在《思考,快与慢》里对人类大脑System 1和System 2的划分。System 1擅长快思考,System 2擅长慢思考。

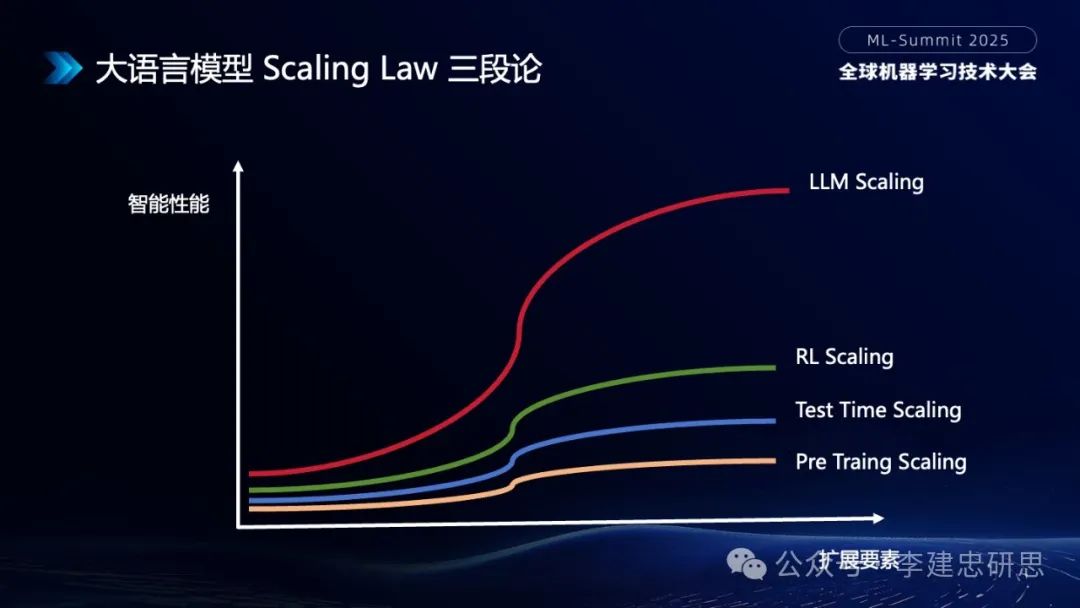

接下来聊聊大模型领域著名的Scaling Law。去年上半年一度有一种言论说,Scaling Law“撞墙了”。其实大家很快发现不是Scaling law停止了,而是互联网公域上可被训练的语料差不多快耗光了。在AI领域,当我们发现一个技术范式快接近顶点时,下一波新的范式变革往往就孕育出来了。

语料问题影响的是预训练的Scaling Law,但是当OpenAI O1和DeepSeek R1的强化学习方案出来后,因为不依赖人类现存数据,它可以用机器合成数据,这个几乎是无限的,这又推动了新的Scaling Law的增长:分别是强化学习(RL)和测试时的Scaling。虽然预训练的Scaling在放缓,但是另外两个Scaling在增长,三者叠加使得大模型的Scaling Law仍然有效。

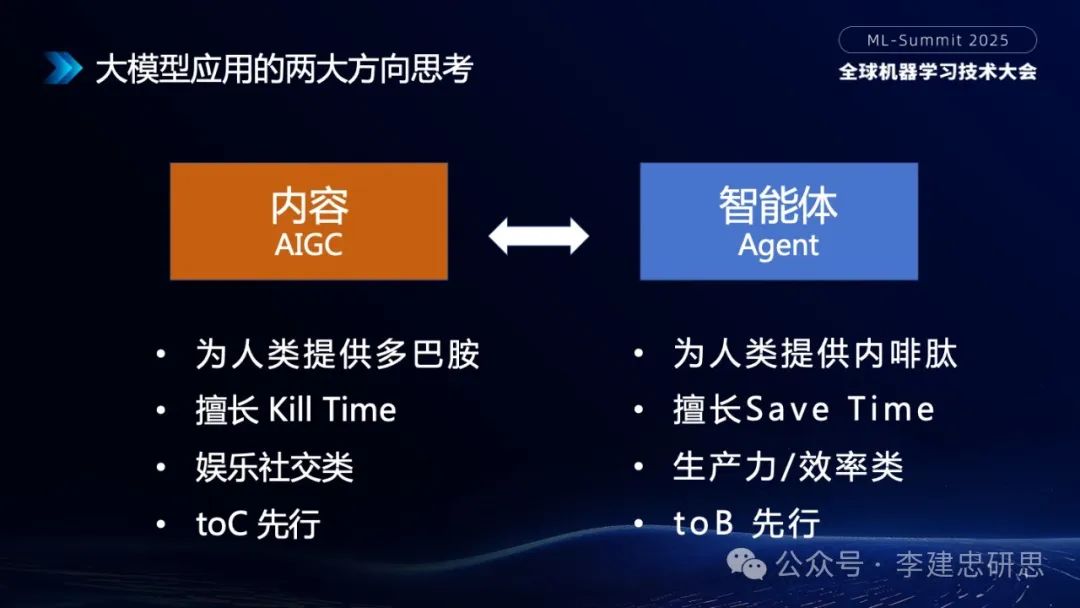

接下来,我们来谈谈大模型在AI应用生态方面的演进。首先,从最开始讲的,大模型的两大阶段:生成式AI 和AI智能体,注意这两个并非取代关系,而是并列演进的关系。

生成式AI带来的是越来越多的内容由AI生成,所谓AIGC。我们知道,从互联网和移动互联网的经验来看,人类对内容的依赖度是非常高的。头部的互联网巨头,几乎都是内容为王。包括抖音、微信等。很多人觉得微信是个社交工具,其实作为单纯的社交工具,价值是比较低的。这个可以对标美国的WhatsApp,WhatsApp价值比微信低很多。WhatsApp十亿美金量级,但微信的价值显然超越千亿美金,为什么呢?因为微信不是简单的社交工具,它的核心是在社交工具上构建了大量的内容。包括它的朋友圈、公众号、视频号等等,如果剥离这些内容,它的价值要缩减100倍。

AIGC将为内容注入新的变量。它的核心逻辑是帮助人类Kill Time,所谓消磨时光,它的核心场景是娱乐社交,用户比较侧重toC,它的底层价值是为人类提供分泌多巴胺的“情绪价值”。

而AI智能体,核心逻辑是帮助人类Save Time,所谓“帮我搞定这个事”。它的核心场景是生产力或者效率应用。用户比较侧重toB,它的底层价值是为人类提供分泌内啡肽的“成就价值”。

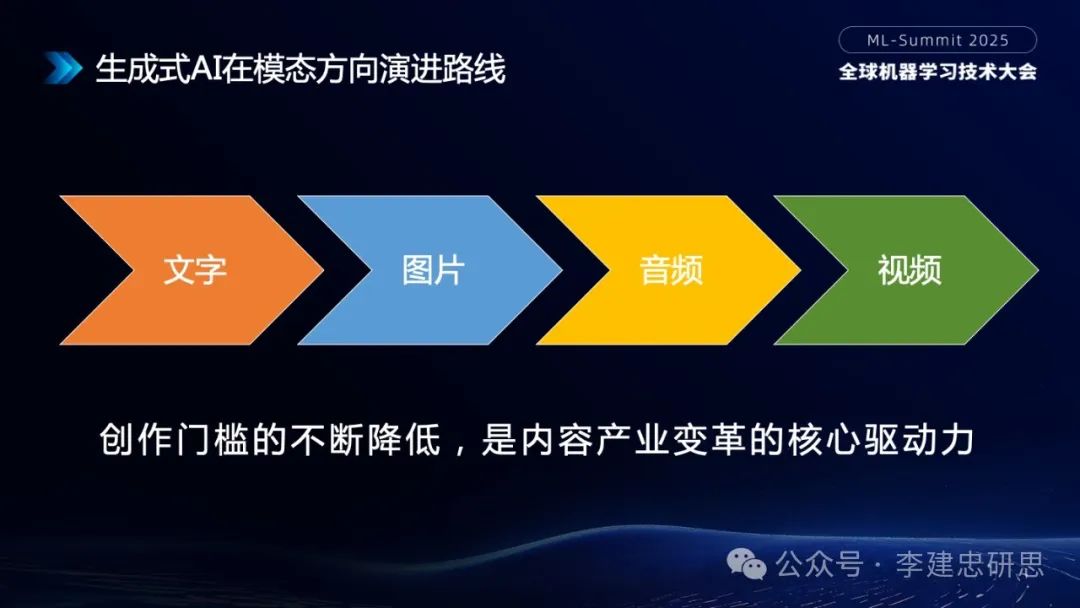

内容方面,我们还要注意“模态”方向的演进路线。从PC互联网到移动互联网,几乎每一个时代,内容都是沿着“文字-> 图片-> 音频->视频”这样个模态进行演进。

拿移动互联网来说,国内的微博、国际的Twitter都是文字模态为主、后来微信朋友圈、Instagram以图片为主,再后来喜马拉雅、Spotify以音频为主,抖音、Tiktok以视频为主。技术成熟度决定产品timing,如果在2010年做抖音,肯定没戏。同样,在AI领域,我认为仍然会遵循“文字-> 图片-> 音频->视频”这样的演进路线。

而且,AI使得内容的创作门槛不断降低,这也是内容产业变革的核心驱动力。在博客时代读者/作者比大概100:1,短视频时代消费者/创作者比大概8:3。AI时代这个比例会更低。

我们再来谈谈智能体。业界对智能体的核心能力有一个大体的共识:规划、工具、协作、记忆、行动。这五大能力的成熟度是不同的。

Agent的规划的核心支撑是推理(reasoning),正是由于我们前面讲的强化学习带来的整个推理范式使得智能体的规划能力大大提升。这也是为什么普遍认为今年智能体会爆发的原因。

再来谈谈Agent的工具(Tools)能力。早期有一种说法说,大模型来了,所有传统软件都要被大模型重构。这并不意味着所有传统软件都会变成大模型软件。传统软件仍然有它存在的价值。

去年年初机器学习技术大会上,我曾谈到传统软件执行的是图灵-冯诺伊曼架构下的结构化计算(确定性计算),而大模型软件执行的机器学习架构下的神经网络计算(概率性计算)。这两种计算适用的是不同的计算任务。并不是所有任务都适合使用神经网络计算,很多任务其实更适合传统的结构化计算。类比下人类,假如遇到数学任务,人类正常情况下会用计算器(虽然有时候不复杂的数学任务人脑也能算)。同样,遇到这种情况,大模型(神经网络计算)应该将传统软件(结构化计算)作为Tools(工具)去调用。

人类的伟大之处就在于使用工具。要想发挥大模型的能力,也要让大模型掌握使用工具的能力。使用工具有几个环节:你要知道有什么工具?怎么使用工具?调用这个工具预期有什么结果?这些就是最近比较火的MCP(Model Context Protocal)协议发挥的作用。MCP的本质就是大模型神经网络计算和传统软件结构化计算之间的桥梁。

Agent的协作能力也很重要。单一智能体的能力总是有限的。23年ChatGPT刚出来的时候,业界一直弥漫着一种情绪,未来大模型是否可以搞定所有复杂任务。其实很快我们就发现,大模型再聪明也不是万能的。就拿人类来说,最聪明的爱因斯坦也不是万能的,一个爱因斯坦干不了很多事情。大部分任务都需要多人协作。智能体与智能体之间也需要协作。这个就是Google最近推出的A2A(Agent to Agent)协议要做的事情。

MCP和A2A有些类似,但是它们根本上解决的是不同的事情。下面我们来从几个维度对比一下它们。

从协议的目标来讲,MCP解决大模型调用传统软件、API、Web服务等。所谓神经网络计算调用结构化计算,它是一个机器间的协作。而A2A解决Agent调用Agent,所谓神经网络计算调用神经网络计算,它是一个拟人化的协作。

沟通的数据格式,MCP主要传递结构化数据,执行的是确定性计算。而A2A主要传递的是自然语言或者视觉数据,执行的是概率性计算。

架构风格方面,MCP倾向于是一个中心化架构。而A2A是去中心化的,分布式的协作方式。

MCP和A2A是建设Agent的基础设施协议,它们将催生出繁荣的Agent平台生态。大模型的下一站,我认为会随着Agent生态的完善,从对话助手逐渐演进成为Agent平台。内嵌Agent能力也越来越成为大模型厂商的标配。比如前不久OpenAI在ChatGPT内集成了多种Agent即是明证。

当然未来的Agent平台到底属于大模型、还是操作系统、甚至独立的第三方?还是有一定争议的。我现在的判断是它比较接近大模型。Agent平台将是所有的模型厂商接下来卷的方向。

虽然某些操作系统也有机会建设Agent平台,但前提是操作系统要和大模型进行深度整合。如果还是基于传统的图灵-冯诺伊曼架构的操作系统,我个人认为是没有机会建设Agent平台的。

未来的Agent平台,一定会广泛支持MCP和A2A协议,从而将传统软件/服务链接起来,同时也能实现多Agent的协作。

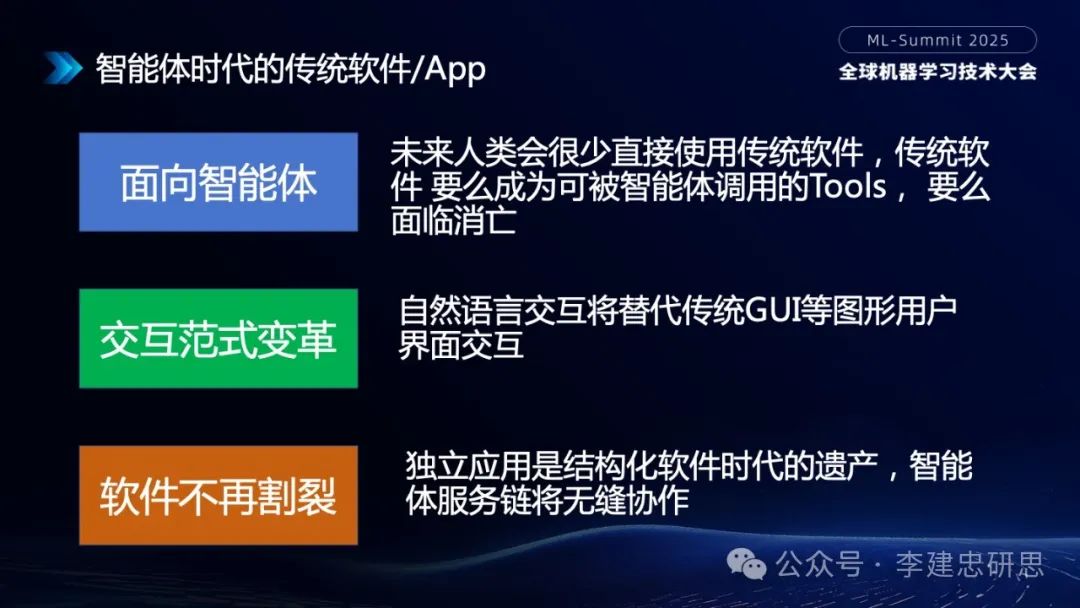

我们的传统软件/App/服务在下一个时代应该怎么办?我认为它们不会消亡,但是要重构。传统软件的重构有三个核心特点:

第一面向智能体:我觉得未来人类会很少再使用传统软件。传统软件要么变成Agent调用的下游工具,要么面临消亡。也就是传统软件如果不能跟智能体形成一个协作和对话,人类使用传统软件的比例会越来越少。

第二、交互范式的变革:显然自然语言的交互,相对于传统的GUI(图形用户界面)或者CUI(控制台用户界面)或者TUI(触控用户界面),有更强的优势。它一句话或者几句话能表达非常复杂的需求,这在传统软件里需要非常复杂的交互界面来实现。

第三、软件不再割裂:在传统软件领域,大家有没有发现,我们经常一个任务要在好几个软件之间来回切换。比如说我要去北京出差,那我经常要在地图、商旅、天气等几个应用之间来回切换。我觉得这种切换其实是传统结构化软件时代在交互方面的鸿沟造成的。

未来,在智能体时代,我们应该用一句话或者几句话快速描述我们的需求。然后大模型将我们的需求转化成为工具/服务的调用、或者多智能体的协作,一起帮我把这个事干了。至于你背后调用了什么GPS的操作系统API,天气应用Web Service,还是商旅的Agent,用户并不关心。用户只关心我的需求有没有帮我解决。这中间就不再需要那些一个个独立的App。

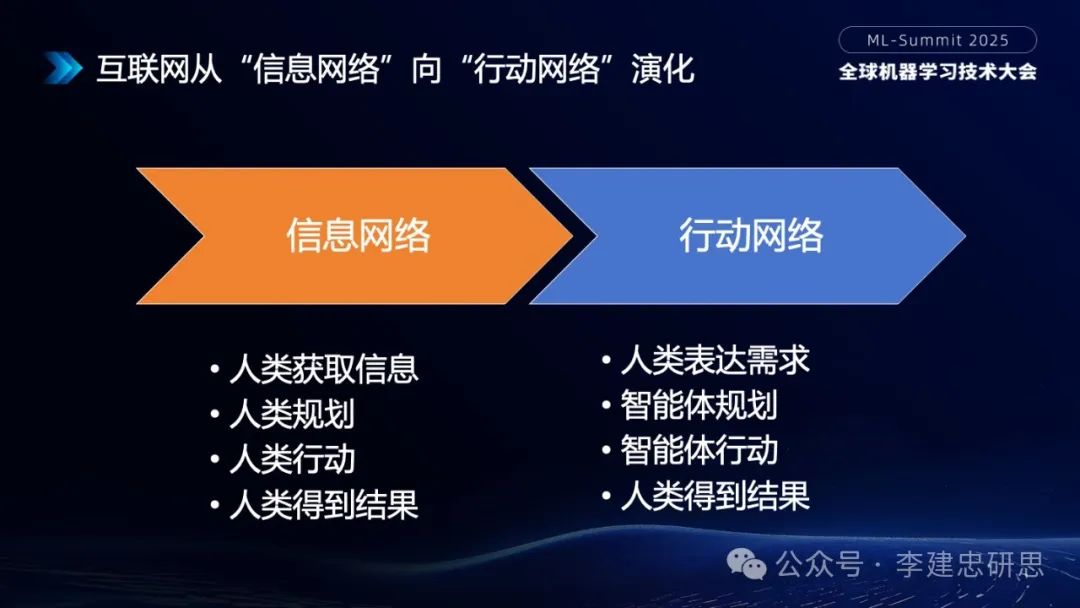

随着Agent的发展,未来的互联网会从传统的信息网络,演进为行动网络。

传统互联网作为信息网络,人类主要用于获取信息,然后人类去规划,人类来行动,人类最后得到结果。互联网本质上只是给用户提供了一个信息的检索(所谓增删改查),所有决策和行动由人类做出。而在智能体时代,它会直接帮人类完成任务。人类表达需求,智能体去规划,智能体去行动,然后人类得到结果。

“行动网络”是我去年在产品经理大会上最早提出的概念,当时大家感觉还比较遥远,今年随着Manus等Agent的出现,大家就看到了“行动网络”的雏形。

最后我们再谈一下OpenAI于去年提出的AGI的五个发展阶段,前面三个阶段分别是:Chatbot聊天机器人、Reasoner推理者、Agent智能体。第四个阶段是所谓的Innovator创新者。

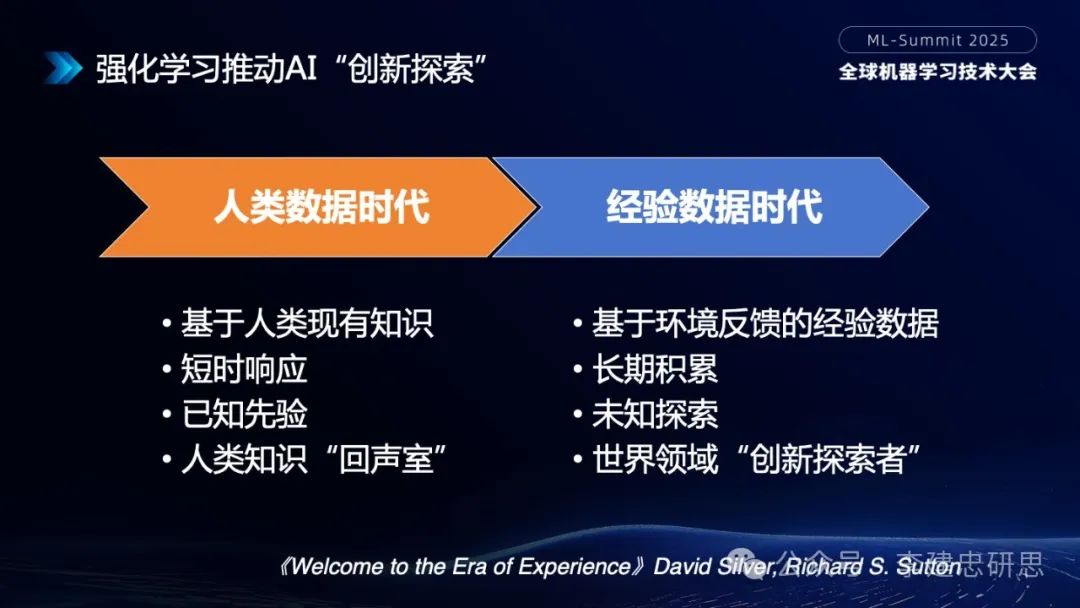

最近DeepMind的VP David Silver和强化学习之父Richard Sutton(他年初刚获得了图灵奖),共同撰写了一篇论文,《Welcome to the Era of Experience》,谈到AI将从人类数据时代到经验数据时代。

注意这个经验数据指的不是人类的经验,而是通过强化学习探索周围环境,得到的经验,然后变成长期积累学习、对环境反馈的一部分。

人类数据时代,主要基于人类现有知识,它是短时响应,有一个说法叫人类知识的“回声式”,所以它基本上超不出人类知识的上限。

而经验数据时代,将带来强化学习基于环境反馈的经验数据,它是更长周期的积累,尤其加了长期记忆能力之后,它将是一个未知的探索,它有可能突破人类现有知识的边界,引领人类对未知领域进行创新探索。这个呼应了OpenAI规划的AGI的第四阶段所谓Innovator创新者。这将有机会给人类带来生物、物理、化学、数学、太空等领域的底层突破。

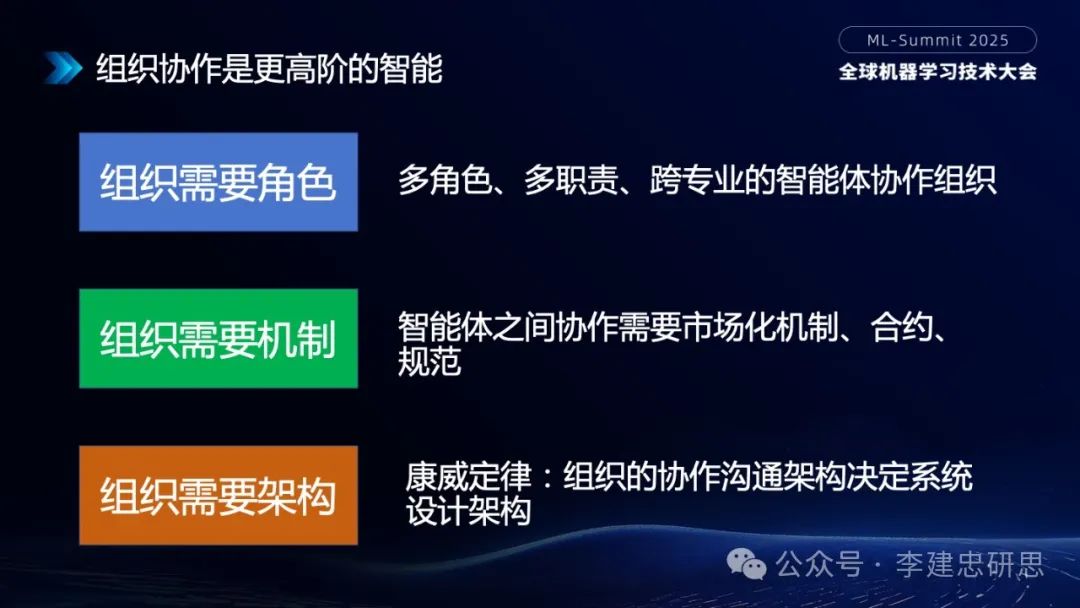

最后我们来谈下AGI的第五阶段Organization组织者。这个组织本质上就是Agent之间的协作组织。我想说组织协作实际上是更高阶的智能。

在坐的很多都是技术管理者,大家想想很多时候管理团队比写算法要复杂的多。因为组织的复杂度要远高于我们的机器。协作是人类更高阶的智慧。少则数十人,多则数万人、数亿人。人类的协作,小到公司、协会,大到国家、宗教,其实都是人类组织的协作形式。

组织首先需要角色,多角色,多职责,跨专业的协作组织。组织也需要机制。未来的智能体之间如何协作?你凭什么说一句话就让那个智能体帮你你干活呢?它需要一定的市场化机制、或者合约、或者规范。我觉得A2A(Agent to Agent)协议只是迈出了一小步,未来这个领域会出现非常复杂的协作机制。

组织也需要架构,大家知道架构领域有一个著名的康威定律:组织的协作沟通架构决定系统设计架构。这个定律也适用于Agent之间的协作架构。

以软件开发为例,目前软件开发领域实际上已经演化出来一些智能体的协作组织。

比如:需求分析,系统设计,编码开发,测试等等,这些传统由人类担当的角色正在逐步在被替换为Agent。虽然现在Agent的协作规模还比较小,大约几个到十几个的Agent在协作开发一个软件。但这种协作是未来非常有意思的探索方向。未来会不会出现像人类这种上万、甚至上亿的Agent协作组织,这样规模的智能体应该怎么协作?我觉得这是AGI时代非常大的一个命题。

我的分享就到这里。再次感谢大家参加2025年全球机器学习技术大会(ML-Summit),这两天还有50多场精彩的演讲。希望大家能有满满的收获。

【活动分享】2025 全球产品经理大会(PM-Summit)将于2025年8月15-16日在北京威斯汀酒店举办。大会共12大主题、40+海内外专家,聚焦大模型产品和应用生态变革。详情参考官网:https://pm-summit.org/ (或点击原文链接)。