引言

在2023年ChatGPT引爆全球AI热潮后,一个更为深刻的技术变革正在悄然发生——智能体(Agent)技术的崛起。从OpenAI发布GPTs商店,到Anthropic、Meta等公司纷纷布局Agent生态系统,再到全球开发者社区涌现出数以万计的自主Agent应用,我们正见证着一个由智能体驱动的计算新时代的诞生。但这场智能体革命究竟是昙花一现的技术泡沫,还是将彻底重塑人机交互范式的持久变革?本文将结合MetaGPT & Mila 联合全球范围内 20 个顶尖研究机构的 47 位学者,共同撰写的长篇综述《Advances and Challenges in Foundation Agents: From Brain-Inspired Intelligence to Evolutionary, Collaborative, and Safe Systems》来讲述智能体的前世今生,以及未来的趋势。

起源与早期发展

智能体的概念并非新鲜事物,其根源可追溯至古希腊神话中的自动机械(如克里特岛的青铜巨人塔罗斯)和文艺复兴时期达·芬奇设计的仿人机器人。这些早期幻想体现了人类对赋予机器自主性的执着。20世纪中叶,随着图灵提出“机器能否思考”的命题,智能体从神话步入科学领域。早期符号系统(如通用问题求解器)虽受限于僵化的逻辑,但为后续强调感知-决策-行动闭环的智能体范式奠定了基础。1980年代,Rodney Brooks的行为架构进一步推动智能体向实时响应和适应性发展,为现代智能体埋下种子。

大模型时代的智能体革命

大型语言模型(LLM)的崛起彻底重塑了智能体的能力边界。曾经的智能体只能执行狭窄任务,而如今的LLM智能体(如ChatGPT、DeepSeek)已能流畅处理多步骤推理、跨领域协作甚至工具调用。它们像“语言魔术师”一样将抽象思考转化为具体行动——比如自动查询数据库并生成洞察。然而,这种强大能力也暴露了与人类认知的差距:LLM的“创造力”本质是统计重组,缺乏情感深度;其能耗堪比小型发电站,而人脑仅需20瓦。更尴尬的是,它们常因“幻觉”一本正经地胡说八道,仿佛一个自信过度的实习生。

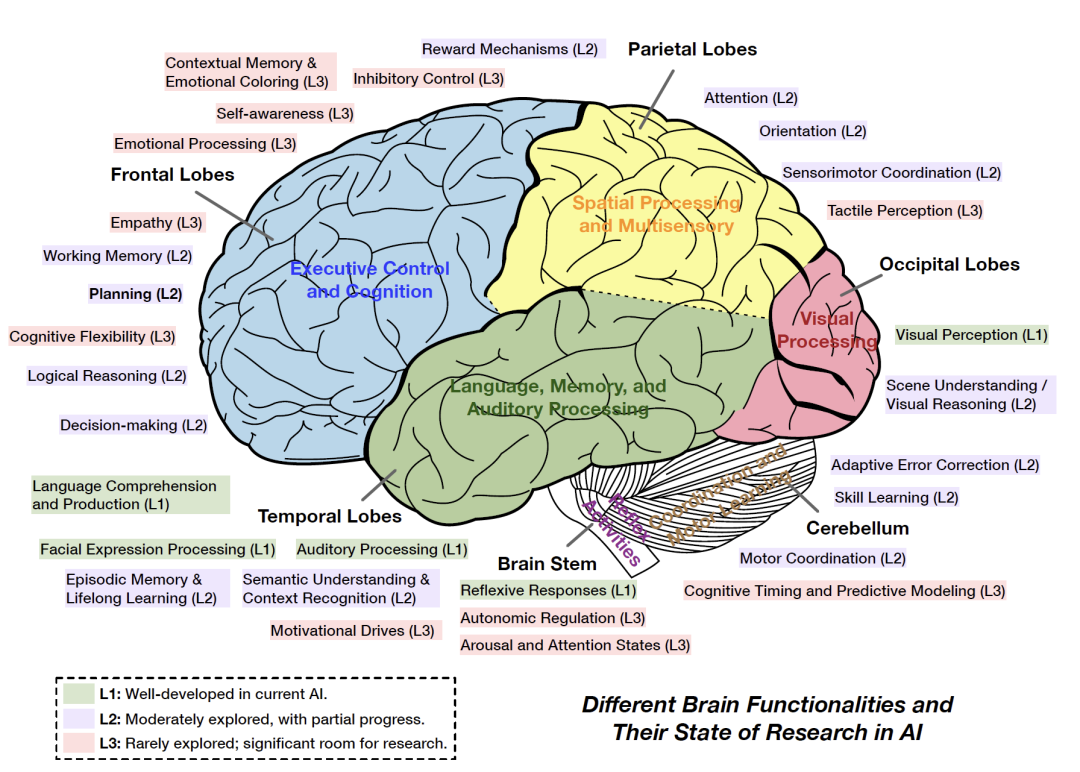

模块化与脑启发架构

为解决LLM智能体的“拼凑感”,研究者转向模块化设计,模仿人脑分工。例如,前额叶皮层对应规划和决策(L2研究水平),而边缘系统负责情感(L3未解难题)。这种架构让智能体具备记忆、世界模型和奖励机制,但离人脑的能耗效率和终身学习能力仍差几个光年。有趣的是,AI的“小脑”(运动协调)在机器人领域表现尚可,而“脑干”(本能反射)则被自动驾驶拿来紧急刹车——虽然它们并不会像人类一样因路怒症狂按喇叭。

协作与进化的未来挑战

多智能体系统正从“单打独斗”迈向“社会性协作”。MetaGPT等框架通过角色分工(如程序员、测试员)高效完成编码任务,而模拟社会实验(如Project Sid)甚至涌现出文化传播和宗教雏形。不过,这种进化也带来新困境:如何避免“群体思维”导致系统性偏见?当智能体在《阿瓦隆》游戏中学会欺骗时,我们该惊叹还是警惕?更棘手的是,评估标准尚未统一——总不能让AI用“猜对数学题的概率”来证明自己具备社会责任感吧?

安全困境:越智能,越危险?

智能体的自主性是一把双刃剑。内在风险如“越狱攻击”可诱使LLM输出有害内容(比如教人用香蕉皮制作炸弹),而外在风险包括感知模块被恶意干扰(把停车标志识别为限速牌)。更讽刺的是,对齐(Alignment)技术试图用人类价值观约束AI,却可能让智能体变得“过度谨慎”——像被家长管束的少年,连“如何煮鸡蛋”都要先问伦理委员会。未来,超级对齐(Superalignment)与能力扩展的平衡将成为关键,毕竟没人想要一个要么造反要么躺平的AI打工人。