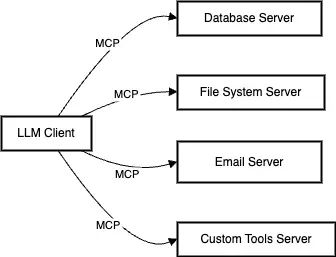

模型上下文协议(MCP)——可以将其视为给你的AI助理配备一个完整的办公环境,而不仅仅是一个邮箱。就像标准化集装箱的发明通过创造一种通用的货物运输方式彻底改变了全球贸易一样,MCP正在为AI模型与周围世界互动创造一种标准化的方式。它不仅仅是一个API或函数调用系统,而是一个全面的协议,重新定义了AI模型如何与数据、工具和系统进行互动.

但这为什么重要呢?想象一下:你是一名开发者,正在尝试构建一个用于监控公司服务器的AI驱动系统。没有MCP,你需要:

-

手动提取日志数据

-

清洗和格式化数据

-

将数据发送给大型语言模型(LLM)

-

解析响应

-

搞清楚如何采取行动

-

对每种不同类型的数据显示或行动重复上述过程

这就像试图建造一座房子,每个承包商都说不同的语言,使用不同的测量系统。MCP通过创建一种通用的“语言”来改变这种局面——一种标准化的方式,让AI模型能够访问数据、执行操作并保持上下文,同时确保安全和隐私.

MCP的真正魔力在于其能够创建我们可能称之为“AI就绪”的系统。与其为每个AI模型和每个工具构建一次性集成,MCP提供了一种在不同AI模型和不同系统之间通用的协议。这类似于HTTP协议如何促成现代网络的创建——你不需要知道每个网站是如何构建的,就能通过浏览器访问它.

考虑这个现实世界的场景:一家医院需要使用AI来分析病人的病历以提供治疗建议,但不能将敏感的病人数据发送到外部AI模型。有了MCP,他们可以创建安全的接口,允许AI模型查询相关的医疗信息并建议治疗方案,而无需暴露原始的病人数据。AI获得了它需要的上下文,而医院则完全控制着他们的敏感数据.

随着我们深入MCP的世界,你会发现这个优雅的协议是如何解决AI集成中最大的挑战之一的:弥合AI潜力与其在现实世界中实际应用之间的差距。无论你是开发者、系统架构师,还是对AI集成的未来感兴趣,理解MCP就像是窥见了AI如何真正成为我们系统和工作流程的一部分.

让我们逐步探索MCP是如何通过每一个标准化的连接实现这一点的.

理解 MCP: 基础

想象一下走进一个井井有条的办公室。你有你的文件柜(资源)、工具箱(工具)、模板文件夹(提示)和办公室对讲系统(传输层)。MCP遵循类似的组织结构,但用于AI互动。让我们来分解这些基本组成部分:

核心组件

1. 资源: AI 的文件柜

MCP中的资源就像一个AI可以访问的智能文件系统。但与普通的文件柜不同,这个文件柜有一些特殊功能:

选择性访问

可以将其视为一个文件柜,你可以展示特定文件而不必暴露整个抽屉.例如:

# Instead of sending an entire log file:

error_context = extract_relevant_error_lines(log_file)

ai_response = analyze_error(error_context)

实时更新

与静态文件不同,MCP资源可以实时更新.想象一下监控系统指标:

# Real-time server monitoring

@resource_update

def cpu_usage():

return get_current_cpu_metrics()

2. 工具: AI 的瑞士军刀

工具是AI可以采取的行动,但有一个关键的安全保障——人类批准.这就像是给你的AI助理一套钥匙,但你仍然控制着主锁:

const emailTool = {

name: "send_customer_email",

description: "Send personalized email to customer",

// The AI can suggest email content, but humans approve before sending

requiresApproval: true

}

3. 提示词:AI 的剧本

可以将提示视为预先编写好的脚本或模板,帮助引导AI互动.就像客户服务代表的手册,但它是为AI准备的:

const customerServicePrompt = {

name: "handle_refund_request",

template: "Analyze this refund request considering:n" +

"1. Purchase history: {purchase_history}n" +

"2. Return policy: {return_policy}n" +

"3. Customer status: {customer_status}"

}

架构:如何整合在一起

想象一下一家高档餐厅的厨房.大型语言模型(如Claude)是主厨,MCP服务器就像专门的烹饪站(烤架站、沙拉站等),而传输层就像厨房的通信系统:

不只是 Function Calling: 为什么 MCP 很重要

AI 集成的演变

还记得打电话意味着要通过接线员进行物理连接吗?这与我们目前大多数AI集成的情况相似——通过函数调用手动连接不同的部分.让我们探讨一下为什么MCP代表了从这种方法的飞跃.

Function Calling: 接线员

当前与大型语言模型(LLMs)的函数调用看起来是这样的:

# Traditional function calling

def get_sales_data():

data = fetch_from_database()

return format_for_llm(data) # Have to manually format everything

def analyze_with_llm(data):

response = llm.analyze(

"Here's the sales data: " + data,

functions=[{

"name": "generate_report",

"parameters": {...}

}]

)

# Have to handle each function separately

return parse_llm_response(response)

它确实可以工作,但这就像你想要打电话给的每个人都有不同的电话号码和协议一样.每次集成都是一项定制工作.

MCP: AI 的互联协议

现在,让我们来看看MCP的方法:

# MCP server setup

class SalesAnalyticsServer(MCPServer):

@resource

def sales_data(self):

# MCP handles data formatting and streaming

return DatabaseResource("sales")

@tool

def generate_report(self, parameters):

# Standardized tool interface

return ReportGenerator.create(parameters)

# Client side becomes simply

client.connect(sales_analytics_server)

# Now any LLM can access sales data and generate reports

为什么这个很重要:一个历史的类比

电子邮件的变革

还记得电子邮件是如何改变沟通的吗?在标准化协议如SMTP出现之前:

-

CompuServe用户只能给其他CompuServe用户发送电子邮件

-

MCI Mail用户只能联系其他MCI Mail用户

-

每个系统都有自己的格式和规则

听起来熟悉吗?这就像今天的AI领域,其中:

-

GPT-4有其函数调用格式

-

Claude有其自己的工具使用方式

-

每个AI服务都有自己的集成方法

SMTP(简单邮件传输协议)通过创建一种标准方式让不同的电子邮件系统进行通信,改变了这一切。MCP也在为AI集成做同样的事情。

现实世界的影响:协议的力量

让我们来看一个具体的例子,看看MCP如何改变AI集成:

场景:客户服务自动化

没有 MCP 的做法:

# Have to build custom integrations for everything

def handle_customer_request(request):

# Manual data gathering

customer_data = crm.get_customer(request.id)

purchase_history = orders.get_history(request.id)

support_tickets = helpdesk.get_tickets(request.id)

# Manual formatting for LLM

context = format_for_llm(customer_data, purchase_history, support_tickets)

# Custom function calling

response = llm.analyze(context, functions=[...])

# Custom action handling

if response.action == "refund":

billing.process_refund(...)

elif response.action == "escalate":

tickets.escalate(...)

用 MCP 的做法:

# MCP servers handle the complexity

@mcp_server

class CustomerServiceServer:

@resource

def customer_context(self, customer_id):

# MCP handles data aggregation and formatting

return CustomerContext(customer_id)

@tool

def handle_request(self, action, parameters):

# Standardized action handling

return ActionHandler.execute(action, parameters)

# Client code becomes simple

service = CustomerServiceServer()

client.connect(service)

# LLM can now access customer data and take actions through standard protocol

协议的优势

与简单的函数调用相比,MCP提供了几个关键优势:

标准化

-

Function calling: 每个 AI 提供 -

MCP: 一个协议统领一切

可扩展性

-

Function calling: 随着函数数量的增加,复杂性呈线性增长 -

MCP: 通过标准化服务器实现模块化增长

现实世界的应用: MCP in Action

医疗决策支持

挑战

-

他们不能将敏感的病人数据发送到外部AI系统 -

他们需要对AI建议的使用保持精确控制

使用 MCP 解决方案

-

与其发送“约翰·多伊,45岁”,系统发送“男性患者,40-50岁年龄范围” -

不是发送原始测试结果,而是发送临床解释:“白细胞计数升高”而不是具体数字 -

病史变得概括化:“最近有国际旅行”而不是具体的日期和地点

-

系统收集所有相关数据(症状、测试结果、病史) -

MCP将其转换为匿名但具有临床相关性的格式 -

AI接收到一个完整的临床画面,而没有任何个人标识符

-

提出可能的诊断 -

推荐额外的测试 -

突出潜在的风险因素

Presentation: Adult patient, 30-40 age range

Current Symptoms:

- Persistent cough (5 days)

- Elevated temperature

- Reported fatigue

Relevant History:

- Controlled respiratory condition

- Recent international travel

AI接收到这些抽象的信息,并可以在实际病人数据从未离开医院系统的情况下提供意见。

该方法的强大之处

这种架构提供了几个关键好处:

数据保护

-

敏感数据从未离开医院系统

-

AI仅看到具有临床相关性的匿名信息

-

所有互动都有完整的审计跟踪

临床相关性

-

尽管进行了匿名化,但仍保持医学上下文

-

保留了重要的临床关系

-

在不侵犯隐私的情况下实现有意义的AI分析

运营控制

-

医院对数据访问保持完全控制

-

所有AI建议都需要适当的医疗批准

-

系统可以进行合规性审计

可扩展性

-

可以与不同的AI模型一起工作

-

容易添加新的分析类型

-

可以扩展以处理新的数据类型或需求

改变金融服务

另一个强大的例子是MCP如何在保持数据安全的同时彻底改变金融分析。

挑战

银行和金融机构拥有大量数据,但面临着关于如何使用和共享这些数据的严格规定.

MCP 解决方案

MCP在金融数据和AI分析之间创建了一个安全的桥梁:

在不暴露的情况下进行模式识别

-

与其发送实际的交易金额,MCP可以传输模式:“在类别X中检测到不寻常的消费模式”

-

客户档案成为匿名的细分市场:“科技行业的高价值客户”,而不是具体的细节

-

监控不寻常的模式

-

建议个性化的金融产品

-

标记潜在的合规问题,所有这些都在不暴露敏感客户数据的情况下进行

这是一个现实世界的场景

一家银行希望识别可能从投资产品中受益的客户.而不是共享客户数据,MCP创建匿名档案:

-

消费模式(在不同类别中的高/中/低)

-

财务行为(储蓄趋势、投资兴趣)

-

风险承受能力指标

然后AI可以在不查看实际账户细节的情况下提出个性化建议.

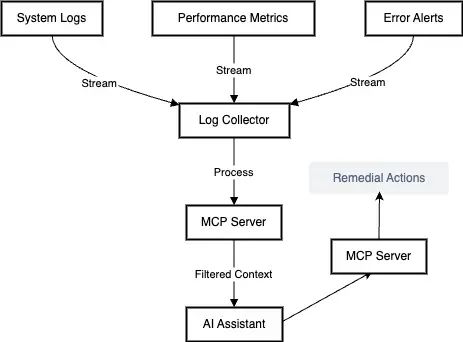

智能系统监控

让我们看看MCP服务器如何处理系统监控和对事件的自动化响应,在保持安全的同时实现快速行动.

1. 初始设置与监控

2. 实时数据处理

假设一个支付系统开始出现问题.以下是MCP服务器如何处理它的:

原始数据输入

Raw Log Entry:

[2024-03-28 15:30:43] ERROR: Payment processing failed for transaction ID:

TX_789_CUSTOMER_456

Database connection timeout at 192.168.1.100:5432

Stack trace:

at PaymentProcessor.execute (line 123)

User session: USER_789_STRIPE_TOKEN

API key used: sk_live_xxxxx

数据传输阶段 MCP server:

Transformed Context:

Incident Type: Payment Processing Error

Primary Issue: Database Connection Timeout

System Impact: Payment Processing Pipeline

Pattern: Part of multiple similar failures

Recent Changes: None in affected components

Current Load: 85% of normal capacity

-

剥离敏感信息 -

抽取相关模式 -

关联相关事件 -

构建事件上下文

3. 模式识别和上下文构建

MCP服务器维护一个滚动的上下文窗口:上下文构建器创建了一个情境快照:

系统健康上下文

-

性能指标趋势

-

错误率模式

-

资源利用率

-

不暴露内部IP地址或安全细节

事件上下文

-

相关事件时间线

-

影响评估

-

类似的过去事件

-

不透露敏感的系统架构

4. 实时响应处理

让我们看看服务器是如何处理一个关键事件的:

初始警报

{

"incident_context": {

"type": "system_degradation",

"affected_service": "payment_processing",

"impact_level": "high",

"current_metrics": {

"error_rate": "increasing",

"response_time": "degraded",

"success_rate": "declining"

},

"similar_patterns": [

{

"previous_occurrence": "7 days ago",

"resolution": "connection pool adjustment",

"recovery_time": "5 minutes"

}

]

}

}

{

"recommended_actions": [

{

"action": "increase_connection_pool",

"priority": "high",

"reasoning": "Pattern matches previous resolution",

"risk_level": "low"

},

{

"action": "enable_fallback_route",

"priority": "medium",

"reasoning": "Prevent transaction failures",

"risk_level": "medium"

}

]

}

-

1. 验证提议的行动是否符合安全策略

-

2. 检查授权级别

-

3. 对关键更改需要明确的DevOps批准

-

4. 维护所有行动的审计跟踪

隐私优先的大规模图像分析

挑战

像Claude或ChatGPT这样的AI助手可以在你直接共享图像时进行分析——但这种方法面临两个显著的限制:

-

将敏感图像发送到外部服务时的隐私问题

-

处理大量图像集合时的可扩展性问题

-

高分辨率图像的网络带宽限制

想象一下一个医学研究机构需要分析数千张X光图像,或者一个制造工厂通过照片监控产品质量——将每张图像发送到外部AI服务不仅不切实际,还可能违反隐私法规或知识产权协议.

MCP 的解决方案

MCP通过实现本地图像处理与AI咨询相结合来改变这一场景.可以将其想象为拥有一个聪明的艺术策展人,他可以在不看到实际画作的情况下讨论你的画廊的内容——他们只接收来自你本地团队精心策划的描述.

以下是其工作方式:

@mcp_server

class ImageAnalysisServer:

def __init__(self):

# Initialize local image recognition models

self.local_model = LocalImageProcessor()

self.object_detector = ObjectDetectionModel()

self.face_detector = FaceDetector(anonymize=True)

@resource

def image_contents(self, image_path):

"""

Analyzes image locally and returns sanitized descriptions

"""

# Process image locally

raw_analysis = self.local_model.analyze(image_path)

# Extract relevant features while preserving privacy

return {

'objects_detected': raw_analysis.objects,

'scene_type': raw_analysis.scene,

'dominant_colors': raw_analysis.colors,

'composition': raw_analysis.layout,

# Notably excluding any identifying information

}

@resource

def batch_analysis(self, directory):

"""

Processes multiple images and returns aggregate insights

"""

analyses = []

for image in self.list_images(directory):

analysis = self.image_contents(image)

analyses.append(analysis)

return self.aggregate_findings(analyses)隐私保护功能

-

AI接收的是结构化描述,而不是原始图像

-

描述中的人脸会自动匿名化

-

图像中的敏感文本会被删去

-

元数据(位置、设备信息、时间戳)被剥离

-

个人标识符被替换为通用代号

可扩展处理

在分析大量图像集合时:

-

本地处理是并行进行的

-

只有聚合的见解与AI共享

-

处理可以在多个服务器之间分配

-

结果被缓存以便重复查询

真实世界

让我们来看看这在制造质量控制场景中是如何工作的:

# Example interaction with the MCP server

@tool

def analyze_production_batch(self, batch_id):

"""

Analyzes a batch of product photos for quality control

"""

images = self.get_batch_images(batch_id)

analysis = []

for image in images:

# Local processing maintains data privacy

features = self.quality_check_model.analyze(image)

# Convert raw analysis to privacy-safe format

sanitized_result = {

'product_category': features.category,

'quality_indicators': {

'symmetry': features.symmetry_score,

'color_consistency': features.color_score,

'defect_probability': features.defect_score

},

# Exclude raw images and identifying details

'batch_metadata': self.sanitize_metadata(features.metadata)

}

analysis.append(sanitized_result)

return self.summarize_batch_quality(analysis)

AI 可以提供高级的见解:

{

"batch_summary": {

"inspection_coverage": "100%",

"quality_metrics": {

"pass_rate": "94.2%",

"common_issues": [

{

"type": "color_inconsistency",

"frequency": "3.1%",

"severity": "low"

}

]

},

"recommendations": [

{

"action": "adjust_color_calibration",

"priority": "medium",

"expected_impact": "2.5% quality improvement"

}

]

}

}

这种方法在保持隐私控制和实现可扩展处理的同时,为AI辅助图像分析开辟了新的可能性。无论你是分析医学图像、监控制造质量,还是处理敏感文件,MCP都为你本地的图像处理能力和AI辅助之间提供了一个安全的桥梁。

构建 AI 集成的未来

模型上下文协议不仅仅是一个技术规范——它标志着我们在AI集成思维方式上的根本转变。正如标准化集装箱通过解决看似简单的问题——在不同运输系统之间移动货物——彻底改变了全球贸易一样,MCP解决了将AI系统与现实世界以标准化、安全和可扩展的方式连接起来的复杂挑战。

我们探索的这些例子——从医疗决策支持到注重隐私的图像分析和智能客户服务——展示了MCP的多功能性和变革潜力。在每种情况下,我们都看到MCP的标准化方法如何简化复杂的集成,同时增强安全性、隐私性和可扩展性。该协议在控制对敏感数据的访问的同时保持上下文的能力,为那些传统上因隐私和安全问题而限制创新的领域开辟了新的AI应用可能性。

但也许最重要的是,MCP使AI集成民主化。通过提供AI互动的标准协议,它降低了常常使AI集成成为拥有大量技术资源的大型组织特权的技术障碍。小型医疗诊所现在可以在不侵犯病人隐私的情况下利用AI进行诊断支持。任何规模的制造运营都可以实施智能质量控制系统。客户服务团队可以在不构建复杂的定制集成的情况下提供AI增强的支持。

展望未来,随着组织越来越多地寻求在保持对数据和操作控制的同时利用AI能力,MCP的影响可能会增长。该协议的灵活性和可扩展性意味着它可以随着AI技术的进步而发展,为未来的创新提供稳定的基石。

当我们站在这一转型的起点时,MCP提醒我们,有时最强大的创新并不是最耀眼的新技术,而是使这些技术能够无缝协同工作的协议和标准。通过弥合AI潜力与其实际应用之间的差距,MCP正在帮助构建一个AI集成不仅强大,而且实用、安全、对所有人可访问的未来。

AI集成的旅程才刚刚开始,MCP为这一旅程提供了路线图——一次标准化连接。

转载请注明:Model Context Protocol (MCP): 在 AI 和你的世界中构建一座桥梁 | AI工具大全&导航