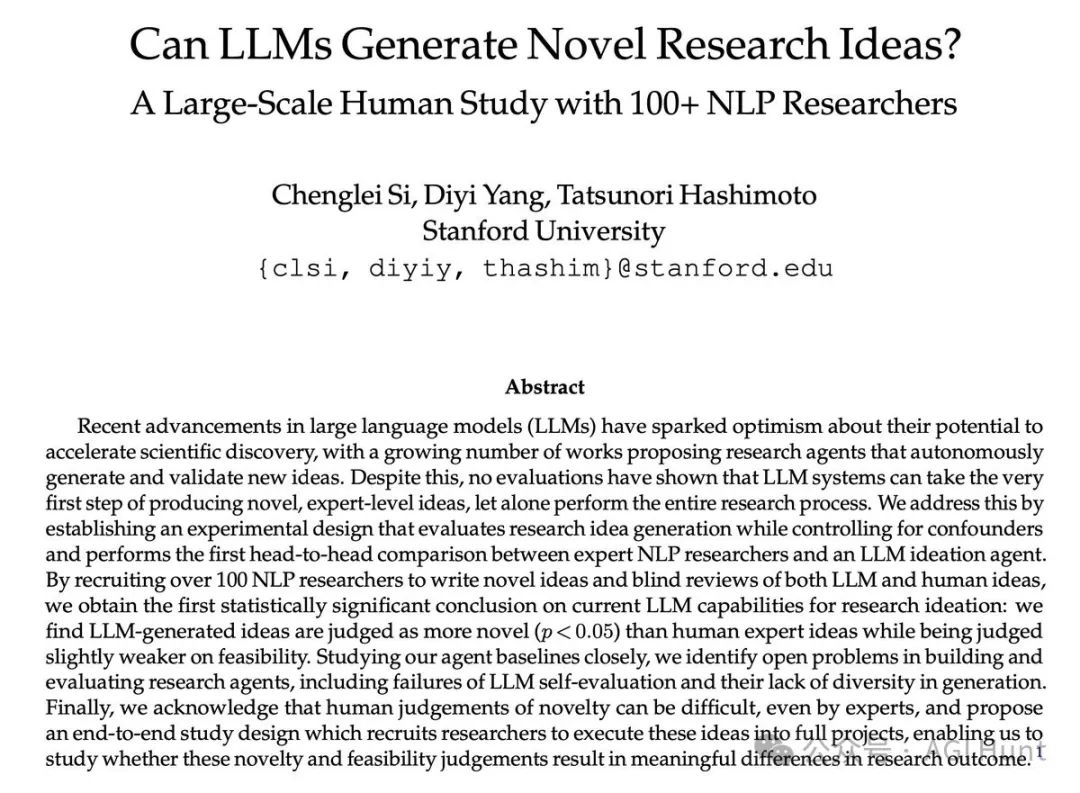

斯坦福大学的研究团队刚刚发布了一项爆炸性研究!

他们发现大语言模型(LLM)生成的研究创意比人类专家更新颖!

没想到AI不仅能写论文,现在连研究创意都能甩人类专家几条街了?

你可能会好奇这项研究到底是怎么做的?结果靠谱吗?

一起来扒一扒!

首先,研究团队可没有随便找几个人来充数。他们招募了49位NLP领域的顶尖专家,让这些大佬们在7个NLP主题上提出新颖的研究创意。

与此同时,他们还训练了一个LLM智能体,让它也在相同的7个主题上生成研究创意。

等等,别以为这就完了!

为了保证评审的公平性,研究团队又找来了79位专家,对所有的创意进行匿名评审。

这阵容,堪称是学术界的春晚啊!

说到这些"专家",可别以为是随便找的。

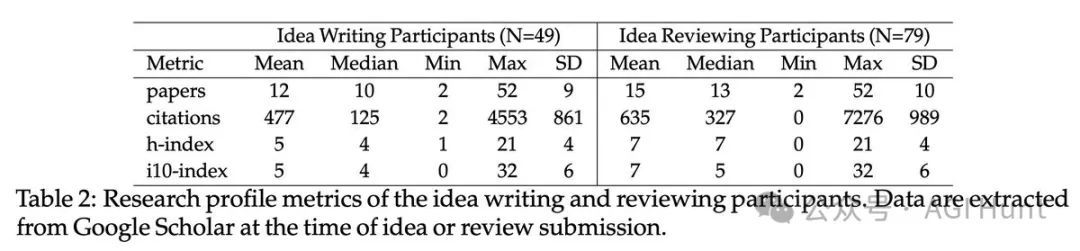

参与的研究人员来自36个不同的机构,大多数都是博士和博士后。他们的引用量中位数高达125,评审专家的引用量中位数更是达到了327!

可谓是学术界的梦之队啊!

为了确保人类和AI生成的创意都能涵盖所有必要细节,研究团队还制定了一个超级详细的创意模板。他们甚至为每个创意支付了300美元,还给出了1000美元的奖金给最佳的5个人类创意。

啧!学术界的"非诚勿扰" 啊!

为了避免写作风格影响评审结果,研究团队还用LLM对所有创意的写作风格进行了标准化处理。

下面是一个随机选择的LLM生成的创意示例,看起来是不是很专业?

79位专家评审总共提交了298份评审,每个创意都获得了2-4份独立评审。评审表格参考了ICLR和ACL的标准,包括新颖性、激动程度、可行性和预期效果等多个维度的评分和理由。

最后,研究团队对结果进行了三种不同的统计测试,考虑了所有可能的混淆因素。结果显示,LLM生成的创意在新颖性方面显著优于人类专家的创意。

这个结果,可以说是学术界的"李逵PK李鬼" 了!

除了人机对比,研究团队还发现了两个有趣的LLM特性:

-

LLM在生成创意时缺乏多样性。即使被明确告知不要重复,它们还是很快就开始重复之前生成的创意。

看来AI 还是喜欢做个 "复读机" !

-

LLM还无法可靠地评估创意。当研究团队用之前的自动LLM评审员与人类专家评审进行对比时,发现所有LLM评审员都与人类判断的一致性很低。

看来用AI 做评委还是不那么靠谱!

研究团队表示,他们在论文中还包含了更多定量和定性分析,包括人类和LLM创意的示例及相应的专家评审,专家自由文本评审的总结,以及他们对这个新兴研究方向如何取得进展的思考。

接下来,他们还计划招募更多专家参与研究的第二阶段,让专家们将AI和人类的创意实施为完整的项目,以便基于真实的研究成果进行更可靠的评估。