OpenAI又放了个大招,正式在API中推出了全新的GPT-4.1系列模型!包括GPT-4.1、GPT-4.1 mini和GPT-4.1 nano三款新成员

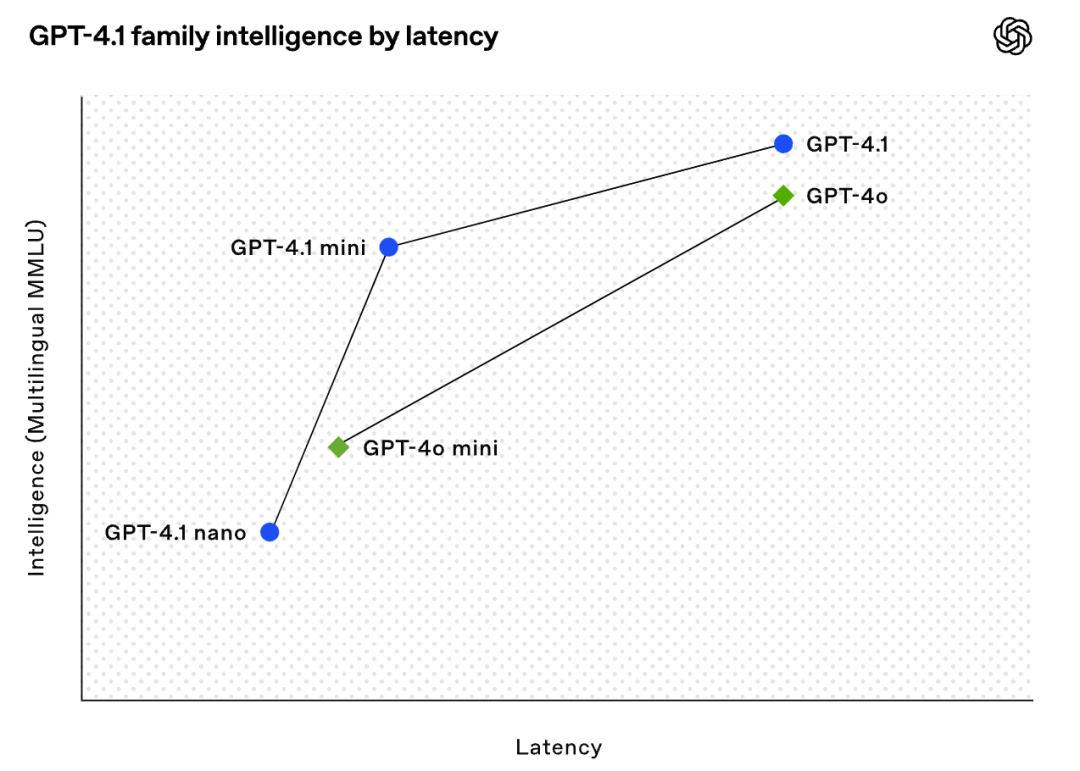

引入首个Nano模型:GPT-4.1 nano是OpenAI迄今最快、最便宜的模型,虽然小,但能力不俗(MMLU 80.1%, GPQA 50.3%),同样拥有100万Token上下文,非常适合需要低延迟的场景

目前GPT-4.1系列仅通过API提供

简单来说,这次更新的核心就是:代码能力大幅提升、指令遵循重大改进、成本极其便宜!

划重点

全面超越前辈:官方表示,新模型在各项能力上普遍优于之前的GPT-4o和GPT-4o mini,更重要的是,无论你需要多快的响应速度,这个新系列总能提供一个比以往模型在同等速度下性能更好的选项,全面提升了不同应用场景下的性能标杆,比如,需要极低延迟的,可以用 Nano,它比之前的低延迟模型性能更好;需要中等平衡的,可以用 Mini,它提供了新的更优平衡点;需要最高性能的,可以用 GPT-4.1,它在可接受延迟下性能更强

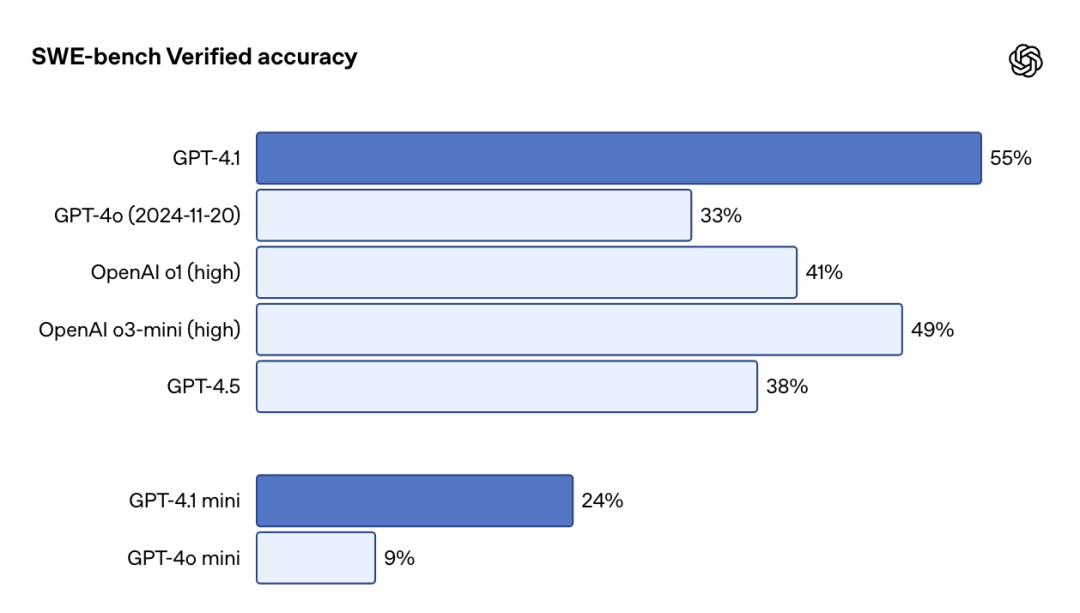

编程能力大幅跃升:在衡量真实世界软件工程任务的SWE-bench Verified基准上,GPT-4.1得分54.6%,比GPT-4o绝对提升了21.4%,甚至比GPT-4.5还高了26.6%!妥妥的编码利器

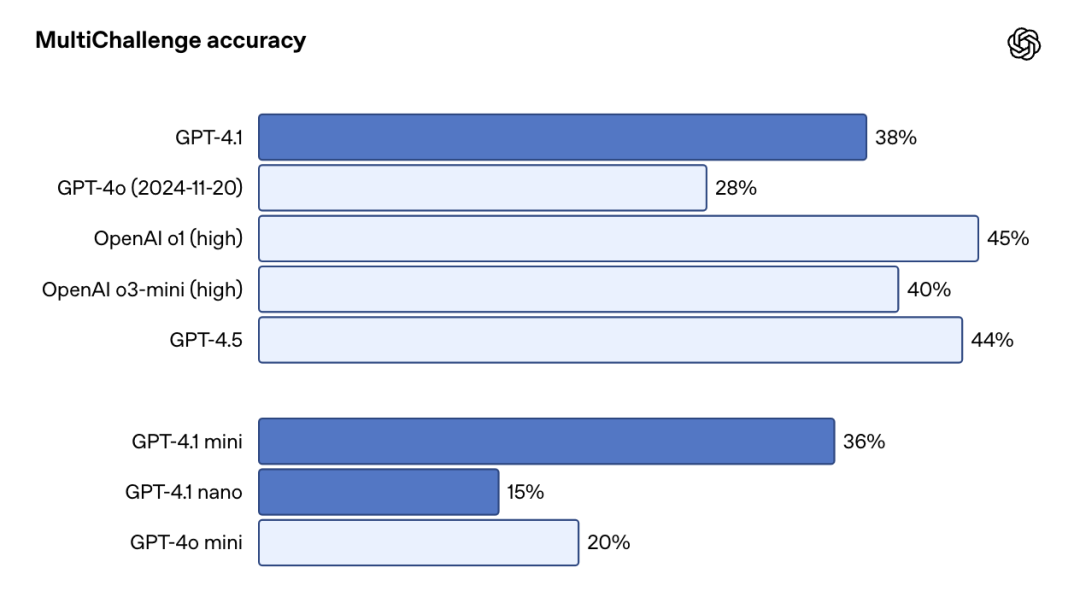

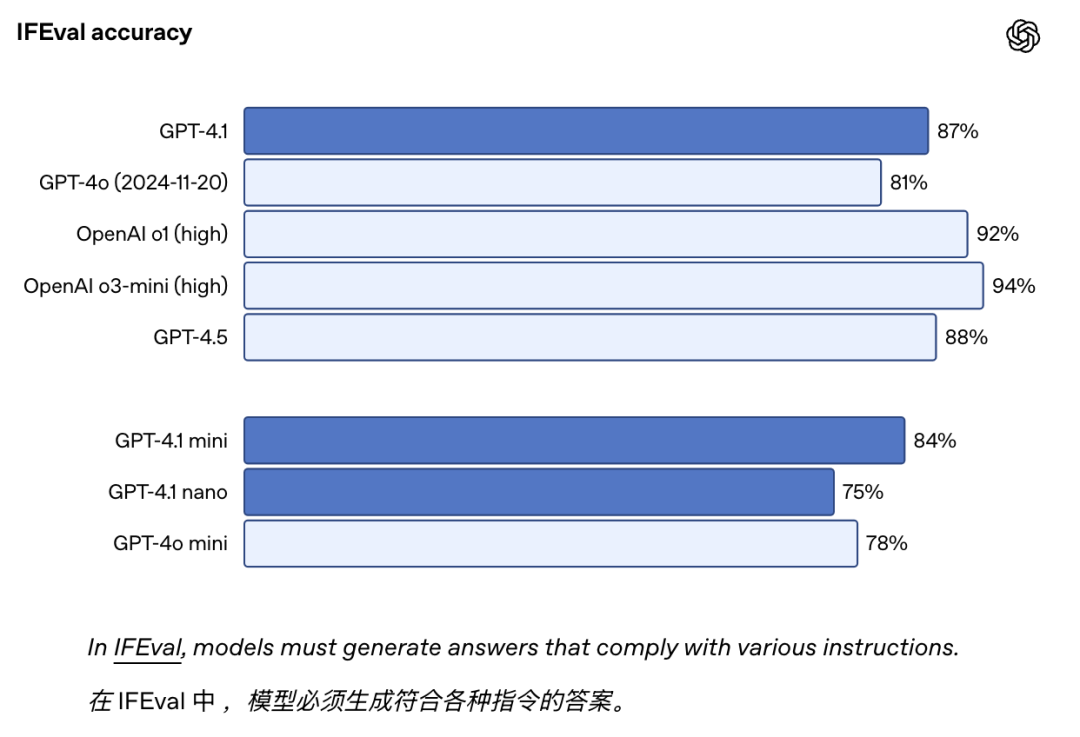

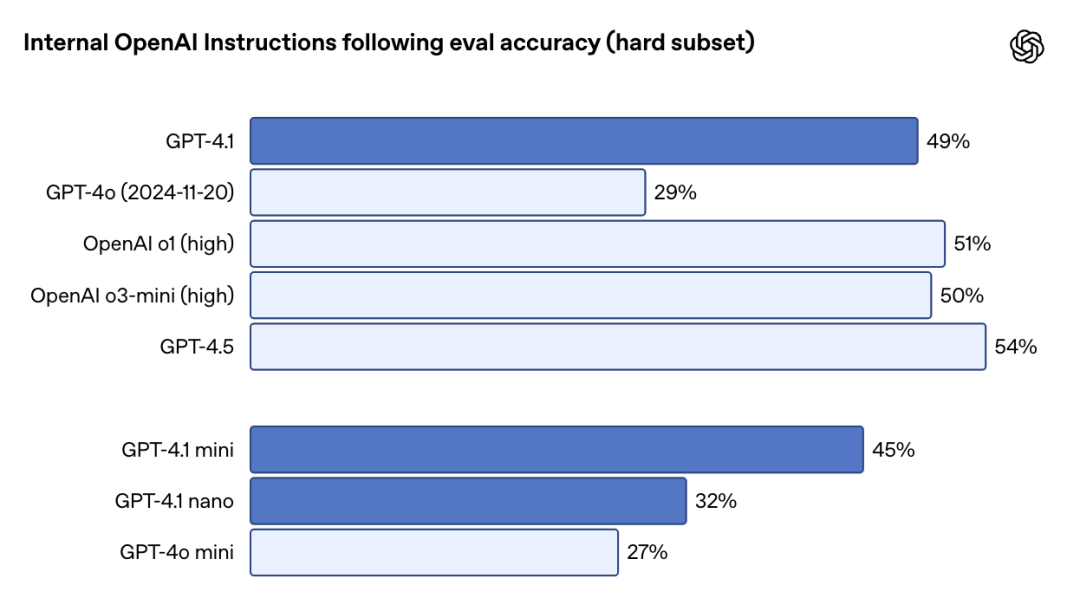

指令遵循更可靠:在评估复杂指令遵循能力的Scale's MultiChallenge基准上,GPT-4.1得分38.3%,比GPT-4o绝对提升10.5%。这意味着它更能理解并执行你的复杂要求,尤其是在多轮对话中,能更好地追踪上下文信息

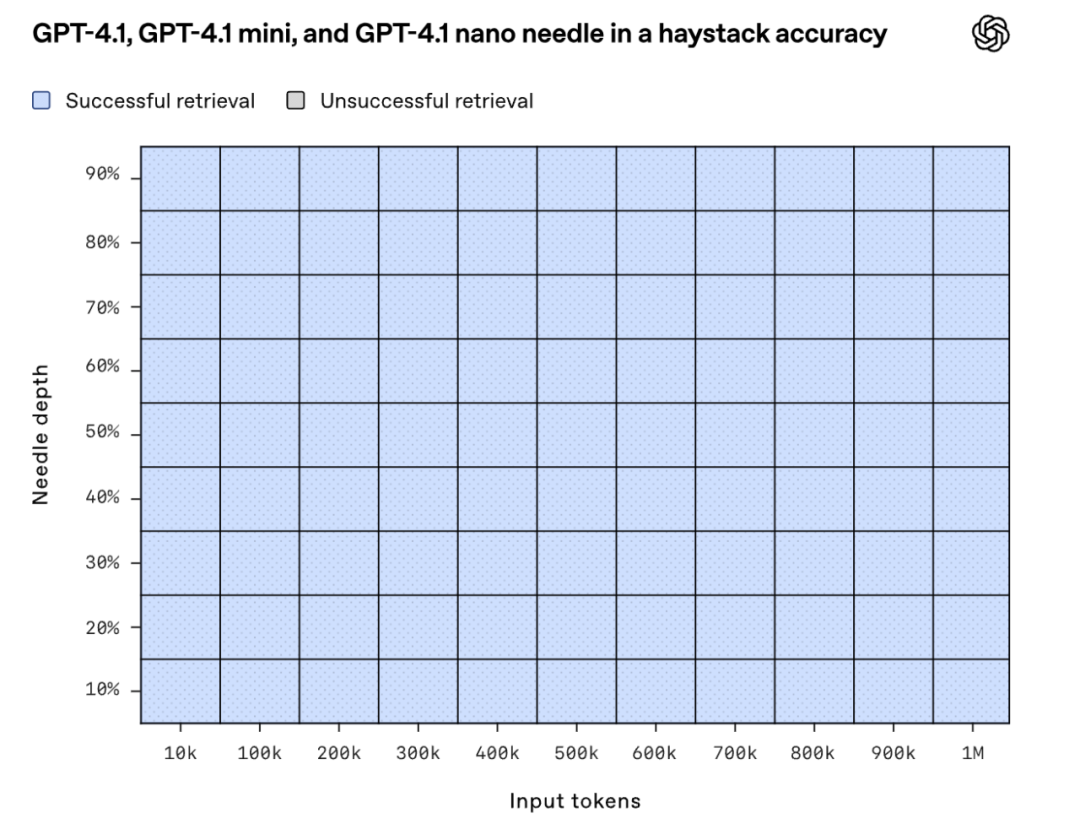

百万级Token上下文窗口:全系列(包括mini和nano)都支持高达100万Token的上下文窗口(之前GPT-4o是12.8万),处理超长文档、代码库不再是难题。而且,不是简单加长,长文本理解能力也同步增强,"大海捞针"测试(Needle in a Haystack)在100万Token范围内各位置都能精准找回信息

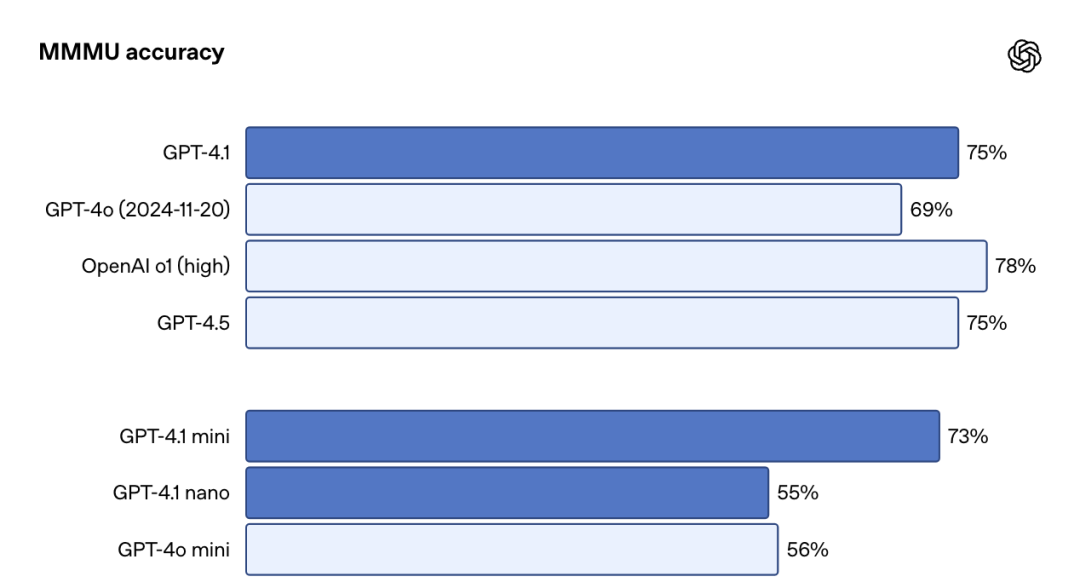

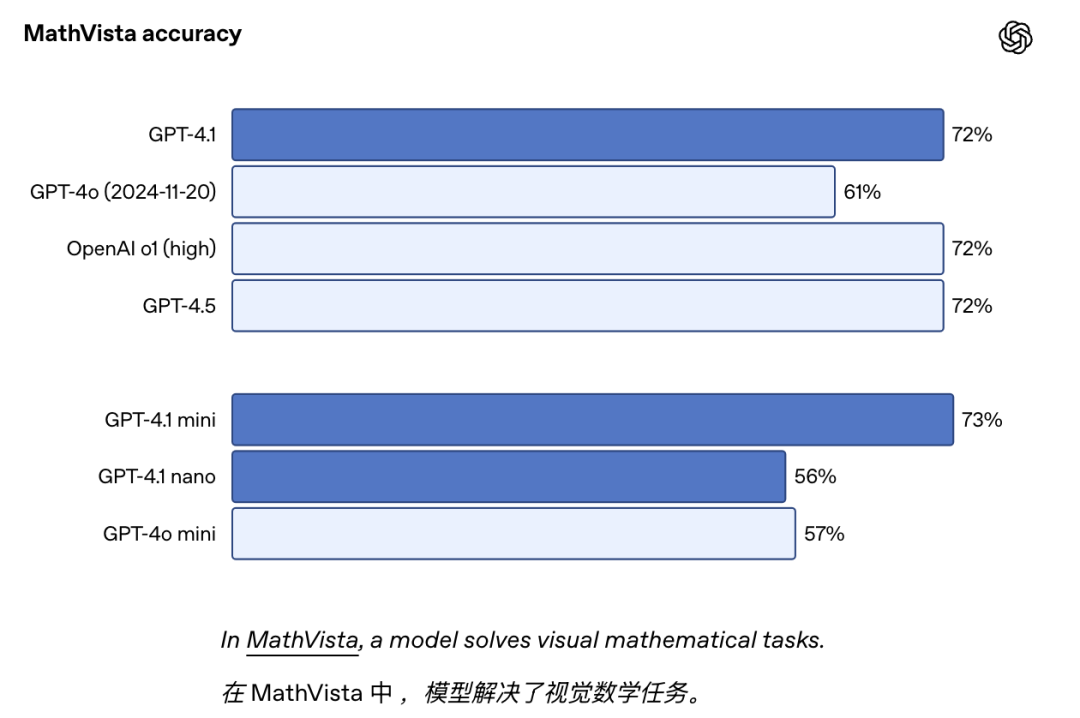

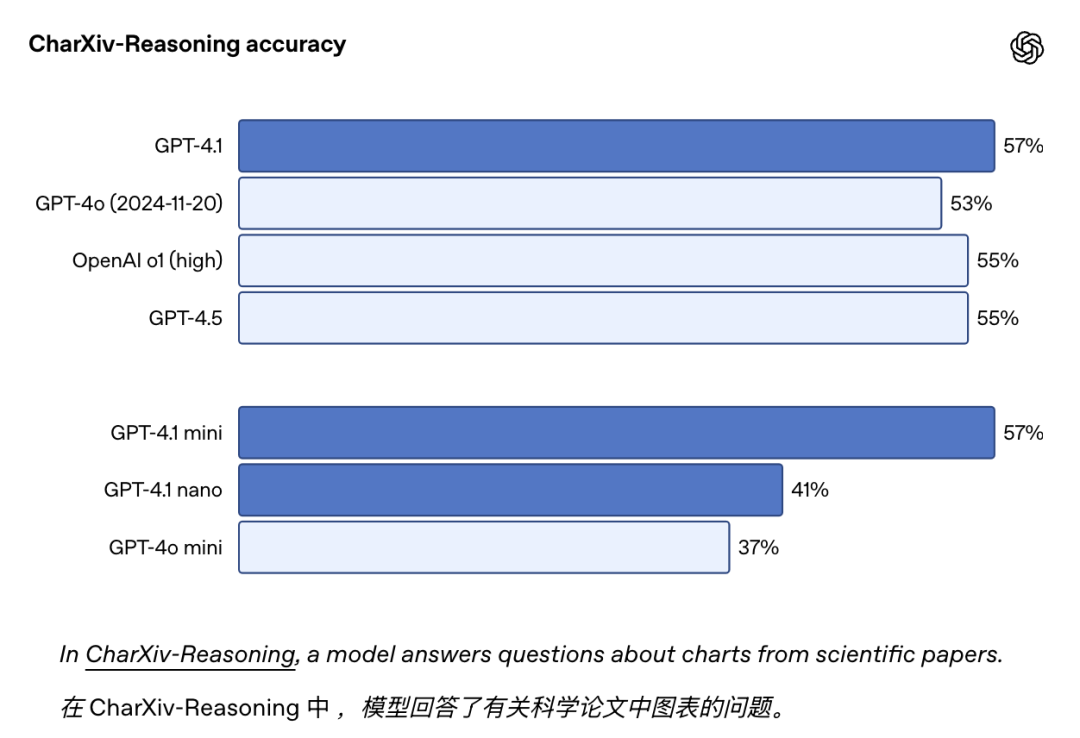

视觉理解新SOTA:GPT-4.1 系列在图像理解方面非常强大,尤其是 GPT-4.1 mini 代表了重大的飞跃

在 MMMU 中 ,模型可以回答包含图表、示意图、地图等复杂图像问题

在数学视觉任务中也很强大

解决科学论文中的图表能力表现:

在Video-MME(无字幕长视频理解)基准上,GPT-4.1取得了72.0% 的成绩,比GPT-4o提升了6.7%,创下新纪录

知识更新:知识库截止日期更新到了2024年6月

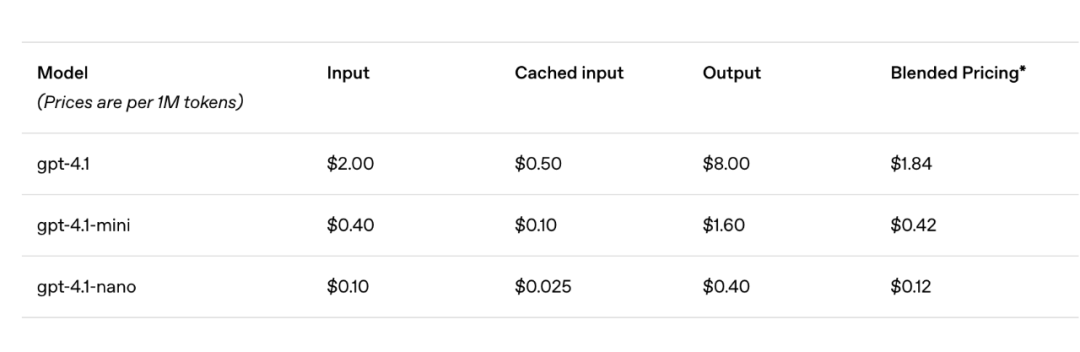

使用成本

|

|

|

|

|

|

| gpt-4.1 |

|

|

|

$1.84 |

| gpt-4.1-mini |

|

|

|

$0.42 |

| gpt-4.1-nano |

|

|

|

$0.12 |

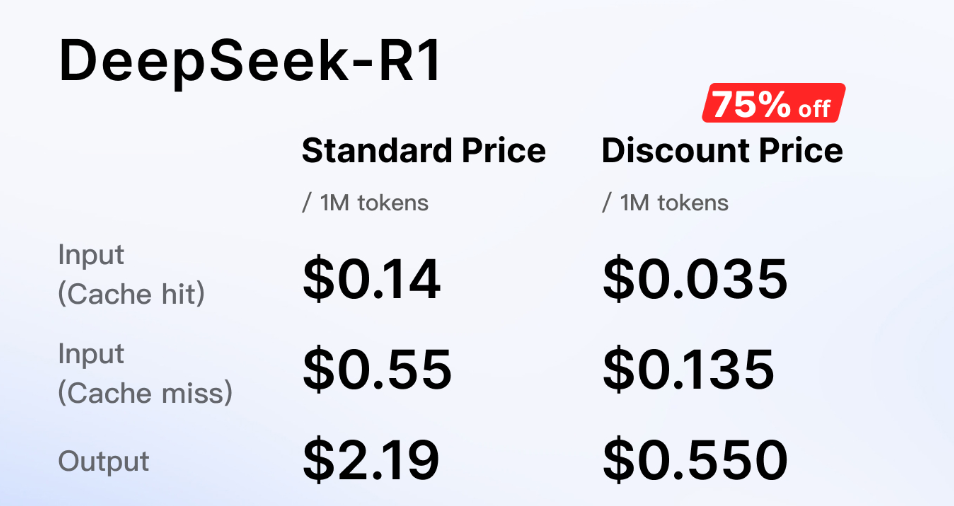

Nano 已经比deepseek R1的价格还要便宜了

*基于典型输入/输出和缓存比例估算

-

• GPT-4.1比GPT-4o中位数查询便宜26% -

• Nano模型价格极具竞争力 -

• 重复上下文的提示缓存(Prompt Caching)折扣提高到75%(原为50%) -

• 长上下文请求不额外收费 -

• Batch API调用还有额外**50%**的折扣

一些细节

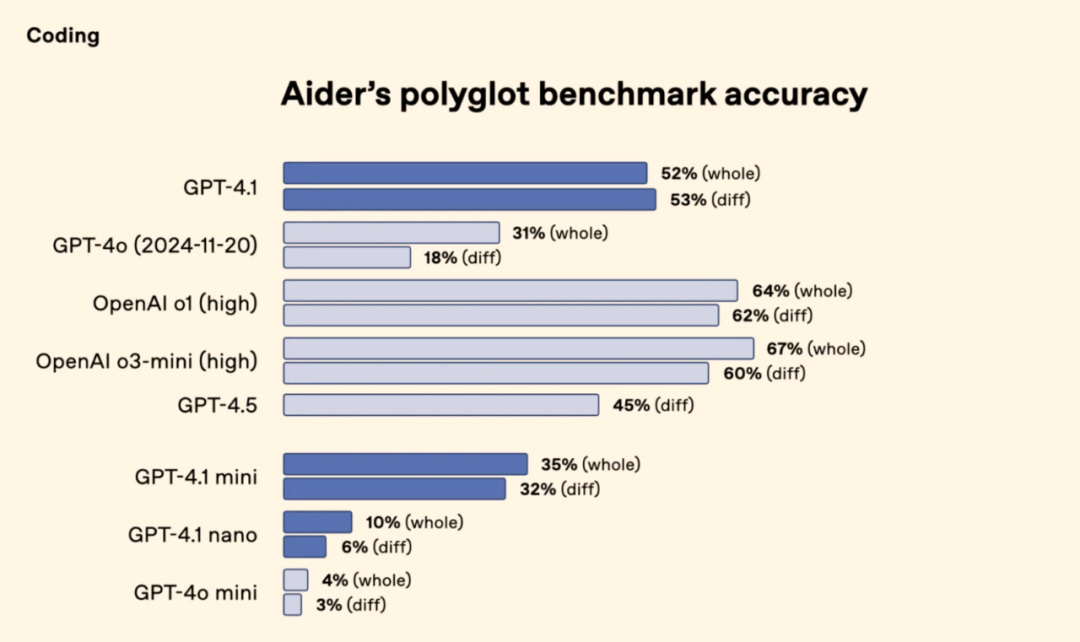

代码 (Coding):

除了SWE-bench,在Aider的polyglot diff基准上,GPT-4.1分数是GPT-4o的两倍多,甚至比GPT-4.5高8%,尤其擅长生成可靠的代码差异(diff format),节省token和延迟

前端代码生成能力显著增强,更美观实用,80%的情况下人类评分员更喜欢GPT-4.1生成的网站。

更少出现无关代码编辑(内部评估从9%降至2%)

真实案例:Windsurf测试中得分比GPT-4o高60%;Qodo代码评审测试中55%情况下优于其他模型

指令遵循 (Instruction Following):

在格式遵循(XML, YAML等)、否定指令、顺序指令、内容要求、排序、避免过度自信等方面都有改进,尤其擅长处理困难提示

多轮对话能力增强,能更好地利用历史信息。

注意:模型可能更“字面化”理解指令,建议提示词写得更明确、具体

真实案例:Blue J税务场景准确率提升53%;Hex SQL生成改进近2倍,减少手动调试

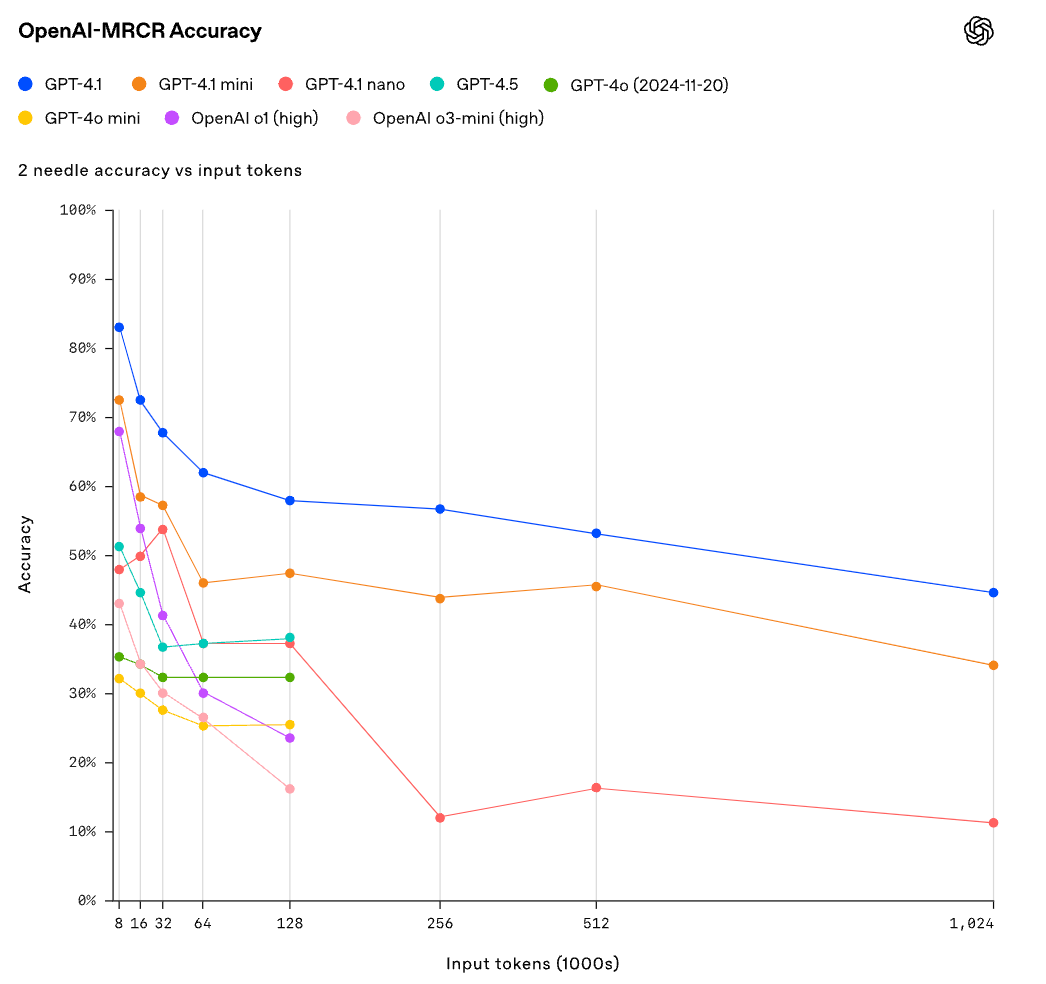

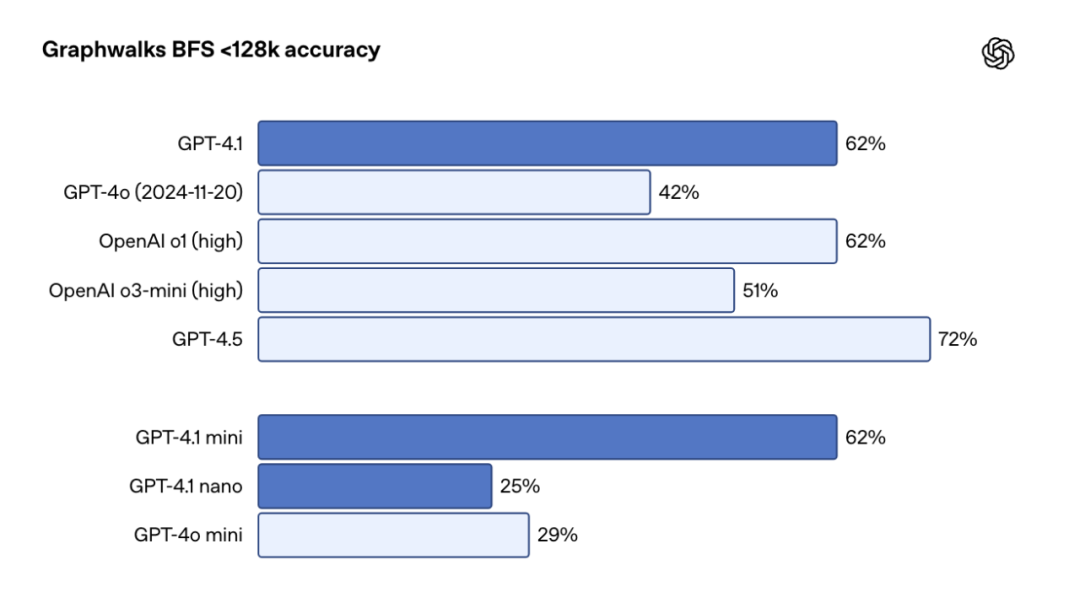

长上下文 (Long Context):

100万Token相当于8倍React完整代码库的大小

不仅能“大海捞针”,还能处理更复杂的长文本任务。OpenAI开源了两个新评测集:OpenAI-MRCR(多轮指代消解,测试在长文本中区分多个相似信息点的能力)

和Graphwalks(多跳推理,模拟代码库跳转或文档交叉引用)。GPT-4.1在这些任务上表现优异

真实案例:Thomson Reuters在CoCounsel法律助手中,多文档审阅准确率提升17%;Carlyle在处理复杂金融文档(PDF, Excel)时,检索性能提升50%,克服了以往模型的局限。

延迟:GPT-4.1在12.8万Token输入时,首个Token响应时间(p95)约15秒,百万Token时可能达半分钟;Nano在12.8万输入时,通常5秒内返回首个Token

写在最后

OpenAI把4.1模型比作类星体,不得不说,这炒作能力还是很高的

另外,

ChatGPT中的GPT-4o会逐步融合这些改进,但不是直接升级到GPT-4.1

GPT-4.5 Preview即将下线:由于GPT-4.1在性能、成本、延迟上更有优势,GPT-4.5 Preview(作为研究预览版发布)将在2025年7月14日正式关闭,开发者有三个月过渡时间。OpenAI表示会将其优点(创意、写作质量等)融入未来的API模型

个人感觉4.1这个模型更多的是在工程能力的细节处进行了非常扎实的改进

参考:

https://openai.com/index/gpt-4-1/

⭐星标AI寒武纪,好内容不错过⭐

用你的赞和在看告诉我~

转载请注明:OpenAI推出首个Nano模型:GPT-4.1 ,百万上下文、代码能力大幅超越GPT4.5 | AI工具大全&导航