点击

“

?²·ℙarad?g?智能平方范式研究:书写解构智能,范式提升认知

AI agents 是由大型语言模型(LLM)驱动的行动体,但 LLM 的核心能力在于生成 token,类似于一个“语言的缸中之脑”——它不具备外部感知或与真实世界直接交互的能力,也没有内生的意志或自发的动机。因此,在当前技术阶段,AI agents 的行动动机仍然依赖于人类通过指令、提示(prompt)或任务定义来提供。

为了让 LLM 能够完成具体任务,我们需要为其构建一个“脚手架agent framework”,集成工具使用(tool use)、记忆(memory)等功能,以提供运行环境和外部支持。

Workflow 和 API 编排 是两种常见的脚手架实现方式,用于将 LLM 的文本输出转化为可执行的行动。两者的主要区别在于设计灵活性:

• Workflow:通常采用预定义的、确定性的步骤序列,适用于固定的、流程化的任务。

• API 编排:支持更动态的工具调用,适合需要灵活决策和适应的复杂场景。

LLM 的“智能”(即其 token 生成能力)在这些系统中至关重要,它通过生成文本指令来指导行动。然而,行动动机的完整性和执行效果更多取决于人类设定的任务目标以及脚手架的设计,而非 LLM 自身是否能独立“理解”或“描述”动机。

未来,AI agents 的功能需要逐步内化,以减少对外部脚手架的依赖,从而提升效率和一致性。通过强化学习(RL)等技术,LLM 可以逐步在 token 生成过程中自然融入工具调用或记忆请求,使其行为更接近自主行动。例如:

• ReACT:通过提示(prompt)引导 LLM 在思考和行动之间切换,灵活且易于实现,适合快速部署。

• ReTool 和 ReSearch:通过 RL 将工具使用和搜索策略内化为模型的生成模式,显著提升特定任务的性能。

当前阶段,脚手架仍是不可或缺的,它不仅为 LLM 提供运行环境,还负责解析和执行 LLM 的输出,并将外部反馈整合回系统。未来,随着 RL 和模型微调(fine-tuning)技术的进步,部分脚手架功能有望内化到 LLM 中,但实现完全自主的 AI agents 仍需更多技术突破。脚手架的核心作用在于弥补 LLM 的局限,确保其输出在复杂任务中得以有效执行,以及OpenAI强调的安全护栏作用。

引言

LLM 只是语言的“缸中之脑”,它真的能成为有动机的 Agent 吗?

正文

△

01 | LLM 的局限:它只是个生成器

我们必须承认,大语言模型(LLM)目前仍是一种“条件 token 生成器”。它通过训练学会在给定上下文下预测下一个词,表现出某种“智慧”,但本质上:

-

它没有“意志”——不会自己决定该干什么;

-

它没有“目标”——也不真正知道什么是“成功”;

-

它的“智能”只是在人类设计的 prompt、提示模板中被动发挥作用。

这种“缸中之脑”般的智能,无法真正自主行动。于是,我们才需要为它搭建“Agent 脚手架”:提供行动工具(Tool Use)、记忆系统(Memory)、状态反馈机制(Observations),再通过强化学习(RL)让它学会何时使用什么工具、如何达成既定目标。

这就是 ReAct、ReTool、ReSearch 等 Agent 框架方法论正在做的事:将语言模型的 token 生成能力,延展到连续行动和问题求解的空间。

LangChain 在其博客中指出,“Agent 的关键不是工具有多强,而是 LLM 能不能理解并描述任务目标,并据此动态组织行为。”;OpenAI 在其构建指南中,则提出“Agent 是模型 + 工具 + 指令”的系统性组合;Anthropic 更是将“Agentic Systems”定义为智能体在环境中主动调度工具、维持记忆和目标导向行为的整体能力。

但这些努力,仍局限在语言生成驱动的框架中:LLM 在 prompt 里“想”,调度工具“做”,得到反馈再“接着想”——它们都是“语言封闭空间”里的模拟行动。

那么,下一步呢?我们需要的是“体验时代的 Agent”。

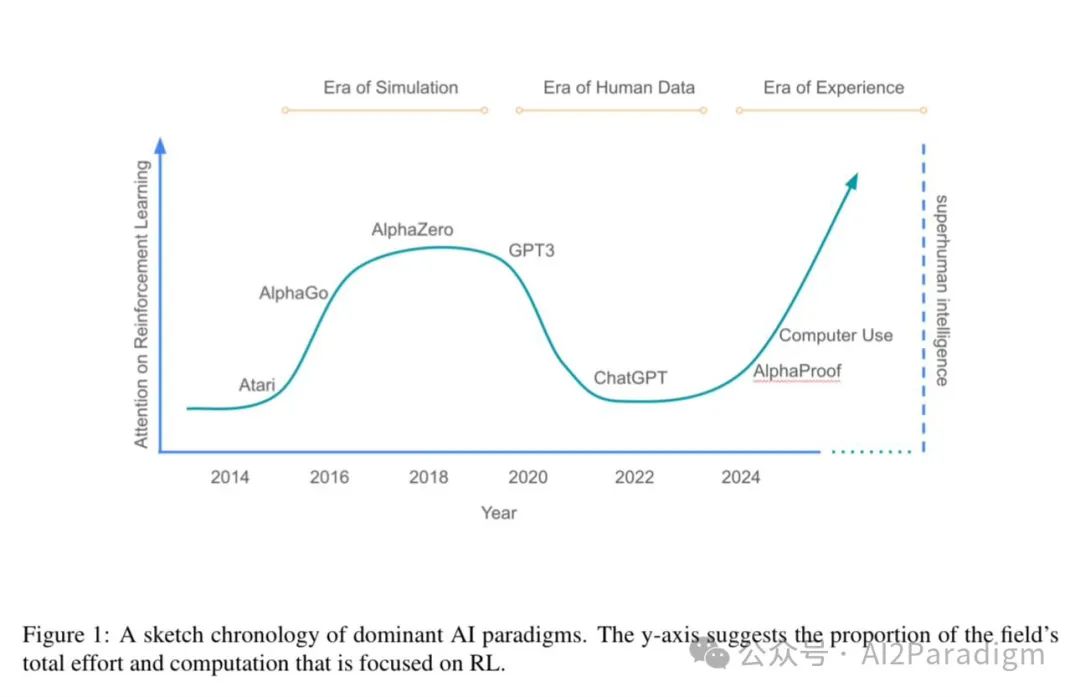

正如 Sutton 和 Silver 在《The Era of Experience》中所提出的观点:

“人类数据正在枯竭,未来智能的进步,必须依赖 Agent 与环境的交互经验。”

他们主张一种以“体验流(stream of experience)”为核心的智能范式:Agent 不再只是响应 prompt,而是拥有持续存在的状态、长期的环境交互、动态的目标演化与自我调整能力。这正是体验智能(Experiential Intelligence)所描绘的蓝图。

而这也与姚顺雨在《The Second Half》中所提出的转向惊人契合:

“AI上半场是做模型、benchmark打榜,下半场是思考 AI 到底要干嘛,我们该如何评估它真正的‘价值’。”

过去我们热衷在标准 benchmark 上刷分,如今我们需要构建新的评测逻辑、新的问题定义,让 Agent 在真实任务中证明自己。

03 | 新范式的交汇:从能力提升,到效用对齐

我们看到一个转向正在发生:

-

从静态编排 → 动态感知与行动:LLM 不再仅是语言调度员,而是在环境中持续适应与优化的主动体;

-

从 prompt 激活 → 策略内化:Agent 不只是被动响应,而是通过强化学习、行为奖惩、长期经验,生成自主行为策略;

-

从人类数据 → 自生成经验:真正的智能突破,不在于记住所有人类知识,而在于从失败和交互中学习。

这场范式转变,不仅是工程实践的升级,更是对“智能本质”的一次深刻追问:

什么样的 Agent,才配称为“智能”? 它是否需要欲望、目标和记忆? 我们是否应该设计一个“经验激发、长期成长”的学习机制? 而人类,又是否愿意赋予它这样的自由?

04 | 启发与呼吁:定义 Agent 的“下半场”

或许,我们可以提出这样一种洞见:

AI Agent 的未来,不在于 prompt 多强、工具多炫,而在于它是否能自主生成经验、建立世界模型、追求长期效用。

这需要两件事:

-

技术层面,脚手架系统必须从“功能拼图”演进为“认知协同系统”;

-

评估层面,我们必须从“单轮回答的准确性”,转向“多轮协作的有效性”“长期目标的达成度”“与人互动的适配度”。

ReAct 是第一步,ReTool 是第二步,而“Experience Agent”将是第三步。

结语

你觉得智能体需要“经验”才能真正变得聪明吗?

你是否期待一个可以成长、适应、与你共谋未来的数字同伴?

欢迎在评论区聊聊你的看法,点个“在看”,转发给正在探索 Agent 架构的朋友。

我们正站在 AI 智能演化的关键分岔口,每一个视角,都可能点亮新方向。

-相关?文及视频

-Sutton&Silver : "Welcome to the Era of Experience"

-Shunyu Yao: "The Second Half" (https://ysymyth.github.io/The-Second-Half/)

附录:?²·ℙarad?g?智能平方范式研究

A?:Artifical Intelligence [LLM@ANN]

?²:H? ? A? [bio- | silico-]

ℙarad?g?:认知范式或BNN认知大模型

A?与H?当前在玩一个语言游戏。A?最大的问题是已知一点白 外的未知的黑;H?最大的问题是不断演进的sys2理性白中的sys1的黑

外的未知的黑;H?最大的问题是不断演进的sys2理性白中的sys1的黑 。

。

往期推荐

AI平方范式智库·语言访谈系列:理解AI,还需补上语言本质这一课

AI平方范式智库·数学系列E03S01 | 神经网络背后的数学

AI平方范式智库·认知构建路径 | A?²ℙarad?g? V4商业新范式解读

扫码加群,

链接智库!

AI平方范式智库