这就需要一种方法把各种工具和助手整合到一起。MCP就是这样一种方案,它让AI能够更好地理解上下文,记住之前的对话,并且在需要的时候调用不同的工具。

设想一下,倘若你的手机、电脑与耳机仅需一根USB-C线便能实现无缝对接,生活将变得何等便捷?而今,这一理念正被移植到人工智能的领域——MCP(Model Context Protocol,模型上下文协议)正是承载这一愿景的使者。

简单说,MCP就像是AI的"大脑中枢",帮助它协调各种能力,让原本只会单打独斗的模型变成了能处理复杂任务的协作团队。今天这篇文章给朋友们介绍这个最近特别火的技术:MCP。

01

—

什么是模型上下文协议

MCP(模型上下文协议)是一种大模型时代出现的开放协议,旨在标准化应用程序向大型语言模型 (LLMs) 提供上下文(数据)的方式。

模型上下文协议(MCP)是 Anthropic 推出的开放标准,旨在通过统一的客户端-服务器架构解决 LLM 应用与数据源连接的难题。它支持通过同一协议访问本地资源(如数据库、文件)和远程资源(如 Slack、GitHub API),无需定制集成。

MCP 可公开工具和交互模板,且内置安全性,确保资源由服务器完全掌控。

目前 MCP 支持本地运行,未来将引入企业级认证的远程支持,实现团队间的安全共享。通过桌面应用(Anthropic 提供),开发者可在短时间内集成 MCP,快速将大模型 Claude 连接上多种数据源,推动 AI 集成的标准化发展。

02

—

MCP架构

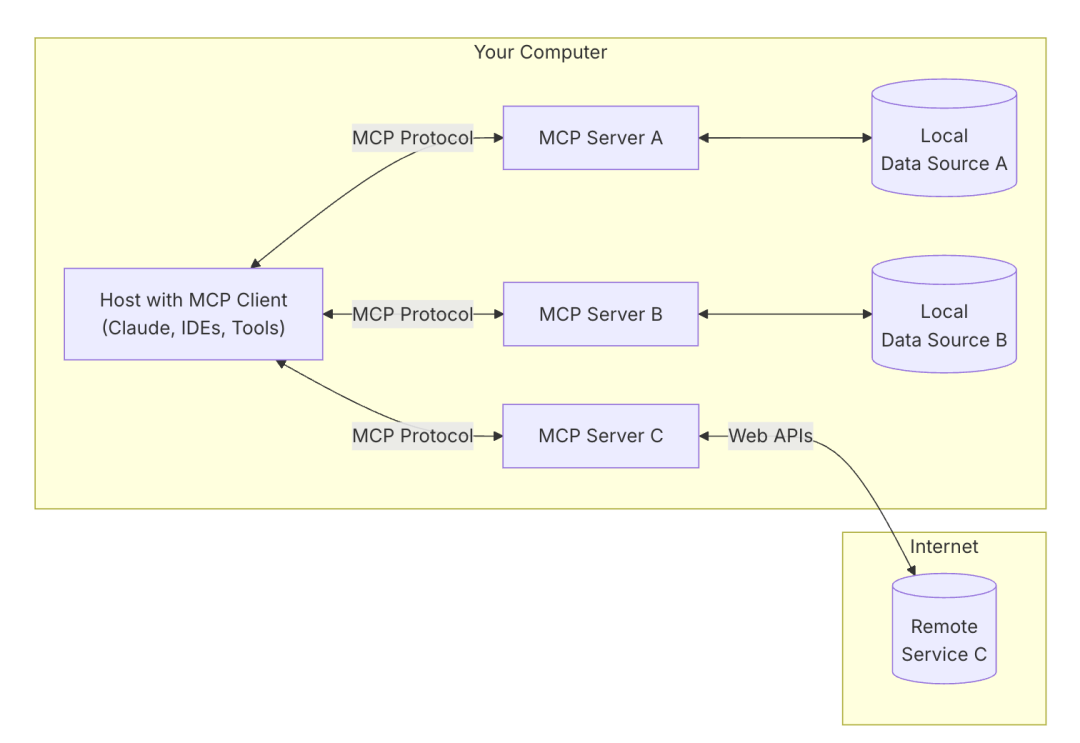

MCP 遵循客户端-服务器架构(client-server),其中包含以下几个核心概念:

MCP 主机(MCP Hosts):发起请求的 LLM 应用程序(例如 Claude Desktop、IDE 或 AI 工具)。

MCP 客户端(MCP Clients):在主机程序内部,与 MCP server 保持 1:1 的连接。

MCP 服务器(MCP Servers):为 MCP client 提供上下文、工具和 prompt 信息。

本地资源(Local Resources):本地计算机中可供 MCP server 安全访问的资源(例如文件、数据库)。

远程资源(Remote Resources):MCP server 可以连接到的远程资源(例如通过 API)。

如下图:

MCP client

MCP client 充当 LLM 和 MCP server 之间的桥梁,MCP client 的工作流程如下:

-

MCP client 首先从 MCP server 获取可用的工具列表。

-

将用户的查询连同工具描述通过 function calling 一起发送给 LLM。

-

LLM 决定是否需要使用工具以及使用哪些工具。

-

如果需要使用工具,MCP client 会通过 MCP server 执行相应的工具调用。

-

工具调用的结果会被发送回 LLM。

-

LLM 基于所有信息生成自然语言响应。

-

最后将响应展示给用户。

我们可以在 Example Clients 找到当前支持 MCP 协议的客户端程序。

目前使用 Claude Desktop 作为 MCP client

下载地址:https://claude.ai/download 。

MCP Server

MCP server 是 MCP 架构中的关键组件,它可以提供 3 种主要类型的功能:

1、资源(Resources):类似文件的数据,可以被客户端读取,如 API 响应或文件内容。

2、工具(Tools):可以被 LLM 调用的函数(需要用户批准)。

3、提示(Prompts):预先编写的模板,帮助用户完成特定任务。

这些功能使 MCP server 能够为 AI 应用提供丰富的上下文信息和操作能力,从而增强 LLM 的实用性和灵活性。

在 MCP Servers Repository 和 Awesome MCP Servers 这两个 repo 中有许多由社区实现的 MCP server。

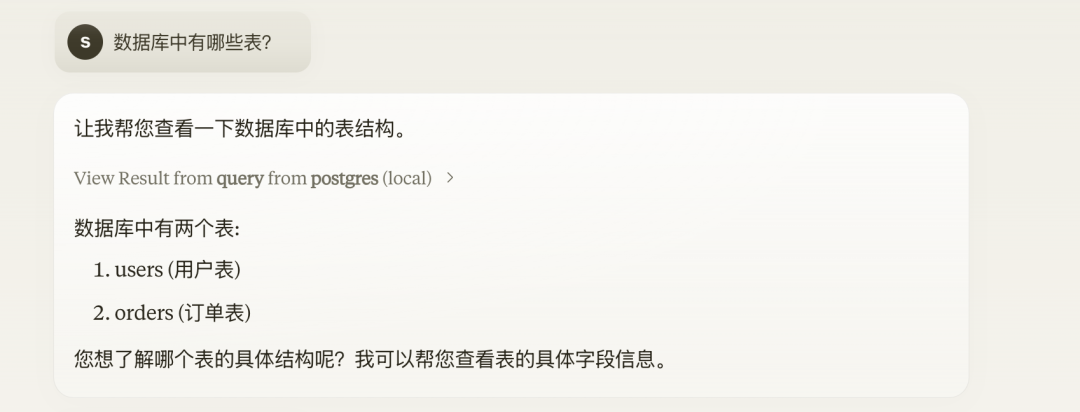

例如,这是一个 PostgreSQL MCP Server 工具,可以让大模型能够基于 PostgreSQL 中的数据来回答问题。

比如下面的问题,大模型 Claude 一开始是不知道数据库中的表结构的,因此先发送请求分别确定 orders 表和 users 表中相应的字段,然后再对两张表进行 join 查询。

MCP 官网:https://modelcontextprotocol.io

MCP GitHub:https://github.com/modelcontextprotocol

本机 MCP 服务支持:通过 Claude 桌面应用快速实现本地化数据连接,应用安装地址:https://claude.ai/download。

开源服务代码库:包含 Google Drive、Slack、GitHub 等流行系统的预构建实现,便于直接部署和测试。

https://github.com/modelcontextprotocol/servers。

03

—

MCP 和 API

为什么选择MCP,而非传统API?

如果使用API让大模型与外部工具对接,开发者需要为每个API编写独立的代码,包括文档解析、认证方式、错误处理和后期维护,费时又费力。

MCP更像一把“万能钥匙”:

单一协议:接入MCP一次,就能连接多个工具和服务,不用为每个API单独操心。

动态发现:AI模型可以自动识别并与可用工具交互,无需提前硬编码。

双向通信:类似WebSocket,MCP支持实时、双向的数据流动,AI既能获取信息,也能触发行动。

双向通信的好处:

拉取数据:AI可以查询服务器,比如检查你的日历安排。

触发行动:AI可以直接操作,比如重新安排会议或发送邮件。

相比之下,传统API更像单向的“对话”,缺乏MCP这种灵活性和实时性。

MCP 对比 API 特性差异如下图:

04

—

MCP的重要性

1.实现模块化、可扩展的人工智能系统

人工智能面临的最大挑战之一是设计既灵活又可扩展的系统。MCP 有助于将单片人工智能架构分解为模块化组件。通过分离模型、上下文和协议,开发人员可以:

-

在不破坏整个系统的情况下更换不同的 AI 模型。

-

动态地引入新的上下文(例如,使 NLP 模型适应新的语言或行业)。

-

为 AI 模型编排定义强大的协议。

2. 解决数据工程挑战

对于数据工程师来说,MCP 提供了一个有效处理数据管道的框架。

-

模型:定义数据的结构和转换方式。

-

上下文:处理运行时参数、环境设置和版本控制。

-

协议:管理存储层、处理框架和机器学习工作流之间的数据移动。

3. 增强软件设计模式

MCP 符合众所周知的软件架构原则,例如:

-

模型-视图-控制器 (MVC):MCP 通过引入Context作为动态影响模型的显式组件来扩展 MVC 的逻辑。

-

事件驱动架构:MCP 支持基于事件流的实时上下文更新,使其适用于物联网、金融交易和推荐引擎。

-

微服务通信: MCP 中的协议确保微服务驱动的应用程序中强大的通信。

4. 构建自适应人工智能代理

在多智能体 AI 系统中,MCP 为智能体交互提供了一种结构化方法:

-

模型:定义代理决策。

-

背景:跟踪环境变化。

-

协议:建立代理到代理以及代理到人类的通信。

MCP不只是一个简单的协议,不仅仅是一种架构模式,它还是设计 AI 驱动应用程序和分布式系统时一种强大的思维转变。通过有效地分离模型、上下文和协议,组织可以构建自适应、可扩展且可维护的软件解决方案。

它是AI和工具沟通的“新基础”,给AI提供了一个统一、标准的方法,让AI能灵活地连接外部的数据和工具。和以前需要手动设置的API不同,MCP更像是一个智能框架,让AI能更好地理解上下文,并且有更强的互动能力。

随着人工智能不断与企业系统融合,了解 MCP 对于希望确保其应用程序面向未来的开发人员、工程师和架构师来说至关重要。

参考链接:

https://mp.weixin.qq.com/s/rcOi7e8F5qGVVF2noCk46Q

https://mp.weixin.qq.com/s/ASmcjW53HKokdYt1m-xyXA

https://www.linkedin.com/pulse/model-context-protocol-mcp-ai-software-development-piyush-ranjan-dxj0e/

往期热门文章推荐:

Manus 爆火出圈后|25年什么样的 Agent 会脱颖而出:简单胜于复杂

不要盲目再使用DeepSeek R1和QWQ这些推理模型做RAG了

不只有Manus!免邀请码的 flowith 和三个开源项目:GWL、OpenHands、browser-use

一文看懂Manus:实测体验+开源复刻方案,无需等待邀请码

聊一聊五种智能体模式

心法利器[129] | deepseek-R1自测效果分析和选择建议